2月21、22日に開催されたイベント「CNET Japan Live 2017 ビジネスに必須となるA.Iの可能性」では、企業における先進的な人工知能(AI)の活用事例を紹介したり、今後のビジネスでAIがどう必要不可欠になるかを解説したりする多彩な講演が催された。

今回は、朝日新聞社 メディアラボ 主査の田森秀明氏と、レトリバ 取締役 兼 リサーチャーの西鳥羽二郎氏による講演「メディアと人工知能=自然言語処理研究への取り組み」の概要を取り上げる。前半は、田森氏が朝日新聞社でAI研究などを手がけるメディアラボの活動内容を紹介。後半は、西鳥羽氏がAIの具体的な活用例として、レトリバのコールセンター向けソリューション「AnswerFinder」「VoC Analyzer」で得られた成果を解説した。

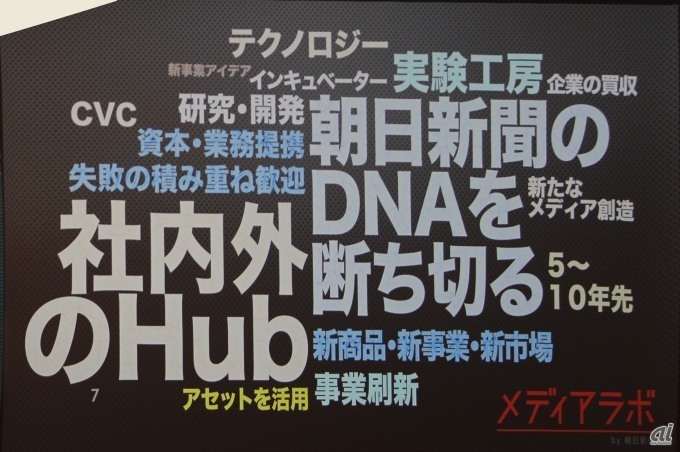

田森氏は、毎日記事を制作し、紙に印刷して販売する新聞事業は、現在下り坂にあるとした。そんな状況を打開し、メディア企業の枠にとらわれない新規事業の開発を目的として、朝日新聞社は2013年6月にメディアラボを開設した。

メディアラボは新しい商品やビジネスの開発を目指す「実験室」であり、失敗をおそれずに挑戦を繰り返すための実験工房としてこれまで活動してきた。研究が主業務でない企業がAIを研究しているわけだが、今はAIツールが揃っていて、一般企業も研究できる環境になったという。こうした背景から田森氏は、メディアラボ開設からの3年間で挙げた成果と課題を示し、AI研究を進める会社の参考にしてもらいたい、と話した。

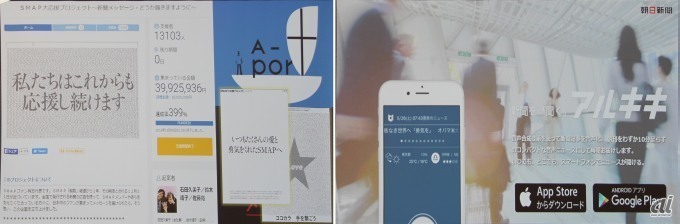

メディアラボの活動内容は、「新規事業開発」「出資・投資」「研究・開発」の3本柱。新規事業開発の分野では、2016年に話題となったアイドルグループ「SMAP」のファンによる新聞への全面広告掲載を実現させたクラウドファンディング事業、ニュース読み上げアプリ「アルキキ」の提供、といった実績を上げている。出資・投資事業は、現時点で国内外の16社程度を支援しており、今後ベンチャーキャピタルを立ち上げる計画という。

研究・開発は、仮想現実(VR)、拡張現実(AR)、複合現実(MR)、そして本講演の主題であるAIに取り組んでいる。ARについては、新聞の紙面を撮影して各種コンテンツを提供するスマートフォン用アプリ「朝日コネクト」、新聞紙で作ったVRゴーグルなどの成果物がある。

一口にAIといっても多種多様な分野に分かれるが、メディアラボは朝日新聞社が「毎日日本語を生産している企業」なので、ラボ創設当初から自然言語処理を研究してきた。課題としては、自然言語処理で社内の問題解決を目指すこと、社内エンジニアの技術力向上を図ることを挙げ、将来は研究者や技術者が入社するような企業になれば、と考えた。ただし、メディアラボのメンバーは全員が自然言語処理の未経験者であったため、東北大学の乾・岡崎研究室(教授:乾健太郎氏、准教授:岡崎直観氏)とアドバイザリー契約を締結し、AI研究を「イチから」始めたそうだ。

1年目の活動は、オンラインニュースサイト「朝日新聞デジタル」を対象とする、関連記事リコメンデーションエンジンとリンク自動生成機能の開発。

これまでも関連記事は自動的にピックアップしていたが、どうしても不適切な記事が提案されるため、手動で修正する必要があった。そこで、メディアラボは蓄積された修正データを機械学習システムに読み込ませ、AIによる提案修正を試みた。その結果、7割の正解率で「手動でつけ直した記事」を選べるようになったという。

リンク自動生成は、記事原稿に登場する「○×面に続く」「○×面から続く」というテキスト部分に対し、該当する記事へのリンクを自動的に設ける機能。朝日新聞デジタルには紙面用の記事原稿データから変換した記事を掲載しているが、紙面データには当然リンク先記事の情報が付加されていないため、リンクを設定できない。

そのため、まず記事を解析して各記事の類似度を推測させ、リンク先となる記事のIDを提案するシステムを開発した。このシステムを使ったところ、9割以上の正解率でリンク生成に成功した。

イチから始めたAI研究だったが、実践することで文献を読み、ツールを使えるというレベルに達した。また、利用可能なデータが社内にあることも分かった。

その一方、AIで現状の問題を改善できる技術を開発しても、稼働中の現行システムに組み込むことは難しく、実際には活用できない。新規事業関連の業務と研究活動を兼任でこなすため、思うように作業できない点も課題だった。

2年目は、田森氏が海外留学したこともあり、人員不足で研究をあまり進められなかったそうだ。そんな状況でも、Twitterの投稿データ分析システムの開発に取り組んだ。

ところが、分析の対象となるツイートデータは高価で入手しにくいという。さらに、Twitterから提供されているAPIの仕様変更で、ツイート数が取得できなくなった問題もある。そこで、ツイートを取得して解析できるツール「Hayatter」を自作した。

この活動を通じ、言語処理のコツが少しずつ分かってきたが、やはり他業務との掛け持ちだと研究が進まないという課題は解消されなかった。

3年目は、まず基礎研究の重要性を上司に理解してもらい、研究専属の人員を2人確保した。これにより、研究リソースの問題を解決させた。

その上で、フェイクニュースなどで注目された報道の品質に関係し、記事の「クオリティ・信頼性」を向上させる技術を研究した。

具体的には、記事原稿にデスクがどのような修正を施すかのデータを収集し、ディープラーニング(深層学習)を応用して人間の記事修正をまねる自動校正エンジンを作った。同音異義語や固有名詞の間違いを正しく直せたほか、従来のルールベースの校正エンジンでは難しかった、助詞の修正、ほかの名詞への代替提案といった修正の自動化が可能になった。

未経験者がAIと格闘した3年間だったが、これで他社に頼ることなく、社内の技術者だけでもAI研究できる体制を整えられた。同時に課題もクリアになり、成果をどう社内に還元するか、問題設定をいかに効率良くするか、データをどう集めるかという問題も見えた。

今後の活動については、特許出願や学会発表、製品化、データ提供などのアウトプット、他社との共同研究などを通じたオープンイノベーション、自然言語処理に長けた人材の確保に取り組みたいとした。

なお、田森氏はメディア企業として今後もAI研究を進めていくべきか、それとも得意な他社に任せた方がいいのかを考え、「撤退ライン」を意識していると述べた。そして、問題解決にAI(機械学習)は有用だが、ツールの1つに過ぎない、という点も強調していた。そもそも研究が主力事業でない企業がAIに取り組む際は、この点を念頭に置いて活動することが重要だろう。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する