筆者は先日、夕食に何を作ろうかと頭を悩ませていた。そこで、冷蔵庫を開けて、「iPhone 16」の「カメラコントロール」ボタンで写真を撮影し、その画像を「ChatGPT」と「Google」にアップロードした。

スマートフォンカメラは次世代のバーチャルアシスタントへの入り口となる可能性がある

スマートフォンカメラは次世代のバーチャルアシスタントへの入り口となる可能性がある2つのバーチャルアシスタントから提案された献立は、どちらも驚くべきものだった。Googleの提案は、ブドウと野菜を使ってサラダを作るのはどうかということだった。対するChatGPTは、一番上の棚にあるピクルスに気づき、ラップやサンドイッチに入れるようアドバイスしてくれた。

スマートフォンのカメラを使ってレシピを探すのは、ほんの始まりにすぎないのかもしれない。IT企業各社の話を信じるなら、スマートフォンのカメラは私たちの日常の作業で今よりはるかに大きな役割を果たすようになりそうだ。しかも、その未来はすぐにやってくるという。

ユーザーは、スマートフォンに対して、自分の望みを伝えるだけでなく、周囲の世界を見せられるようになる。AppleやGoogle、OpenAI、Qualcomm、Metaなどの企業は、この方向に進んでいるようである。どの企業も2024年に、スマートフォンやスマートグラスを対象としたカメラベースの人工知能(AI)機能やコンセプトを新たに発表したからだ。

IT企業各社は、写真を撮影して思い出を保存できる機能だけでなく、カメラを一種のビジュアル検索エンジンに変えるというアイデアも模索している。スマートフォンのカメラをレストランに向けると、営業時間や料理の写真などの重要な情報が表示される、というような機能だ。カメラファーストの未来を示す最大の証の1つが、Googleとサムスン、Qualcommが12月に発表した「Android XR」だ。この新しい「Android」プラットフォームは、ヘッドセットやスマートグラスで動作するように設計されており、カメラとGoogleのアシスタント「Gemini」を使用して、ユーザーの周囲の世界に関する質問にリアルタイムで回答してくれるというものだ。

現在のスマートフォンはタッチ操作が主流であることを考えると、これは間違いなく大きな変化である。たとえ消費者に受け入れられたとしても、慣れるのに時間がかかるかもしれないが、アナリストやIT企業は、それが未来のモバイルデバイスの使い方を象徴するものになるだろうと考えている。

GoogleでAndroidプラットフォーム担当バイスプレジデント兼ゼネラルマネージャーを務めるSeang Chau氏は過去のインタビューで、「何かの写真をアップロードする場合であれ、カメラフィードを提供する場合であれ、今後、カメラと視覚的なフィードバックは非常に重要になっていくだろう」と述べている。

生成AIチャットボットは、2023年にOpenAIのChatGPTが登場したことで、飛躍的な進歩を遂げた。2024年に入ると、IT企業各社はAIヘルパーの次の段階に向けて準備を整えた。マルチモーダルAIエージェントだ。簡単に説明すると、マルチモーダルAIエージェントとは、複数の種類の入力(つまり、テキスト、音声、画像)を理解して、さまざまなタスクをユーザーに代わって処理することのできるAI搭載バーチャルアシスタントのことだ。

スマートフォンのカメラでレストランの会計伝票をスキャンし、支払金額を参加者の人数で割って、チップを追加してほしいとバーチャルヘルパーに頼めるようになる。そんな様子を想像してみてほしい。このテクノロジーはまだその段階には達していないが、モバイルチップメーカーのQualcommは、AIエージェントが進歩する中で近い将来に実現するかもしれないシナリオとして、この例を挙げた。

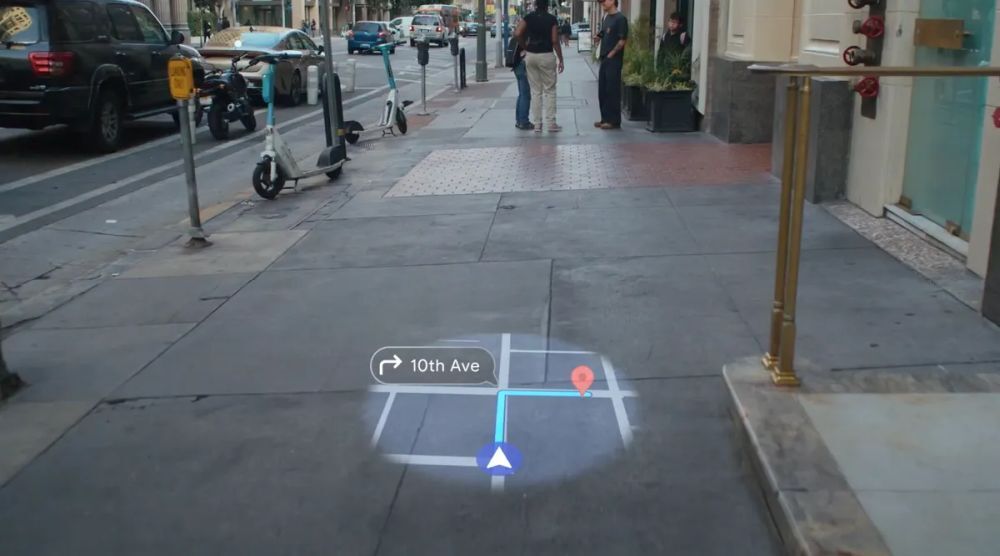

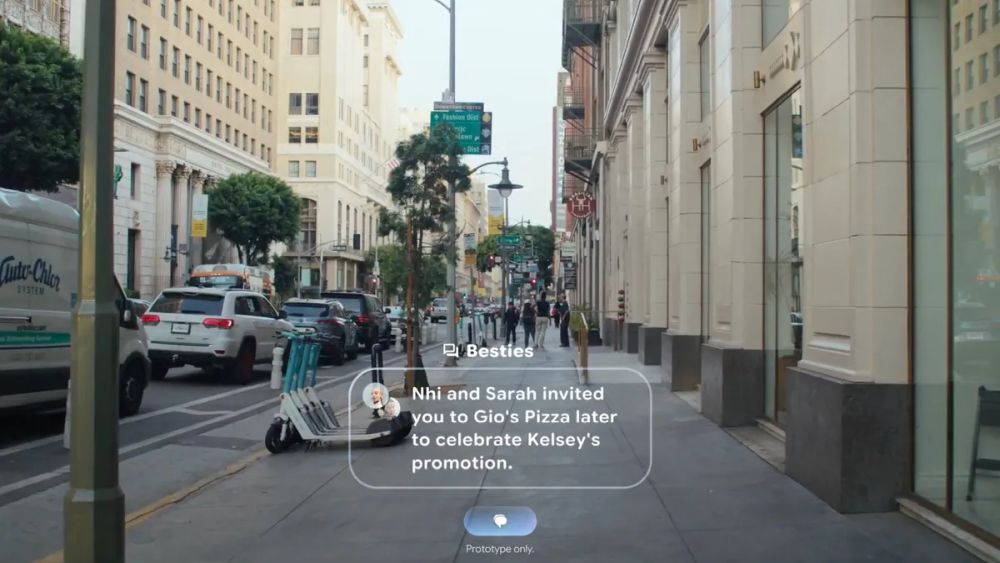

2024年なって、こうしたより未来的なアシスタントを形作るピースがうまく収まり始めてきた。OpenAIとGoogleはどちらも、自社のモデルとシステムが複数の種類の入力を処理する仕組みを改善した。OpenAIは12月、ChatGPTの「高度な音声モード」をアップデートし、スマートフォンのカメラに写る映像のほか、画面をChatGPTと共有できるようにした。これにより、写真をアップロードせずに質問することが可能になった。Android XRとGoogleの「Project Astra」は、そこからもう一歩進んで、ヘッドセットやスマートグラスでカメラをユーザーの視線の近くに配置することで、「Googleマップ」でランドマークを見ているときにはその場所の情報を教えてくれたり、書店で本を眺めているときにはその本の内容を要約して教えてくれるというものだ。

スマートグラスをかけて見るGoogleマップの表示の例

スマートグラスをかけて見るGoogleマップの表示の例スマートフォンメーカーがカメラを発見のためのツールとしてみなす傾向が強くなっていることを示す兆候は、ほかにもある。Appleは12月、「ビジュアルインテリジェンス」という新機能を発表した。新たに搭載されたカメラコントロールボタンを押すと、周囲の世界についての情報を教えてくれるという機能だ。

ボタンを押してカメラを起動し、興味のある対象にカメラを向けると、その対象についての詳細な情報が表示される。このモードで写真を撮影して、ChatGPTやGoogleに送信することで、数学の問題を解いたり、製品を検索したりすることも可能だ。

International Data Corporation(IDC)のデータおよび分析チームでシニアディレクターを務めるNabila Popal氏は、カメラを利用するAI機能について、「どれだけの手間を省けるか想像してみてほしい」と語った。「調べ物をしたり、必要な情報を見つけたり、カレンダーにイベントを追加したりするときに、多くのステップを省けるようになる」

ビジュアルインテリジェンスを使えば、iPhoneのカメラをカフェやレストランに向けるだけで、営業時間や写真などの情報を確認できる

ビジュアルインテリジェンスを使えば、iPhoneのカメラをカフェやレストランに向けるだけで、営業時間や写真などの情報を確認できるしかし問題は、こうした機能を果たしてユーザーは使ってみたいと思うのだろうかということだ。

こうしたAI機能の多くはまだ新しく、スマートフォンになくてはならないものという感じではまだない。Appleが「Apple Intelligenceのために作られた」最初のスマートフォンと位置づけたiPhone 16も、発売は9月だったが、その時点では、目玉機能は搭載されていなかった。ChatGPT連携など、Apple Intelligenceでも特に重要な追加機能のいくつかは、12月になってようやくリリースされた。

iPhone 16が消費者にどう受け入れられているのかというのは、極めて重要な問題だ。iPhone 16シリーズがApple Intelligenceに対応する数少ないスマートフォンの1つであることを考えると、消費者の反応によって、Apple Intelligenceの成否が決まる可能性もあるからだ。

Counterpoint Researchでスマートフォンを担当するシニアアナリストのGerrit Schneemann氏は、AIがまだスマートフォンのセールスポイントになっていないことを示すもう1つの例として、サムスンの「Galaxy S24」シリーズを挙げた。

「例えば、『Galaxy S24 Ultra』にアップグレードする人の多くは、古いUltraデバイスを使用していた人だ。つまり、アップグレードする時期が来たからアップグレードしているのだ。『Galaxy AI』が搭載されていることは、必ずしもアップグレードの理由にはなっていない」(Schneemann氏)

しかし、そうした状況を変える上でカメラが何らかの役割を果たすことになるかもしれない。AIを単なるギミック的なものから実用的なものに変えることができるのではないだろうか。

Googleが動画で示した、スマートグラスでメッセージを受信した場合のイメージ

Googleが動画で示した、スマートグラスでメッセージを受信した場合のイメージスマートフォンのカメラがすべてを見通すAIアシスタントへの第一歩となるのは何も不思議ではないが、こうしたアップデートは、スマートグラスにとっても好都合な環境を作り出している。

よく知られているように、スマートグラスは約10年前の「Google Glass」の時代に、消費者の支持を得ることができなかった。当時、Google Glassが失敗したことには、いくつかの重要な理由があった。プライバシーに関する懸念を引き起こしたこと、高価な価格に納得できるだけの魅力的なユースケースがなかったこと、そして、バッテリー持続時間の短さや視野の狭さといった技術的制限があったことだ。

しかし、生成AIの登場により、カメラを搭載したスマートグラスが再び注目を集めるようになった。GoogleでAndroidエコシステム担当プレジデントを務めるSameer Samat氏によると、AIの進歩により、スマートグラスの実現可能性を再検討するのに適切な時期になったという。Googleはフィードバックの収集を目的として、Project Astraテクノロジーを搭載したスマートグラスのプロトタイプをまもなくテスターに提供開始する予定だ。これは、スマートグラスが2025年に復活する可能性を示す兆候である。

「われわれは、これらのモデルがスマートフォンを使って何ができるか、また世界とやりとりする手段として、スマートフォンのカメラで何ができるかを試してきた。そして、可能性の大きさに驚いた」(Samat氏)

Ray-Ban MetaスマートグラスはすでにAI機能を備えている

Ray-Ban MetaスマートグラスはすでにAI機能を備えているMetaの最新の「Ray-Ban Metaスマートグラス」は、すでにAIを使用して、装着者の見ているものを分析し、リアルタイムで回答を提供することができる。また同社は、Metaの早期アクセスプログラムに参加しているユーザーを対象に、常時オンのAIアシスタンスを提供している。要するに、MetaのAIヘルパーはユーザーの入力を受け付けられる状態を維持できるため、ユーザーは質問したいときに毎回AIヘルパーを起動する必要がない。Googleのスマートグラスのプロトタイプも同じように機能する。つまり、Geminiは一度起動すると、ユーザーが一時停止するまで、入力を受け付けられる状態を維持する。

米CNETのScott Stein記者は、12月にGoogleのプロトタイプを試用したとき、Googleのオフィスのデモルーム内を歩き回って、棚にある書籍から「ネスプレッソ」のコーヒーマシンまで、さまざまな事柄について質問したが、Geminiを頻繁に起動する必要はなかった。

筆者もGoogleのプロトタイプを試したことがある。今自分の見ている植物は屋内環境に適しているのか、といった質問をすると、ほぼ瞬時にイヤホンから答えが聞こえてきた。今は、その植物の写真を撮影して、その画像をGeminiやChatGPTにアップロードしてから質問する、という余分な手間をかけている人がほとんどだろう。

Samat氏は、Android XRの背後にあるインスピレーションについて語ったとき、「あらゆるものにスマートフォンを向けるのは、必ずしも最も自然(なこと)ではない」と述べた。「これはスマートグラスにぴったりなのではないだろうか。そのひらめきがきっかけとなって、スマートグラスを検討するようになった」

一方、The New York Timesによると、OpenAIの最高経営責任者(CEO)のSam Altman氏とAppleの元デザインチーフのJony Ive氏は、iPhoneほど気を取らせないAI搭載コンピューティングデバイスの開発に共同で取り組んでいるという。この製品について明らかになっていることはほとんどないが、このプロジェクトも、新しいAIデバイスの波がまもなく到来する可能性を示す兆候である。

その一方で、2024年には、Humaneの「Ai Pin」やRabbitの「rabbit r1」(どちらもAIソフトウェアを搭載しており、カメラを利用して、ユーザーの周囲の環境に関する質問に答える)などのガジェットが登場したものの、出だしでつまずいてしまった。この2製品は、期待された性能を備えていないことや、発売の時点で不具合が多かったこと、全体的にスマートフォンほど直感的でも便利でもないことを広く酷評された。ただし、どちらもこの数カ月の間にアップデートで大幅に改善されている。

未来のデバイスが具体的にどのようなものになるのかは不明だ。そしてもっと不確かなのは、われわれが現在ポケットに入れて持ち運んでいるデバイスに匹敵する影響力と利便性を備えた消費者向けテクノロジー製品が登場するのかどうかということだ。しかし、今後の方向性を少しでも知りたい人のために言っておくと、すべては今所有しているスマートフォンのカメラから始まる可能性が高い。

Popal氏によると、最終的には、カメラを利用するかどうかに関係なく、生成AI機能はモバイルデバイスに不可欠なものに感じられるようになり、生成AIがないスマートフォンは時代遅れだったり、価値がないと思われるようになるかもしれないという。同氏はこれを、携帯電話でインターネットやアプリストアが利用できるようになったときの状況になぞらえている。

「古いスマートフォンは、全くスマートではないと感じられるようになるだろう」(Popal氏)

この記事は海外Ziff Davis発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する