この半年で、人工知能(AI)がもたらす好ましい影響がこれまで以上に注目されるようになったが、AIのリスクもまた同様だ。

最悪の場合、AIは誤った情報を生み出し、有害または差別的なコンテンツを生成し、セキュリティやプライバシーのリスクをもたらす可能性がある。そのため、モデルを一般に公開する前に正確なテストを行うことが極めて重要であり、Microsoftは5年前からそれを実行している。

同社は2018年にAIレッドチームを立ち上げた。同チームは、「攻撃者のように考え」「AIシステムの不具合を探る」ことによって、AIモデルのリスクを調査することを専門とする学際的な専門家で構成されているという。

そしてMicrosoftはこのほど、責任あるAI導入の模範となるべく、レッドチームの活動と知見を公開した。同社によると、AIモデルをテストする上では、ベースモデルのレベルと、アプリケーションのレベルの双方の視点が欠かせないという。同社はその例として、「Bing Chat」のAIを「GPT-4」のレベルと、GPT-4を利用した実際の検索エクスペリエンスという双方の視点から監視していることを挙げている。

Microsoftは同社ブログに「いずれのレベルにもそれぞれ固有のメリットがある。例えば、モデルをレッドチーム演習の攻撃対象にすること(レッドチーミング)は、プロセスの初期段階でモデルの悪用方法を洗い出したり、モデルの適用範囲を見極めたり、モデルの制約を理解する上で役立つ」と記している。

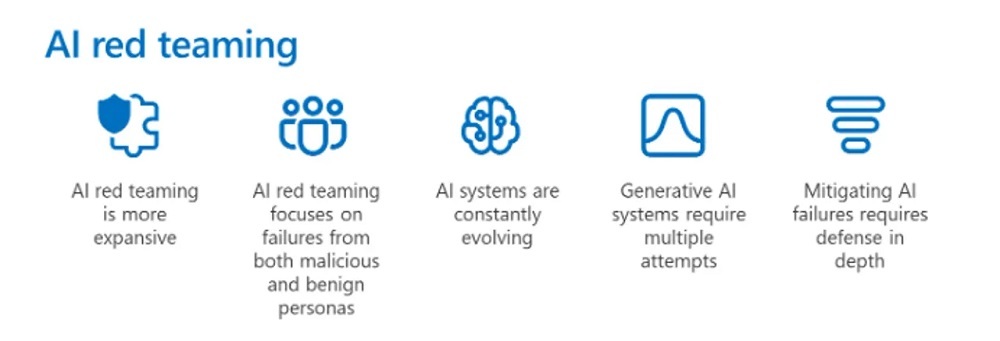

同社は5年間の経験で培ってきた、AIのレッドチーミングに関する重要な5つの洞察を公開した。

1つ目の洞察は、AIのレッドチームミングという言葉の適用範囲だ。AIのレッドチーミングとは、単にセキュリティをテストすることだけでなく、公平性や、有害なコンテンツの生成といった要素に関するテストを含む技術の総称だ。

2つ目の洞察は、悪意を持ったペルソナと悪意のないペルソナのそれぞれが犯した失敗に着目する必要があるというものだ。レッドチーミングはたいていの場合、悪意を持ったアクターによるテクノロジーの利用方法に着目するが、平均的なユーザーが利用する際に有害コンテンツがどのように生成されるのかについてもテストする必要がある。

Microsoftは、「新しい『Bing』において、AIのレッドチーミングは悪意ある敵対者がセキュリティにフォーカスしたテクニックやエクスプロイトを用いてAIシステムを悪用する方法だけでなく、システムと一般ユーザーがやり取りする際に、そのシステムが問題のある有害なコンテンツをどのように生成するのかについても焦点を当てる」と記している。

3つ目の洞察は、AIシステムが常に進化し続けているため、さまざまなレベルでのAIシステムのレッドチーミングが必要になるというところにある。これにより4つ目の洞察が導き出される。それは、生成型AIシステムのレッドチーミングには複数にわたる試みが必要になるというものだ。

生成型AIシステムとのやり取りは、そのたびに異なった出力が得られる傾向にある。このためMicrosoftは、システムの問題を見過ごしてしまわないようにするために、レッドチーミングによる多角的な試みを実行しなければならないという知見を得ている。

最後に、MicrosoftはAIの問題を緩和するには、深層防御という考え方が必要になると記している。つまり、レッドチームが問題を洗い出した後、その問題に取り組むためのさまざまな技術的緩和策を導入することになる。

同社が採っているような対策は、新たなAIシステムに対する懸念を和らげるのに役立つと同時に、それらのシステムに関連するリスクを軽減するのにも役立つはずだ。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス

CES2024で示した未来

CES2024で示した未来

ものづくりの革新と社会課題の解決

ニコンが描く「人と機械が共創する社会」

省エネだけではない

省エネだけではない

「程よく明るい」照明がオフィスにもたらす

業務生産性の向上への意外な効果

近い将来「キャッシュレスがベース」に--インフキュリオン社長らが語る「現金大国」に押し寄せる変化

近い将来「キャッシュレスがベース」に--インフキュリオン社長らが語る「現金大国」に押し寄せる変化

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「当たり前の作業を見直す」ことでパレット管理を効率化--TOTOとユーピーアールが物流2024年問題に挑む

「当たり前の作業を見直す」ことでパレット管理を効率化--TOTOとユーピーアールが物流2024年問題に挑む

ハウスコム田村社長に聞く--「ひと昔前よりはいい」ではだめ、風通しの良い職場が顧客満足度を高める

ハウスコム田村社長に聞く--「ひと昔前よりはいい」ではだめ、風通しの良い職場が顧客満足度を高める

「Twitch」ダン・クランシーCEOに聞く--演劇専攻やGoogle在籍で得たもの、VTuberの存在感や日本市場の展望

「Twitch」ダン・クランシーCEOに聞く--演劇専攻やGoogle在籍で得たもの、VTuberの存在感や日本市場の展望