Jimmy Gomez氏は、カリフォルニア州選出の民主党議員。ハーバード大卒で、米下院の数少ないヒスパニック系議員の1人だ。

だが、Amazonの顔認識システムは、同氏を潜在的犯罪者と見たようだ。

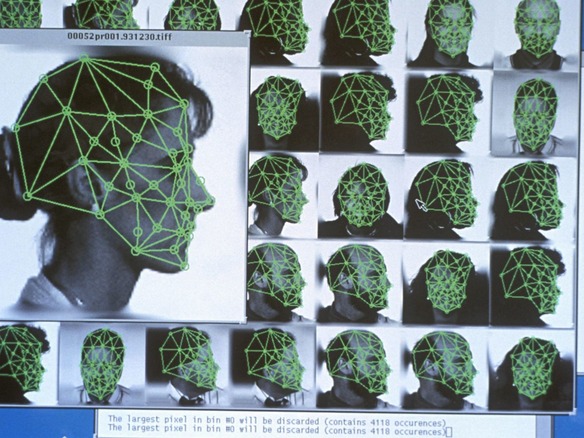

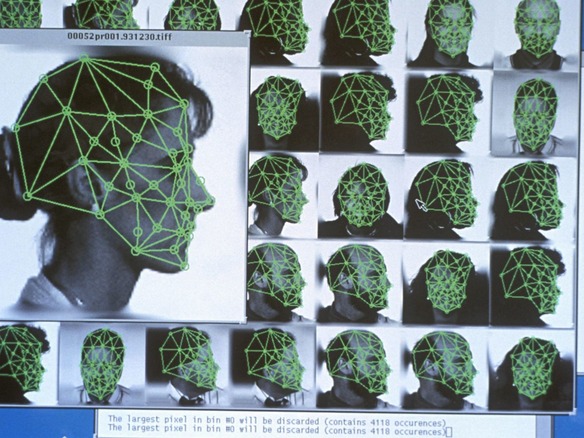

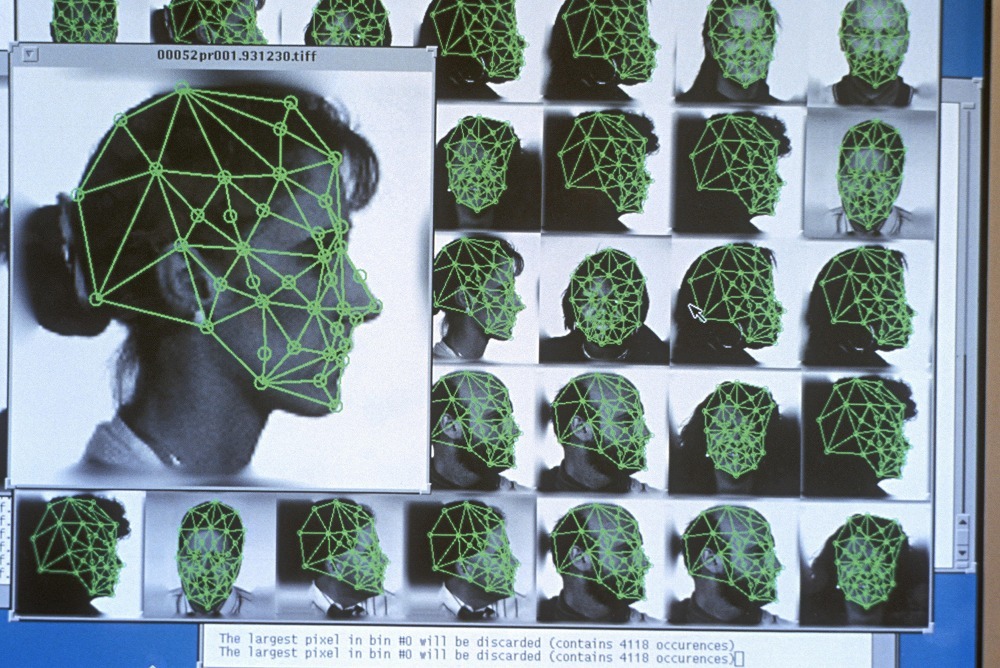

Gomez氏は、逮捕歴のある人物の顔写真と誤って一致されてしまった28人の米連邦議会議員の1人だ。これは、アメリカ自由人権協会(ACLU)が2018年に実施したAmazonの「Rekognition」プログラムのテスト結果の1つだ。

犯罪者の顔写真2500枚を米連邦議会議員の顔写真と比較したこのテストで、(非白人は全議員の20%しか占めていないにもかかわらず)誤認識された米議員の約40%は非白人だった。このAmazonのツールは警察も利用している。

この結果から、人権擁護団体、議員、さらに一部のIT企業までもが、顔認識技術がより主流になれば、マイノリティーを傷つけることになると懸念した。顔認識技術は、既に「iPhone」や「Android」スマートフォンで使われており、警察、小売店、空港、学校なども徐々に採用しつつある。だが、顔認識システムは女性と肌の色が濃い人の認識が苦手であることを、複数の調査結果が示している。それが悲惨な偽陽性につながる可能性がある。

ACLUの弁護士を務めるJacob Snow氏は「これは、法執行機関による顔認識技術の採用が、既に過剰に規制されているコミュニティーにとって有害な結果をもたらすことの一例だ」と語った。

顔認識技術には利点がある。メリーランド州警察はこの技術を使って、新聞社Capital Gazetteでの銃撃事件の容疑者を特定した。インドでは、警察がおよそ3000人の行方不明の子どもたちを4日間で確認する際に役立った。Facebookは、目の不自由なユーザーに写真に写っている人物を教えるために、この技術を使っている。スマートフォンのロック解除の便利な方法でもある。

だが、技術は完璧ではなく、大きな失敗もあった。「Googleフォト」はかつて、2人の黒人をゴリラと認識した。中国ではある女性が、自分のiPhone Xのロックを同僚が「Face ID」を使って解除できてしまうと主張した。誤認識のリスクは、法執行機関が犯罪の容疑者あるいは反対運動の活動家の特定に顔認識技術を使う場合に高まる。

Gomez氏は次のように語った。「犯罪者の特定という目的で法執行機関に顔認識技術を販売するとなれば、話は全く違ってくる。誤認識があれば、警察と誤認識された人との関係は最悪になる」

同氏は、ACLUのテスト結果に驚いていないという。技術者というものは、何かを稼働させる方法については熟考しても、彼らが構築するツールがマイノリティーに与える可能性のある影響については十分に考慮しないものだと指摘した。

IT企業は、顔認識システムの訓練で使うデータを改善することで批判に対応するとともに、人権活動家と同様に、この技術の悪用を防ぐために、政府による規制が必要だとしている。ジョージタウン大学ロースクールの研究者によると、米国の成人の2人に1人は法執行機関が使う顔認識ネットワークに登録されているという。

AmazonはACLUの調査結果について、ACLUはテストの際、誤った設定を使ったと主張し、反論した。

Amazon Web Services(AWS)で人工知能(AI)担当ジェネラルマネジャーを務めるMatt Wood氏は公式ブログで「機械学習は法執行機関を支援する非常に価値のあるツールだ。正しく応用されているのかという懸念はあるものの、われわれは、オーブンの設定温度をピザを炭にしてしまう高温に設定することもできるからといって、オーブンを放り出すべきではない」と述べた。

顔認識サービスが、白人男性と比べてマイノリティーと女性の認識を苦手とする理由は幾つかある。

技術者がコンピュータに顔認識させるための訓練に使う公開されている写真データは、非白人のものより白人のものが多い傾向にあると、ジョージタウン大学ロースクールのプライバシー&テクノロジーセンターで上級副学部長を務めるClare Garvie氏は語った。例えば、著名人のデータベースの写真を使うとすれば、ハリウッドではマイノリティーが過小評価されているため、データは白人に偏るという。

IT企業のエンジニアの多くは白人男性であり、彼らが顔認識システムを一定の人種の特定で高い成果をあげられるよう無意識に設計してしまう可能性もあるとGarvie氏は述べた。調査によると、人間は自分と異なる人種の人の顔を認識するのが難しいという。この「人種間バイアス」がAIに反映される可能性がある。さらに、肌の色が濃いと色のコントラストが少ないことや、女性の場合はしわを隠す化粧やヘアスタイルを変えたりすることが顔認識技術にとってのハードルになると、Garvie氏は付け加えた。

マサチューセッツ工科大学(MIT)のMedia Labの調査によると、Microsoft、IBM、Face++が構築した顔認識システムは、白人男性と比較して、アフリカ系米国人のような肌の黒い女性の性別を識別するのが困難という。このシステムは、肌が黒い女性の35%の性別を誤認識した。それに対し、白人などの肌の色が明るい男性の場合は1%だった。

MITが1月に発表した別の調査によると、Amazonの顔認識技術は、MicrosoftあるいはIBMの技術よりもさらに、肌の色が濃い女性の性別認識が困難だったという。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する