MemojiはAnimojiの自分版、という理解が正しい。これまでのAnimojiは、絵文字に収録されていた動物(一部、宇宙人なども)を、自分の顔の表情や動きに合わせて動かすことができる仕組みだった。

iOS 11とiPhone Xの組み合わせでは、iMessageの中でAnimojiを起動してスタンプを作ったりアニメーションの動画を作成して送信する、という使い方だった。Memojiも、iMessageのアプリから作成する必要がある。しかしその活用の場は拡がった。

iMessageで共有するためにカメラを立ち上げた場合、Memojiを適用した写真を撮影することができるようになった。Animojiも利用可能なほか、写真にダウンロード済みのスタンプや落書きを追加できるようになった。

いままで、Animojiは白い背景にキャラクターの静止画や動画を撮影する仕組みだったが、iOS 12ではARKitの機能向上から、実写にリアルタイムでAnimojiやMemojiを合成できるようになった。

また位置についても自由度が高まった。前述のiOS 11までは、白背景に加えて中央から顔の位置を動かせなかったが、実写の映像へのリアルタイム合成に対応したことから、必ずしも中央だけでなく、右や左に寄っていても合成される。

多少速く動いても、顔が画面の外に切れてしまわない限りは、きちんと合成が追随し続ける。Appleによると毎秒60フレームの速度を実現しており、その効果が現れているといえよう。

またFaceTimeでは、iMessageアプリで作成していたMemojiをリアルタイムで合成できるようになった。iMessage以外では初めてのMemoji/Animojiの活用手段となっており、自分の顔を実写から、これに合成したキャラクターに変えられる。

Memojiを使って見て驚かされるのは、その動きや表情が非常にリアルである点だ。前述のように、背景が白からカメラの実写に変更された点、60フレーム/秒への対応なども挙げられるが、それ以上に絵文字の動きや表情にリアルさを感じるのだ。

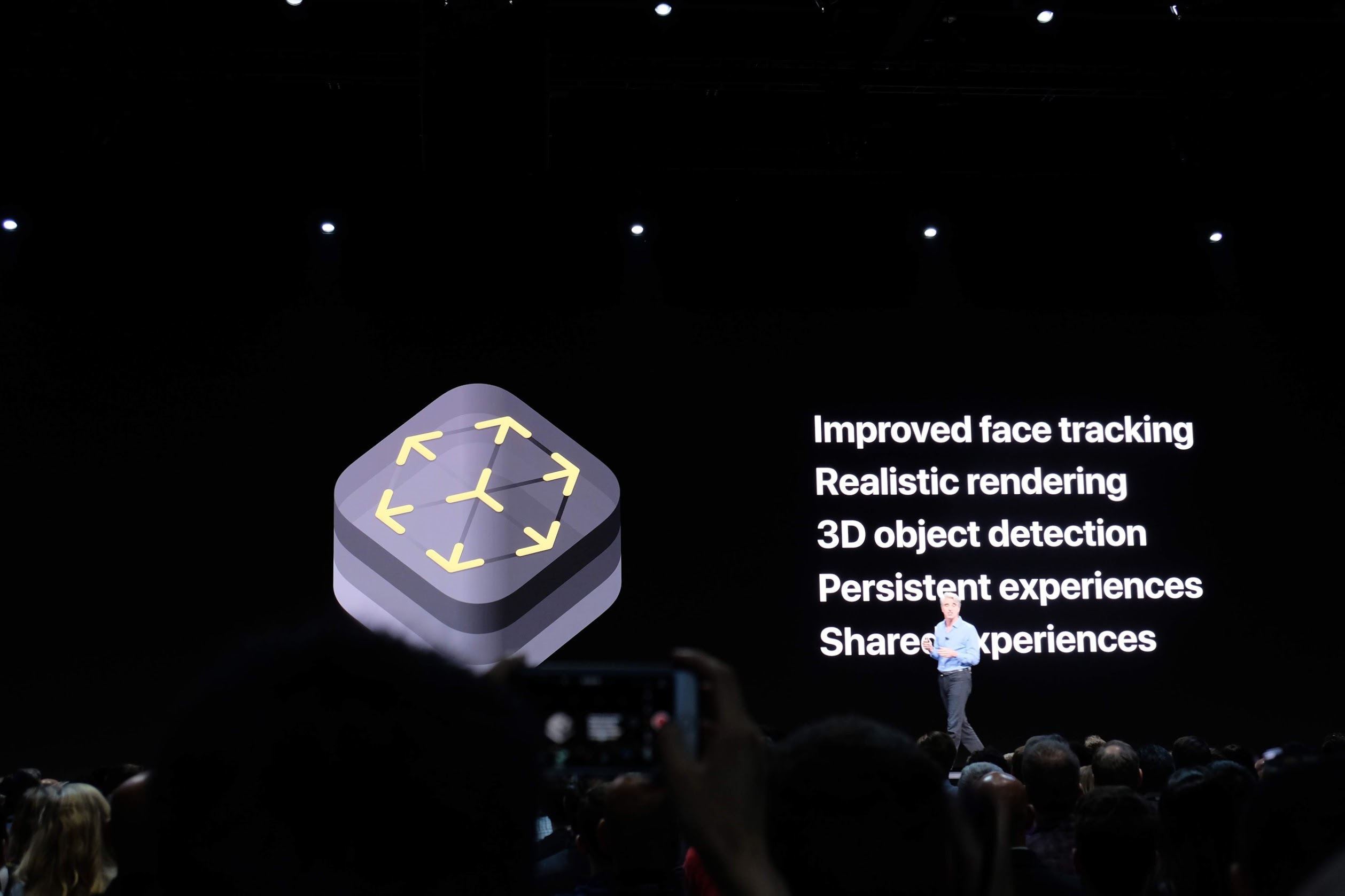

その秘密は、ARKit 2で対応した顔認識の向上機能に隠されている。

これまで、Animojiのプレゼンテーションでは、顔の50の筋肉の動きを読み取って絵文字に表情や動きを付けるとの説明が行われていたが、Memojiではこれらの動きの合成によって表情が作られる効果をより強く感じることができる。人の肌はそうした動きをより反映するキャラクターであるためだ。

また顔の筋肉に加えて、舌と目玉の動きを読み取るようになった。簡単に言えば、あっかんべーをしながらよそ見をしている表情を、iOS 12で再現できるようになった。

この目の動きは、Memojiのリアルさを作り出す非常に大きな要素になっていると感じた。確かにAnimojiのキャラクターはぬいぐるみの目のように黒く塗りつぶされて光沢があるような表現だったため、目の動きを取っていないことを気にすることはなかった。

しかしMemojiには普通の人の目が表現されており、この目玉が動かないと、かなり不自然になってしまう。そこでARKit 2では目、視線の動きの検出を追加する問題解決を行ったのだ。

すでにAppleはiOS 12のパブリックプレビューを公開している。Appleは主たるデバイスでの試用を推奨しておらず、iPhone Xが主たるスマートフォンではない人の方が珍しいと思うが、機会があったらMemojiのリアルさを、ぜひ体験してみて欲しい。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する