Googleは2017年5月、人工知能(AI)ハードウェアの自作を支援する「AIY(AI yourself)Projects」を発表し、その第1弾として自然言語の音声認識が可能なDIYキット「AIY Voice Kit」を提供開始した。このキットは、「Google Assistant SDK」などと連携することで、「Raspberry Pi」を音声アシスタントに変えることができる。

さらにGoogleは今回、Raspberry Piで画像認識デバイスを自作できる「AIY Vision Kit」を発表した。このキットは、Googleの機械学習モデル「TensorFlow」を利用するもので、デバイスを制御する専用の「Android」アプリが近く登場する予定だ。

Googleによると、AIY Vision Kitは「デバイス上におけるニューラルネットワークのアクセラレーション」を特徴とし、Raspberry Piベースのデバイスがクラウド上での処理に頼ることなく画像認識を実行するという。なお、先行したAIY Voice Kitは、クラウド上で自然言語処理を行う。

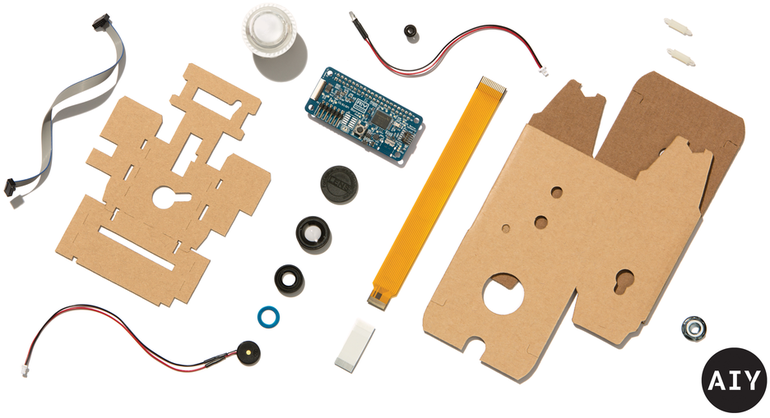

AIY Vision Kitで自作する人は「Raspberry Pi Zero W」、Raspberry Piカメラ、4GバイトのSDカード、電源を別途用意する必要がある。AIY Vision Kit自体には、「VisionBonnet」アクセサリボード、ケーブル、段ボール製の箱とフレーム、レンズ装置、カメラ作動時に他者に知らせるためのプライバシーLEDが含まれている。

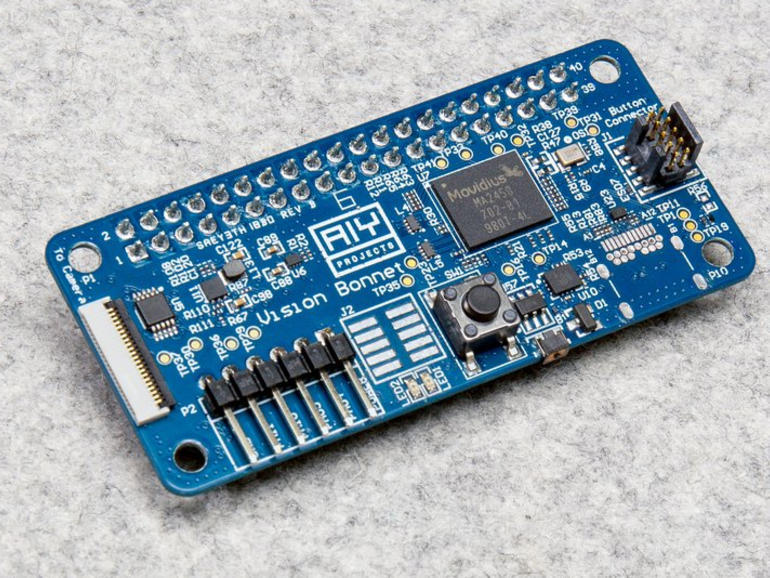

VisionBonnetボードは、Googleが開発した基盤で、Intelの画像処理チップ「Movidius MA2450」を搭載している。このチップがAIY Vision Kitの隠れた決め手だ。

AIY ProjectsチームのメンバーであるKai Yick氏は、Raspberry Piの公式雑誌「MagPi」の取材に応じ、このチップで画像認識を実行すると、「Raspberry Pi 3」で処理させる場合に比べて60倍高速になると述べた。VisionBonnetは、キットに含まれるケーブルでRaspberry Pi Zero Wに接続される。

AIY Projectsによると、AIY Vision Kitでは複数のニューラルネットワークプログラムを利用でき、第1のニューラルネットワークプログラムは、カメラの視野にいる人間、猫、犬を検知できるという。別のニューラルネットワークは、幸福感や悲しみなどの感情を検知できる。さらに、オープンソースモデルの「MobileNets」をベースにしたプログラムは、椅子やオレンジ、カップなど1000種類の物体を検知できる。

Googleは、開発者がこれらのニューラルネットワークを足がかりにして、第1のプログラムにウサギを認識させるなど、新しいタスクに適応させることを期待している。同社はまた、TensorFlowでモデルを再トレーニングするコンパイルモデル用のツールも提供している。

GoogleはVision Kitによって、さまざまな種類の動植物を特定したり、犬が裏口に来たことや車が私道を出発したことを認識したり、ゲストの感情を分析したり、さらに誰かが自分の部屋に入ったときに音を発するシステムを作ったりすることもできると提案している。

Vision Kitの価格は44.99ドル(約5000円)。現在Micro Centerで予約を受け付けており、12月29日より出荷される。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する