Facebookで人工知能(AI)の学術的研究を手がける組織「Facebook AI Research(Facebook人工知能研究所)」のエンジニアリング・マネージャーであるアレクサンドル・ルブリュン氏が来日した。

ルブリュン氏は、フランスのエコール・ポリテクニーク(国立理工科学校)を卒業後、ソフトウェア開発者に音声認識機能と自然言語処理技術を提供するスタートアップ企業「Wit.ai」を創業。Facebookに買収された2015年1月からは同社のAI技術開発に取り組んでいる。また、英語圏をはじめ海外のMessengerに実装されているAIアシスタント「M」のプロジェクト責任者も務める。

Facebookは、AIの可能性や課題をどのように捉え、サービスの中でどのように活用しようとしているのだろうか。11月14日にルブリュン氏に話を聞いた。

——まず、Facebookのサービス全体におけるAIの位置づけや意義について教えてください。

現在、Facebookでは大きく3つのシーンでAIを活用しています。具体的には写真投稿に関する部分です。Facebookでは毎日10億枚の写真がユーザーによって新たに投稿されていますが、このときに3つの異なるAIが働いています。1つ目はフィルタリング機能で、投稿された写真の中からポルノや暴力的なものを判別して、不適切なものをフィルタリングしています。

2つ目はコンテンツセレクションに関する機能です。ユーザーがFacebookで接触できるコンテンツは膨大であるため、AIがユーザーの投稿する写真の中身を理解した上で、その嗜好性に合わせて最適なレコメンドをしています。

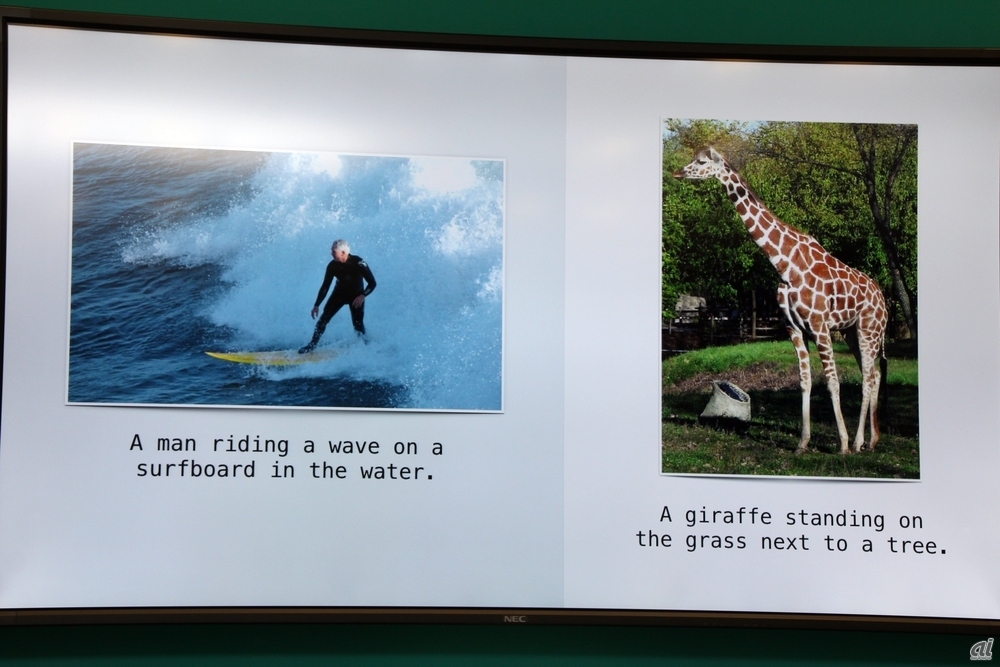

3つ目は、視覚障害を持った人向けの機能です。視覚障害の方はタイムラインにシェアされている写真を見ることができません。しかし、どのような写真が投稿されているかを説明するテキストをAIが自動的に生成して、視覚障害のユーザーがどのような写真がシェアされているかを理解できるよう手助けしています。あくまでインプット=投稿されるのは写真ですが、AIは写真の中身を理解してそれを自然言語にしているのです。

このほか、自動翻訳機能に関する部分でもAIを活用しています。Facebookでは、約50の言語を使って144通りの直接翻訳を行い、一部の言語では英語など主要言語への翻訳を経由して翻訳(ピボット翻訳)します。これらを含めて、全部で2351通りの組み合わせになります。この翻訳機能は辞書データによる都度翻訳ではなく、AIの機械学習を活用することで最適な翻訳をしています。加えて、後ほど話題にするMessengerのチャットボットM(日本未導入)にもAIが活用されています。

——フィルタリングという点では、いま国内外でフェイクニュースの投稿や自殺や犯罪を示唆・助長する投稿など、不適切な投稿・拡散への対応が大きな課題となっています。FacebookのAIはこうした課題にどのように対応するのでしょうか。

まず、AIが単独でこうした不適切投稿に対処するということは、絶対にないと言えます。その傍らには必ず人間がいるということです。世の中には常に新しい投稿が生まれ、それが不適切か否か、合法か否かというギリギリの判断を迫られます。それは人間ですら判断が難しいかもしれません。コンピュータでその判断をすることは、まず不可能なのです。

AIのゴールというのは、それが不適切か否かを判断することではなく、99%以上ある適切な投稿を判断すること。それによって残り1%の疑義のある投稿が明らかになり、人間が判断をするという対応が可能になるのです。

AIが得意とすることは何でしょうか。それは、たくさんの事例(=教師データ)を学んで、それに類似するものを見つけ出すことです。もちろん、AIに不適切な写真を学習させたら何億枚、何十億枚という膨大な写真データの中から類似する写真を瞬時に探し出してくるでしょう。自殺を助長する投稿データを学習させた場合も同様ですよね。

しかし、AIは新しいものを考えて作り出すことは得意ではありません。AIは人間が行った判断を学習して引き継ぐことはできても、自分自身で人間に先んじて新しい判断を独自にすることはできないのです。

——とはいえ、人間の判断という知見(=教師データ)が蓄積されると、投稿をAIが判断する精度は高まるのではないでしょうか。

確かに、教師データの蓄積で発見の精度は高まりますが、残念ながら“これで充分だ”という状態には絶対になりません。そこには2つの大きな理由があります。

1つ目は、いま仮に世界最高の人工知能を用いたとしても“100%正しい”という判断は絶対にできないということです。99%正しかったとしても、カバーしきれないわずかな不確実性が必ず存在します。100万のサンプルを学習しても、それは解消できないでしょう。ゲームやレコメンドであれば、それでいいかもしれません。しかし、自殺助長や犯罪などの発見には、わずかな不確実性も残されるべきではありません。だからこそ、AIでは自信をもって判断できないところは人間が対応する必要があるのです。

2つ目は、ユーザーの投稿には常に新規性があるということです。たとえば、フェイクニュースは5年前にこんなに存在していたでしょうか。新しい種類の犯罪や新しい種類のコンテンツは常に生み出されていて、そのフォーマットもテキストから始まって、写真、動画、ARと多様化しています。そうしためまぐるしい変化に合わせて“不適切な投稿”の定義を考えて学んでいく必要があるのです。その部分で、まずは人間が介在して判断する必要があるわけです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する