Googleは米国時間5月13日、年次開発者会議「Google I/O」を前に、ソーシャルメディア「X」で予告動画を公開し、「rabbit r1」の開発元が恐れをなすであろう新たなマルチモーダルAI機能を披露した。

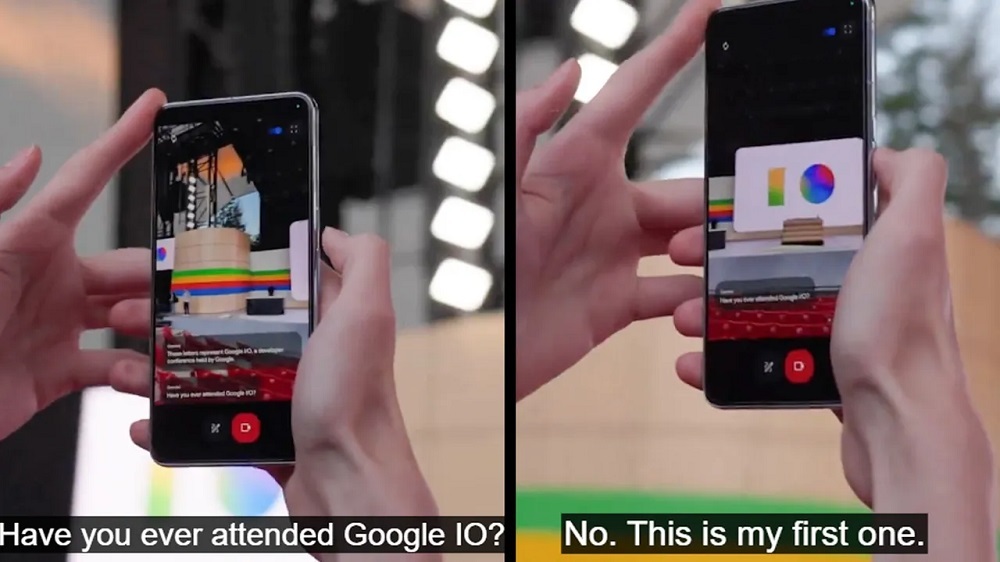

動画では、スマートフォンのカメラをGoogle I/Oのステージにかざし、「ここで何が起こっていると思う?」と問いかける。GoogleのAIモデル「Gemini」は、「人々が大きなイベント、おそらく会議かプレゼンテーションの準備をしているようです」と答える。そして、「特に目を引くものはありますか?」と自ら質問する。

Geminiにステージ上の大きな文字(IとO)を見せて意味を尋ねると、GeminiはGoogle I/Oという開発者会議を示していると正しく特定した。この質問によってAIは背景情報を得ることができ、その結果、より有益な回答を提供できるようになったのだろう。その後、Geminiはさらに 「Google I/Oに参加したことがありますか?」と質問する。少なくとも動画では、会話は自然で難なく行われているように見える。

One more day until #GoogleIO! We’re feeling . See you tomorrow for the latest news about AI, Search and more. pic.twitter.com/QiS1G8GBf9

— Google (@Google) May 13, 2024

rabbitは4月にrabbit r1のデモを実演した際、同様のマルチモーダルAI技術を披露し、多くの人から画期的な機能だと称賛された。Googleの予告動画は、同社がGemini向けに同様の機能を開発すべく懸命に取り組んできたことを示している。動画を見る限り、この機能はrabbit r1よりも優れている可能性がある。

Googleとrabbitだけではない。OpenAIは13日にライブ配信したイベントで、「ChatGPT」に「見る、聞く、話す」機能を追加する最新のAIモデル「GPT-4o(オー)」などを発表した。デモでは、プレゼンターがスマートフォンのカメラを通して、手書きの数学の問題やプレゼンターの表情などさまざまなものをAIに見せ、AIは同様にユーザーとの会話を通じて、これらの物事を正しく識別した。

目の前で披露されない他のデモと同様、今回の動画もうのみにすべきではない。それでも、GoogleがOpenAIのライブ配信のわずか1時間ほど前にこの動画をおそらく戦略的に公開したことは、同社が今週Geminiについてさらに多くを語るであろうことを示唆している。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する