最高速のグラフィックスを待ち望むゲームファンでもなければ、チップ開発企業NVIDIAの事業についてよく知らないかもしれない。しかし、同社が米国時間3月22日にカンファレンス「NVIDIA GTC 2022」で発表した一連の新モデルを含む同社のプロセッサーは、人工知能(AI)サービス、自律走行車、新たに始まりつつあるメタバースといった多様なデジタル製品の頭脳になる存在だ。

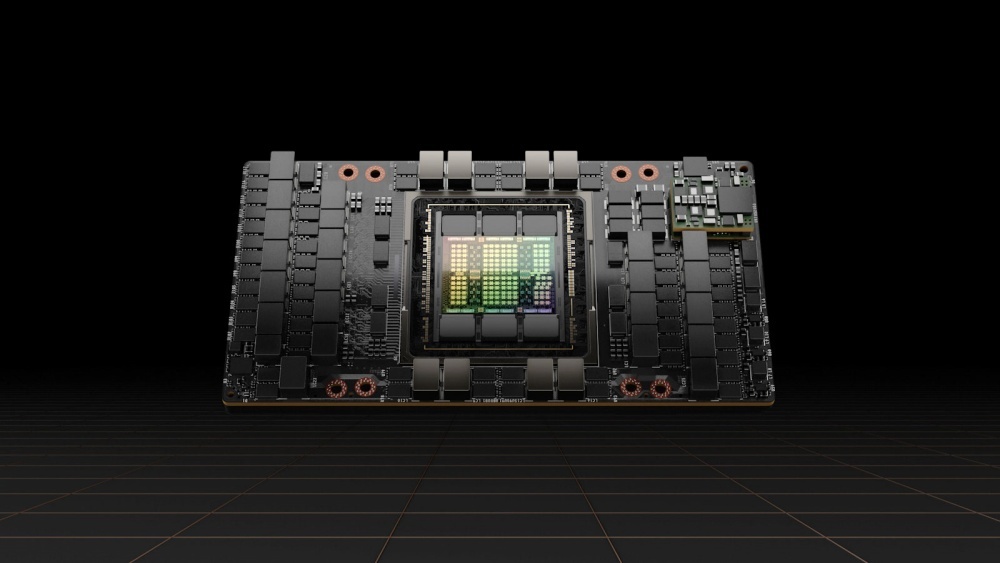

NVIDIAはGTC 2022で、新たなAIプロセッサー「H100」を発表した。これは現行の「A100」の後継となるモデルであり、A100は人の発話の翻訳、写真に写っているものの認識、自動運転車の移動ルートの設定などを行うAIシステムのトレーニングに利用されている。

A100は、NVIDIAの好業績に大きく貢献したGPUファミリーの最上位モデルだ。最高経営責任者(CEO)のJensen Huang氏はオンラインのカンファレンスで、同社の高速接続技術「NVLink」を利用すれば、最大256個のH100チップを相互接続させて「実質的に1基の驚異的なGPU」に変えることもできると述べた。

NVIDIAによると、A100は「Hopper」アーキテクチャーに基づいており、同社の新たなCPU「Grace」と組み合わせることができるという。

NVIDIAはまた、「Ampere」アーキテクチャーに基づくグラフィックスチップの新モデル「RTX A5500」を発表した。このチップは、アニメーション、製品デザイン、ビジュアルデータ処理などの3Dタスクにグラフィックスパワーを必要とするプロフェッショナル向けだ。これは同社のメタバース開発プラットフォーム「Omniverse」の事業拡大に沿う動きとなる。同社はOmniverseを通じて、メタバースと呼ばれる3D領域の構築に必要なツールやクラウドコンピューティングサービスを販売している。

H100は2022年第3四半期に出荷開始予定で、一方のGraceは「来年に出荷する見通し」だとHuang氏は述べた。

H100は、台湾積体電路製造(TSMC)の4ナノメートルプロセスを採用して、800億ものトランジスターで構成されるデータ処理回路を有する。このGPUには多くの競合製品があり、例えば1000億以上のトランジスターを搭載するIntelの次期プロセッサー「Ponte Vecchio」や、Graphcore、SambaNova Systems、Cerebrasなどの新興企業が開発している多くの専用AIアクセラレーターチップが挙げられる。

NVIDIAのとりわけ有名な競合企業はTeslaだ。同社の「D1」チップを搭載した「Dojo」技術は、自動運転車のトレーニングに使われている。Teslaはまた、こうしたAIモデルを車両本体で実行する独自のプロセッサーを設計している。

NVIDIAは、自律走行車向けAIチップ「NVIDIA DRIVE Orin」が、電気自動車メーカー2社、米国のLucidと中国の比亜迪(BYD)の車両に採用されると発表した。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する