現在のところ、これらのAIアルゴリズムは、英語話者と、一般的にALSに伴う発話障害に対してのみ機能する。しかし、Googleはこの研究成果をより多くの人々やさまざまな発話障害に適用できることを期待している。

さらに、同社はパーソナライズされたAIアルゴリズムを訓練することで、音やジェスチャーを検知して、何らかのアクションを実行できるようにする(例えば、「Google Home」への音声コマンドの生成やテキストメッセージの送信など)取り組みも進めている。これは、特に言葉を全く発することのできない人に役立つかもしれない。

Google Homeなどでデジタルアシスタントを使用すると、簡単な音声コマンドを伝えるだけで、お気に入りの曲などを流したりすることができる。だが、言葉を発することができない障害者は、この技術を利用できない。

ミラノに拠点を置くGoogleの戦略的クラウドエンジニアのLorenzo Caggioni氏は、そうした状況を変えたいと考えた。同氏を触発したのは、先天性白内障、ダウン症候群、ウェスト症候群を患い、言葉を話せない弟のGiovanniさんだ。Giovanniさんは音楽や映画が大好きで、ほかの多くの21歳の青年たちと同じように、最新のガジェットやテクノロジーを使うことも好んでいる。だが、障害があるために、「OK Google」コマンドを声で発して、AndroidスマートフォンやGoogle Homeデバイスを起動するといったことはできない。

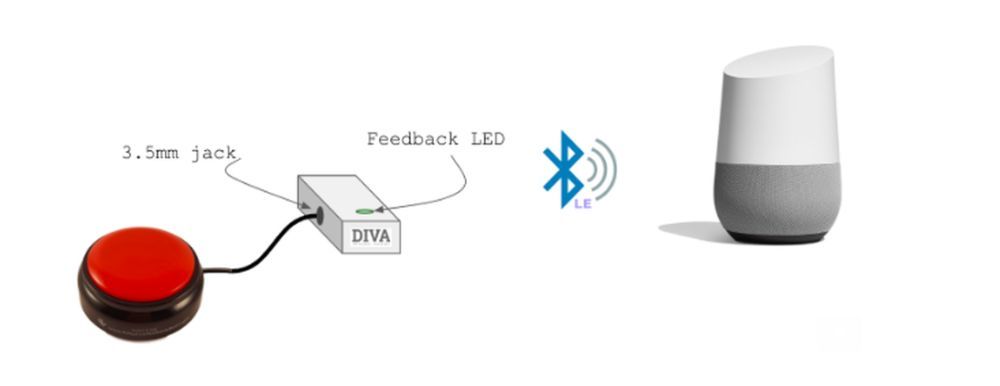

弟がもっと自立し、より大きな自由を得られるように、Lorenzo氏とミラノのGoogleオフィスの数人の同僚は、声を使わずに「Googleアシスタント」への命令を生成する装置を作るため、Project Divaを立ち上げた。チームは有線ヘッドホンジャックを使ってスマートフォンやノートPC、タブレットに差し込めるボタン型の装置を作った。このボタン装置はBluetooth経由で接続して、Google Homeデバイスにアクセスすることができる。

今は、手でこのボタンを押すだけで、Giovanniさんは友人や家族と同じように、同じデバイスやサービスで音楽を聴けるようになった。

Lorenzo氏によると、Giovanniさんのために作った装置はほんの始まりにすぎないという。同氏のチームは、コマンドに関連する物体にRFIDタグを付けることで、言葉を話せない人がGoogleアシスタント経由でほかのさまざまなものにアクセスできるようにする計画も立てている。

このプロジェクトは、聴覚障害者や難聴の人が電話をかけたり、電話に出たりできるように支援する。デバイス上の音声認識技術とテキストを音声に変換する技術を使用することで、このソフトウェアは、ユーザーが入力している間、スマートフォンがユーザーの代わりに聞いたり話したりすることを可能にする。反応が素早く、入力予測候補を使用するため、文字入力の速さは同時型のコミュニケーション手段である電話に耐えられるようになっている。

だが、Live Relayは、聞くことや話すことができない人のためだけのものではない。会議中、または地下鉄に乗車中で、電話に出ることはできないが文字を入力することならできる、という状況で使用することも可能だ。Googleはリアルタイムの翻訳機能の統合も検討しているので、言葉の壁に関係なく、世界中の誰にでも電話をかけて、コミュニケーションをとることができるようになるかもしれない。

Pichai氏は基調講演で、次のように語った。「われわれが技術を進歩させていくうえで重要な方針のひとつは、あらゆる人にとって、より効果的に機能する製品を開発することだ」

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する