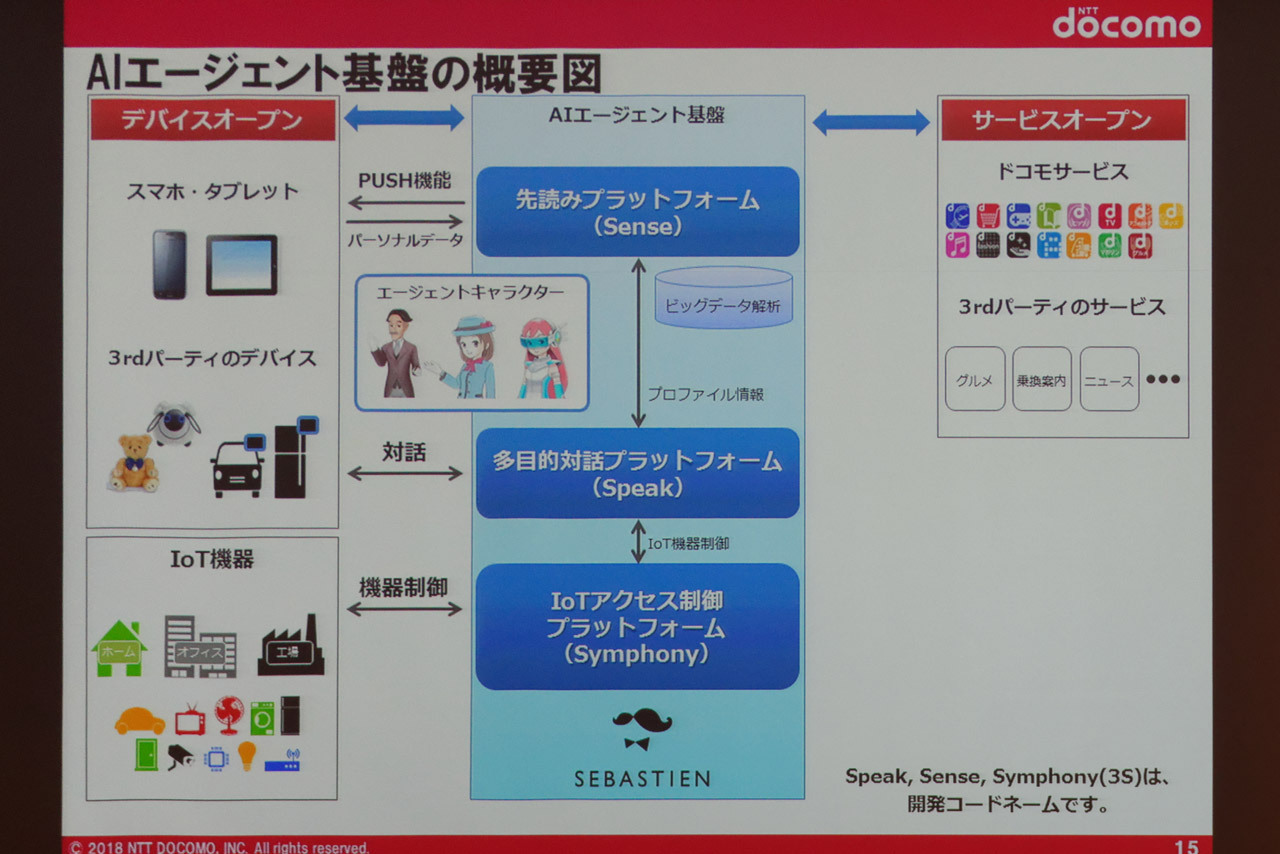

AIエージェントの根幹をなすのが「AIエージェント基盤」と呼ばれるもので、「Sense」「Speak」「Symphony」(いずれも開発コード名)という3つのプラットフォームで構成されている。

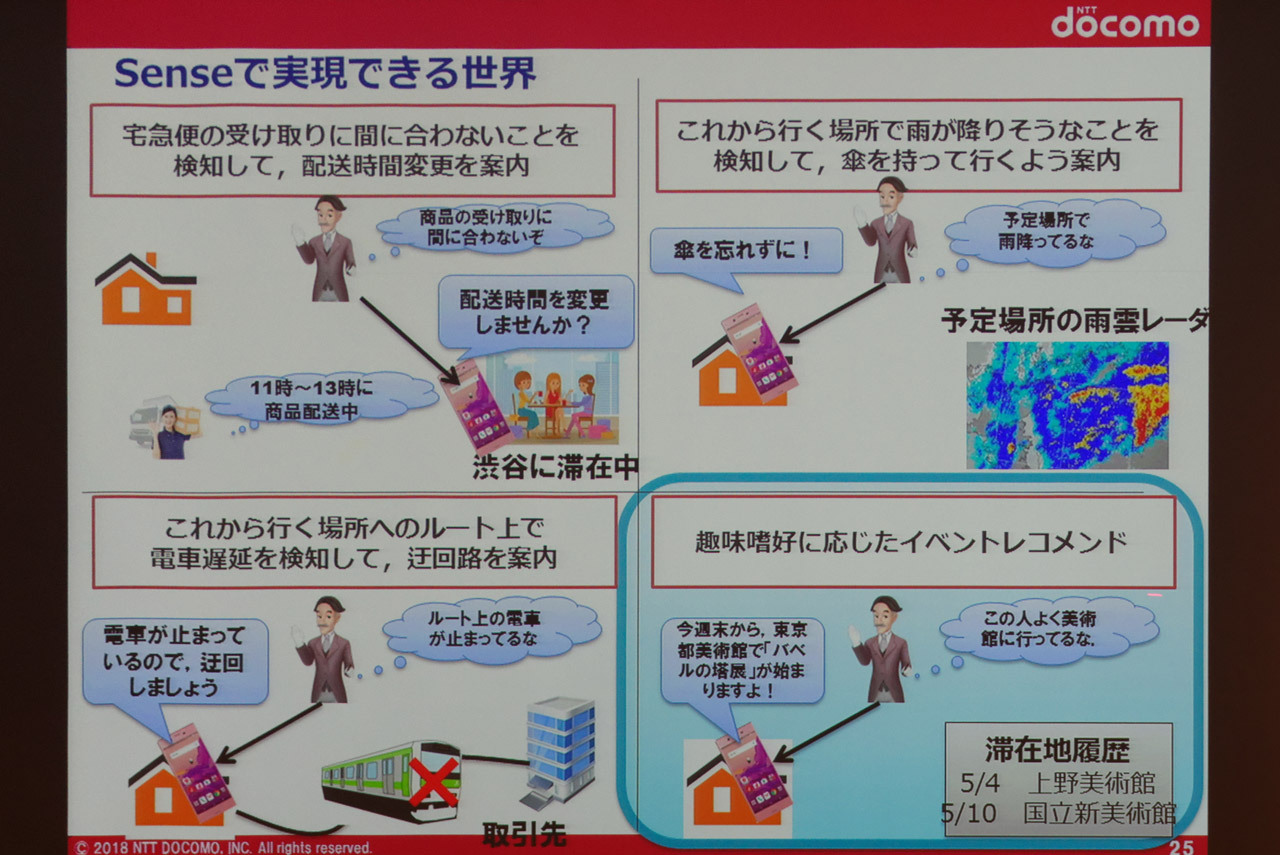

Senseは、NTTドコモが持つユーザー情報や気象情報、交通情報などを元に、ユーザーの行動を“先読み”して情報配信するもの。例えばユーザーの現在地を検知し、「宅配便の配送予定時刻までに帰宅が間に合わない場合は、配送時間の変更をすすめる通知を送る」といった機能を実現できる。

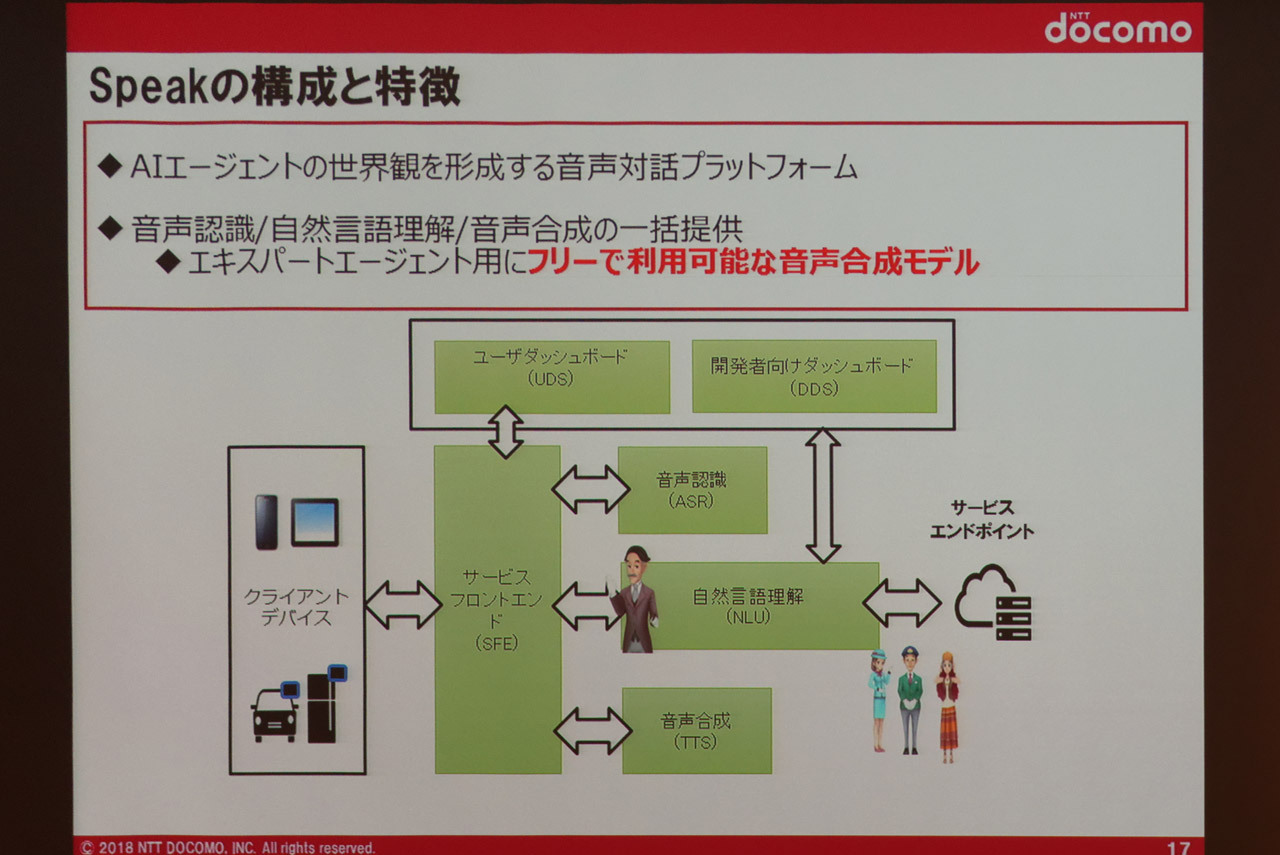

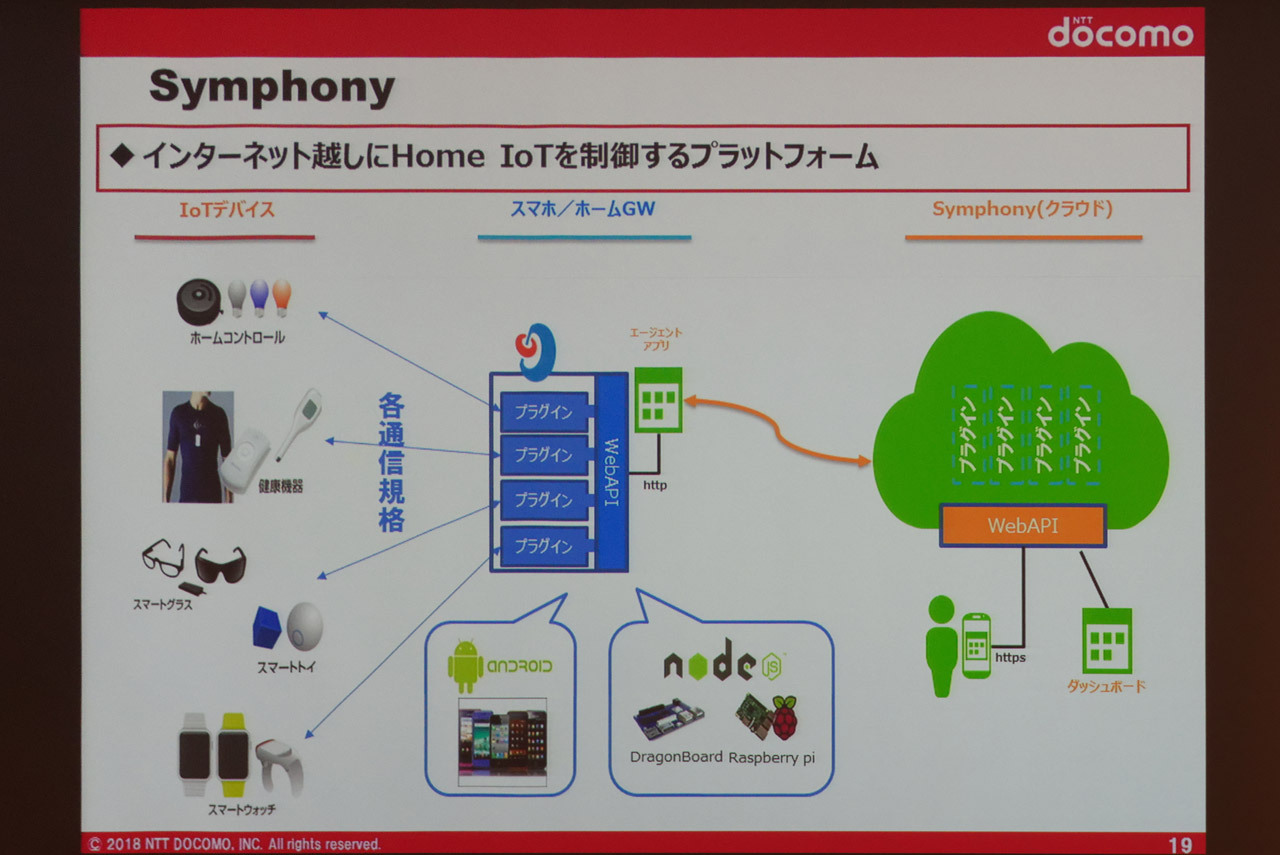

Speakは、多目的対話プラットフォームで、音声認識、自然言語理解、音声合成の3つの機能を包含し、ユーザーと対話するフロントエンドに近い部分を担当する。3つ目のSymphonyは、IoTアクセス制御プラットフォームで、インターネット経由でウェアラブルデバイスや宅内のIoT機器を操作できるようにするものだ。

これらのバックグラウンドには当然ながらビッグデータやAIが存在しており、“いろいろできる”仕組みではある。しかしながら、先述の通り個々のエキスパートエージェントと連携して実現する点が、他の一般的な対話型AIとは異なっている。これは、大庭氏が考える「いろいろできる必要はない」というコンセプトに基づくものだ。

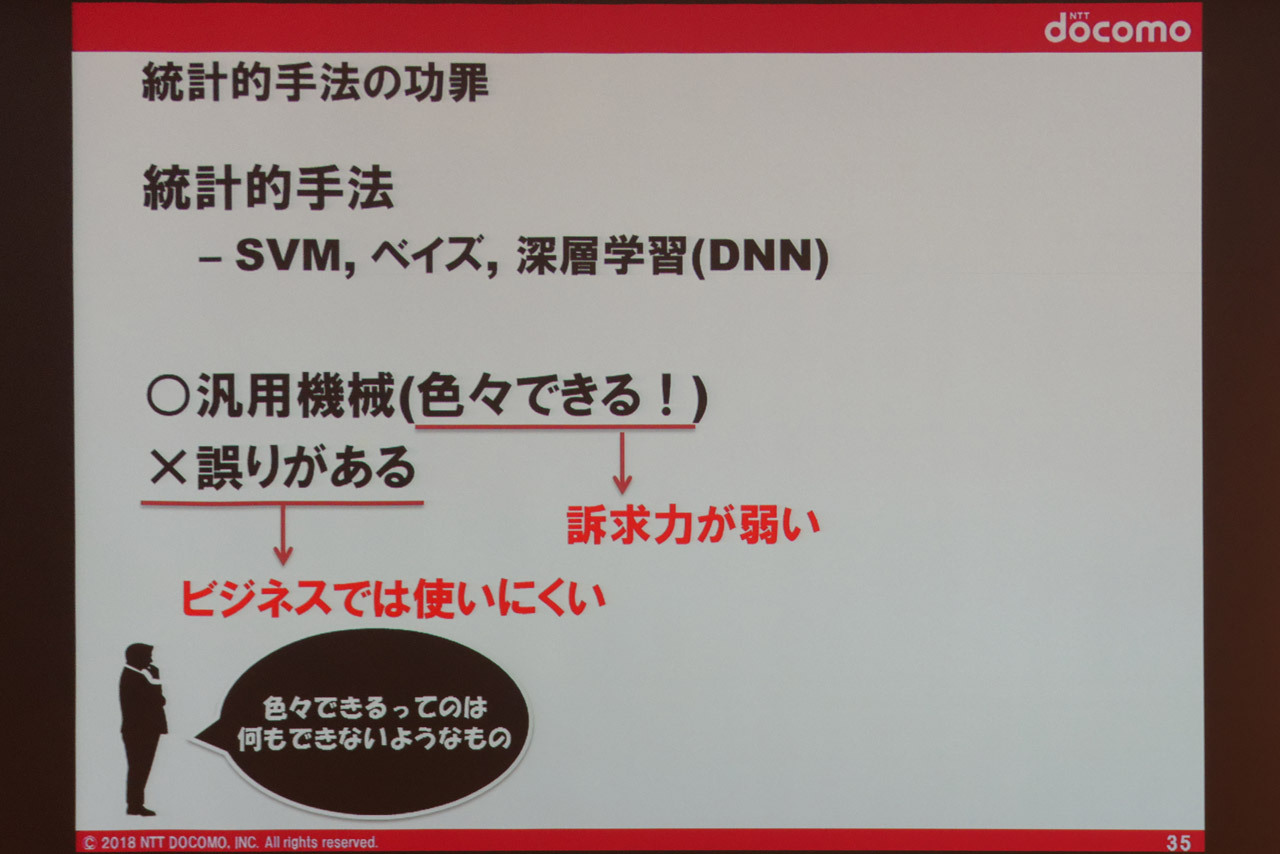

大庭氏によると、AIのアルゴリズムは、いくつかの種類はあっても統計的手法がベースにあることに違いはなく、「どの手法でも性質は同じ」という。そのようなAIは元々「いろいろなことをできるようにするためのツール」であり、特定用途に特化していない作りだと、ユーザーの望む回答とは全く異なる分野の情報が返されるなど、「まれに素っ頓狂な誤りをしてしまう」ことがあるとする。

では、対話型AIにおいて本当に「いろいろなことができる」汎用性は必要ないのだろうか。ここで同氏は、一般ユーザーの「しゃべってコンシェル」の使い方を紹介した。ある人は、毎日必ず「ヨコハマ、天気」というキーワードで話しかけるだけで、またある人は「目覚ましで毎日5時台に起こしてもらう」ための音声コマンドしか利用していなかったという。ここまで限定的な用途であれば、スマートフォン画面の使いやすい位置に天気情報や目覚ましアプリを置いておけばいいかもしれないが、ユーザーにとっては指よりも音声だけで素早く操作したい気持ちが強いとのこと。

このことから同氏は、少なくとも対話型AIにおいては「なんでも話せることは求められていない」こと、「頻繁に使われる機能を音声でさっと入力できればいい」こと、そして「ユーザーのニーズに合った機能を訴求すること」が大事だと認識したという。「スマートフォンもいろいろなことができるが、みなさんが使う機能も限られているはず」と大庭氏は語る。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する