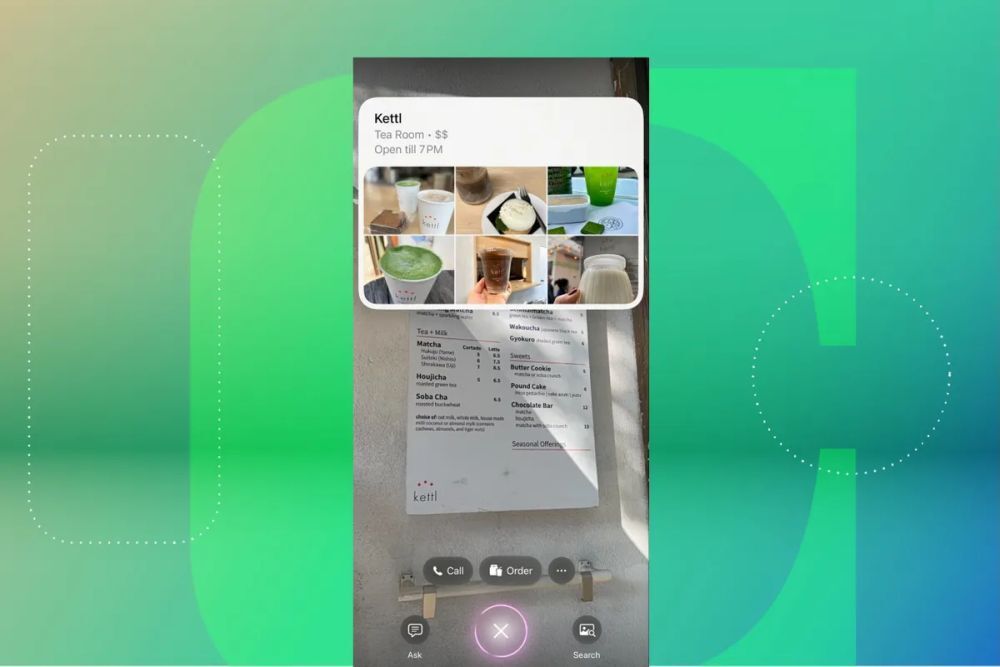

筆者は、ニューヨークにあるフードコート「The Bowery Market」で日本茶専門店の前を通りかかった。「iPhone」を店に向けて構え、本体脇にある「カメラコントロール」ボタンを長押しすると、それだけで店の営業時間、客がアップロードした写真、そして店に電話する、または商品を注文するオプションが表示された。

Appleの新しい「ビジュアルインテリジェンス」ツールは、「iPhone 16」シリーズでこれから使えるようになる機能だ。iPhoneのロックを解除して「Google」や「ChatGPT」を開き、質問を入力するか写真をアップロードして答えを待つという途中のステップを飛ばすことを目的として作られている。その機能の早期バージョンが、米国時間10月23日に公開された「iOS 18.2」の開発者向けベータ版に追加され、ベータプログラム参加者が利用できるようになっている。

筆者が試したのは開発者向けの早期プレビュー版で、一般ユーザー向けではないが、ビジュアルインテリジェンスの仕組みや、それがiPhoneの操作性にもたらす可能性を垣間見ることはできた。早期バージョンを短時間ながら試したところ、興味のあるポイントに関する情報をその場ですぐ引き出すのに便利なことは分かった。確かに便利だろうが、リリースされてからユーザーがこの機能に慣れるには時間がかかりそうだとも思える。スマートフォンの操作方法を新たに考え直すことになるからだ。

それでもやはり、モバイルデバイスで何かを操作するとき、アプリを今までほどたくさん開く必要がなくなるという未来は感じられる。その点は有望だ。

だが、より長期間使ってみて、最終バージョンがリリースされてから、語りたい点がもっと出てくるだろう。

ビジュアルインテリジェンスは、iPhone 16と「iPhone 16 Plus」「iPhone 16 Pro」「iPhone 16 Pro Max」で採用された新しいカメラコントロールボタンを利用する。このボタンを長押しするだけで、ビジュアルインテリジェンスについての説明が表示され、画像はiPhoneに保存されず、Appleとも共有されないという情報も示される。

ビジュアルインテリジェンスのインターフェースが開いたら、カメラのシャッターボタンをタップするだけで写真が撮影される。そこからは、画面上のボタンを押して画像のことをChatGPTに質問することもできるし、検索ボタンを押してGoogle検索を開くこともできる。ChatGPTを使うとき、アカウントの有無は問わない。サインインしなければ質問は匿名のままとなり、質問内容がChatGPTのモデルの訓練に使われることもない。

現行バージョンのビジュアルインテリジェンスには、3つの点のようなアイコンを押して懸念事項を報告するオプションもある。画像を削除して別の画像を撮影したい場合は、通常なら画面上のシャッターボタンがある位置に出現している「X」アイコンをタップする。

GoogleまたはChatGPTを使えるほか、iPhoneのカメラを向けた被写体に応じて特定の情報も表示される。例えば、お店やレストランに向ければそこの営業時間が分かる。

短時間ながらビジュアルインテリジェンスを使ってみた中で、筆者はレストランやお店の情報を調べたり、テレビゲームなどについて質問したりしてみた。

ChatGPTやGoogleを素早く便利に使えるだけでなく、レストランやお店を識別できる機能が筆者にとっては特に興味深かった。これまでのところ、看板やのぼり旗ではなく、店頭にカメラを向ける方が反応は正確だった。

例えば、冒頭で書いた日本茶専門店「Kettl」の外装にカメラを向けると、ビジュアルインテリジェンスは各種の飲み物の写真など、役に立つ情報を自動的に引き出してきた。筆者のオフィスの近くにあるビンテージもののテレビゲーム店でスナップ写真を撮ったときも、同じように反応した。シャッターボタンを押すと、その店の名前と店内の写真、ウェブサイトのURL、電話をかけるオプションが表示された。

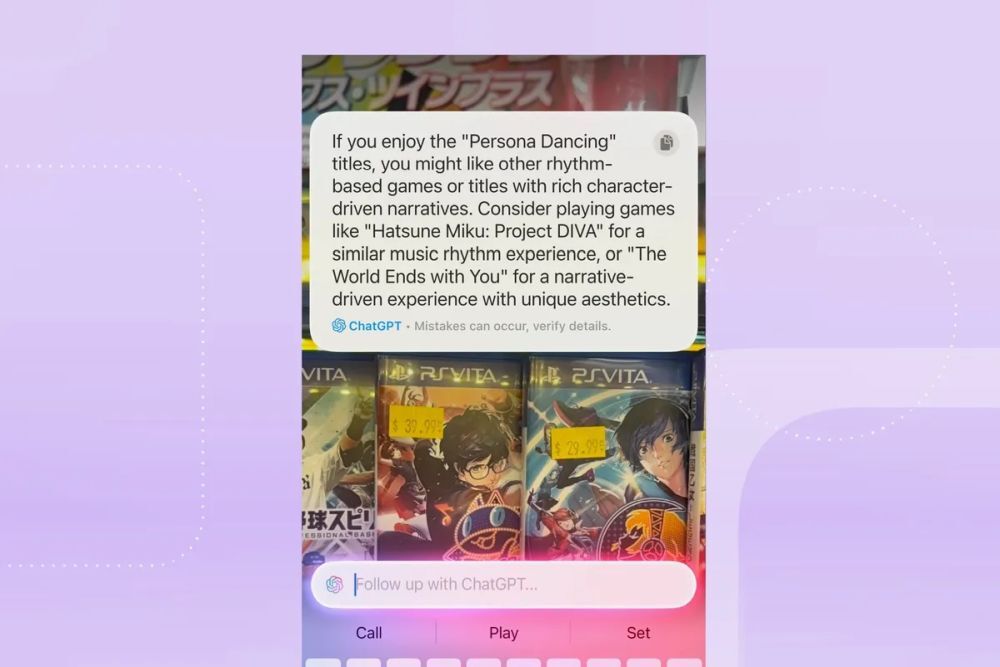

店内に入ってからも、ビジュアルインテリジェンスを使って、店内に並ぶゲームタイトルに基づいたお勧めゲームや、店頭にあるゲーム機やゲームの詳細な情報をChatGPTに尋ねる。回答はかなり正確だったが、ChatGPTをはじめとするチャットボットが常に正確とは限らない点には注意が必要ということを覚えておこう。

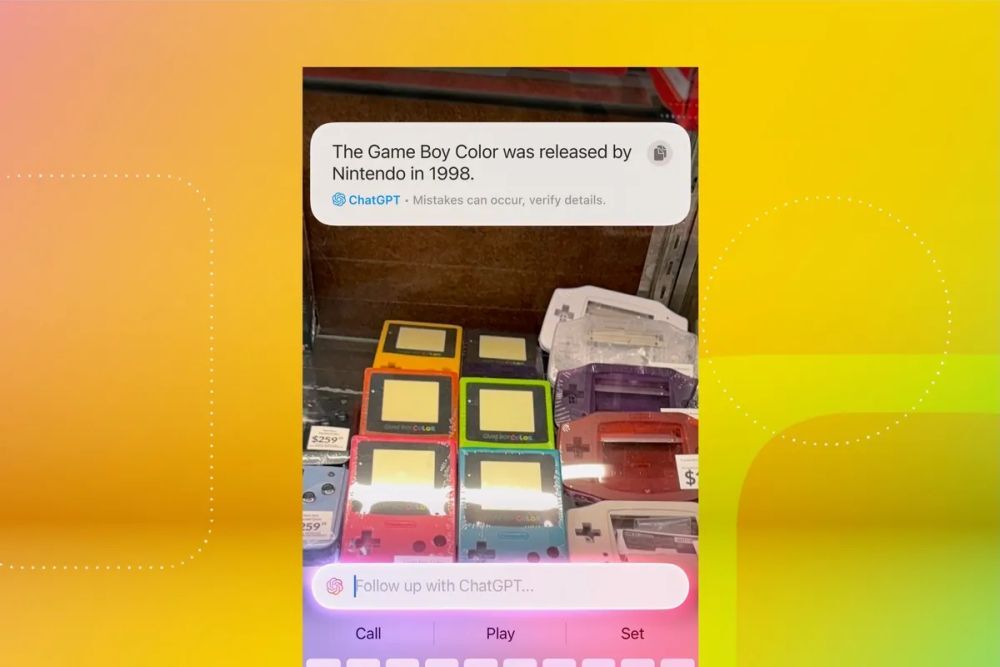

棚にある「ペルソナダンシング」シリーズの写真を撮ってから、これに似たゲームはないかとChatGPTに聞いてみると、音楽とストーリーで進行する別のゲームを推奨してきた。ペルソナダンシングは、日本製の人気RPG「ペルソナ」シリーズからスピンオフしたリズム系ゲームなので、これは妥当な回答だろう。「ゲームボーイカラー」の発売年(1998年)についても、写真を撮って発売時期を尋ねるだけだった(参考までに、ChatGPTアプリで同じ質問をしても、同じような回答が返ってきた)。

ここまででも、筆者はビジュアルインテリジェンスの操作を楽しめているが、旅行中ならもっと役に立ちそうだと思う。2024年に入ってからフランスとスコットランドに旅行したときに、ランドマークや、レストラン、店舗にiPhoneのカメラを向けるだけでその詳細情報が分かったら、さぞ便利だっただろう。すでになじみのある街の中では、まわりの場所に関して詳しい情報が必要になるシチュエーションがあまりない。

こうしてみると、やはりビジュアルインテリジェンスを「Googleレンズ」と比べずには済まなくなる。Googleレンズでも同じように、手で検索ワードを入力する代わりにスマートフォンのカメラを向けて周囲の世界について知ることができる。現状(繰り返すが、現在は開発者向けの早期プレビュー版だ)では、ビジュアルインテリジェンスは、まるでGoogleレンズ/ChatGPT専用ボタンのように感じられる。

そうなると、Googleレンズが何年も前に登場したことを考えれば、ビジュアルインテリジェンスには新しさも珍しさも感じられないかもしれない。しかし、この種の機能は特に重要だからこそ、新しいiPhoneでは専用ボタンまで追加された。その事実は多くを物語っている。スマートフォンで、検索をはじめとする各種の操作性を改善できる道があるとAppleが考えている証しだろう。

そう確信しているのは、もちろんAppleだけではない。GoogleやOpenAI、Qualcommも、そしてRabbitなどのスタートアップも、モバイルデバイス上の人工知能(AI)でカメラの新しい使い方を生み出せると考えている。そのために、カメラを単なる写真撮影の手段ではなく、何かを発見するためのツールにしつつある。先頃開催されたQualcommの年次の「Snapdragon Summit」において、同社は、レストランのレシートの写真をもとに3人での割り勘計算をするといった、カメラを使用するバーチャルアシスタントのコンセプトを発表した。

ポイントとなるのは、一般の人にその操作に慣れてもらうことだ。たとえ従来のやり方より高速で効率が高いとしても、今までの操作方法が身体に染みついているので、タップやスワイプというこれまでの操作から写真を撮るという動作にすぐに切り替えるのは難しいのではないだろうか。

新しい習慣を身につけるには時間がかかる。とはいえ、ビジュアルインテリジェンスはまだ早期プレビューの段階にすぎない。これからもっと多くのことが期待できるだろう。

Appleこの記事は海外Ziff Davis発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する