日本電気(NEC)は7月6日、Generative AI(生成AI)における日本語大規模言語モデル(Large Language Model:LLM)を開発したと発表した。

同LLMは、独自に収集・加工した多言語データを利用した、いわゆるファウンデーションモデル(基盤モデル)になるという。

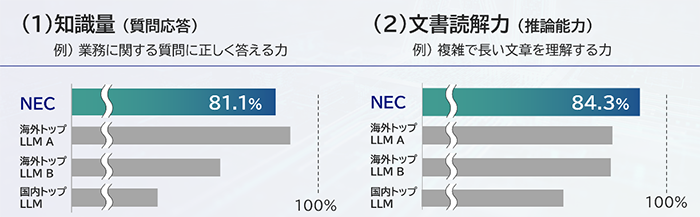

性能面では、早稲田大学河原研究室とヤフーが共同研究により構築・公開した日本語言語理解ベンチマーク「JGLUE」を使用して日本語の知識量や文書読解力を計測。

現時点で知識量に相当する質問応答で81.1%、推論能力に相当する文書読解においては84.3%と世界トップレベルの性能を確認。さまざまな業種における業務において、十分な機能を発揮できるという。

また、各LLMの特徴のひとつとして、パラメータサイズの大小が用いられるが、パラメータのサイズを増やすことは、推論速度の低下やモデル運用に必要なGPU枚数、消費電力の増加などに繋がってしまう。そのため、同一の性能であればパラメータ数は少ないことが望まれている。

同社では、LLMの性能がパラメータサイズの他にも、学習に使われた高品質なデータの量や学習時間に左右されることに着目。独自技術によりパラメータ数を130億に抑えることで、GPU1枚搭載の標準的なサーバーで動作が可能としつつ、多量のデータと膨大な計算時間をかけることで、高い性能を実現した。

これにより、同LLMを組み込んだ業務アプリケーションでは、レスポンス良く動作し、業務運用時の電力消費やサーバーコストを抑えられるという。

さらに、顧客の業務に特化させたLLMが短期間で容易に構築でき、オンプレミス環境でも動作可能なため、秘匿性の高い業務においても安心して利用できるとしている。

同社では、国内企業で最大のAI研究用スーパーコンピュータを独自構築し、2023年3月に全面稼働を開始。これを活用することで、約1カ月の短期間で高性能なLLMの構築を実現した。

なお、同社では、すでに同LLMを社内業務で活用しており、文書作成や社内システム開発におけるソースコード作成業務など、さまざまな作業の効率化にも応用している。

今後は、ファウンデーションモデルをもとに、顧客のクローズドデータを用いた個社向けLLMの開発を推進。また、ファウンデーションモデル自体の性能改良も進め、これらの技術を「NEC Generative AI Hub」を通じて、早期実用化して行く予定だという。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する