KDDI総合研究所は1月24日、現実世界の人が発する音の向きや動きを仮想空間で体感できるようになる音場のインタラクティブ合成技術を開発したと発表した。

同技術は、人や動物の動きや容姿を撮影するモーションキャプチャーやボリュメトリックキャプチャーで得られた3次元(3D)物体の形状や位置情報を活用。音源の向きや動きを伴った音場を、撮影された人および、視聴者の双方の動作に応じてリアルタイムで合成するものとなる。

同社は、2030年に向け、離れていてもあたかもそこにいる・あるかのような、距離を感じさせない社会の実現を目指し、五感の再現・表現を通じた次世代のコミュニケーション技術の研究開発を進めている。

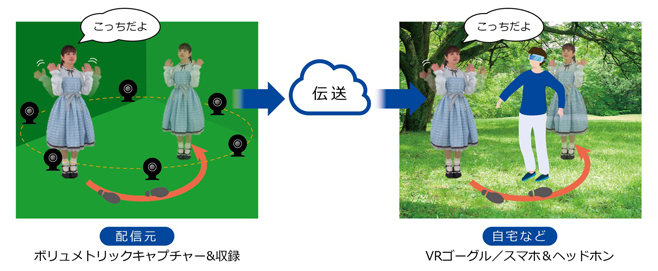

近年、メタバースに加え、デジタルツインを実現するための要素技術の研究開発が国内外で活発に進められているという。特に、モーションキャプチャーやボリュメトリックキャプチャーは、人などの3D物体の動作や容姿を忠実に再現できるため、通信や放送、エンターテインメントなど、幅広い用途が見込まれている。

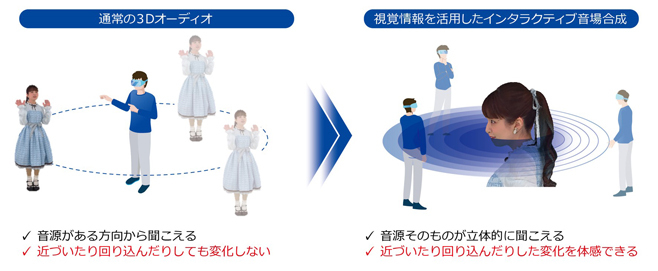

これらを活用したメタバースなどの仮想世界を実現する多くのプラットフォームでは、3D物体を任意の向きや位置からリアルタイムで視聴できるが、人が発する音源の向きや動きは変化しないなど、音に関する表現力には課題があったという。

加えて、Beyond 5G/6G時代に期待される空間再現には、視覚情報だけでなく臨場感ある聴覚情報も不可欠であり、音の立体表現が求められている。

そこで同社は、人などの3D物体を取り囲むように離散配置した複数(10本程度)のマイクロホンを用いて、3D物体の撮影を通じて取得したその形状や位置情報を含む視覚情報を活用。人から発する音源の向きや動きを伴った音場を、撮影された人および、視聴者の双方の動作に応じてリアルタイムで合成する音場のインタラクティブ合成技術を開発した。

同技術により、音源そのものが立体的に聞こえるほか、近づいたり回り込んだりしたときの音色の変化を体感できるという。また、複数のカメラを離散配置するボリュメトリックキャプチャーとの親和性を有するため、現実世界の人などの3D物体を、高い表現力を持つ音と映像で仮想世界にリアルタイムで再現可能となっている。

同社では、仮想世界におけるアバターや人の動きと、発せられる音の向きや距離の変化などの動きが連動することで、視覚に加えて聴覚による空間認知が促されるため、より自然で豊かなオンラインコミュニケーションが楽しめると説明する。

同技術を活用すれば、メタバースやデジタルツインにおいて、例えばアーティストやアイドルなど、現実世界の人と一緒に過ごす体験や、バーチャルYouTuberに代表されるモーションキャプチャーされたアバターなどとのコミュニケーションを、より自然で豊かに楽しめるようになるとしている。

今後は、現実世界での周辺環境に影響される音の反射や反響特性を考慮するなど、複雑な現実世界をよりリアリティー高く仮想世界に持ち込めるように、音場の合成技術のさらなる高度化を図る。また、3D点群圧縮技術PCC(Point Cloud Compression)に対応したリアルタイムコーデックを用いた伝送実験に成功していることから、PCCと同技術を組み合わせるなど、メタバースプラットフォーム上での検証や評価も進めていくという。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する