Googleの年次開発者会議「Google I/O」開幕に先立ち、筆者はカリフォルニア州マウンテンビューにある同社のImmersive Labを訪れた。拡張現実(AR)に関する2019年のGoogleのビジョンは実用性と支援で、「Google検索」はAR対応になり、「Googleレンズ」は人々が読むのを支援するようになる。Googleは2019年の新たな実験的アイデアを見せてくれた。その一部を紹介する。

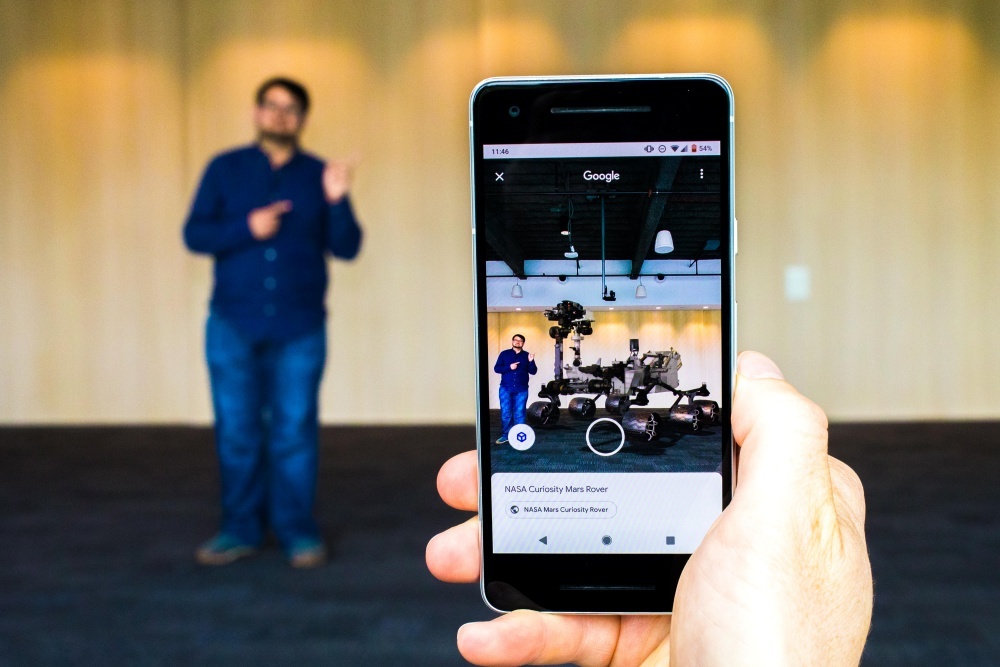

「tiger」(虎)を検索すると、クリック可能なファイルが表示される。それをクリックすると、うなり声の音声も含むアニメーション3Dファイルが開かれる。その後、ARを通して室内でそのファイルを開くことができる。すると、リアルなARの虎が現れる。米航空宇宙局(NASA)の火星探査機「キュリオシティ」の縮尺モデルや、人間の腕の骨と筋肉組織の解剖学的モデルを室内にドロップすることも可能だ。

Googleは2019年、Google検索にARを導入する。その仕組みはこうだ。対応する「Android」および「iOS」デバイス上で、Google検索に3Dオブジェクトのリンクが表示されるので、それをクリックすると、3Dモデルが表示される。この3Dモデルは、ARによって適切なサイズで現実世界にドロップすることが可能だ。Google検索は「glTF」形式を使って、3Dファイルを組み込む。なお、「iOS 12」の「ARKit」では、Appleの「USDZ」形式が使われる。Googleによると、開発者は数行のコードを追加するだけで、Google検索に3Dアセットを表示させることができるという。

一方、Googleレンズはメガネのないスマートメガネのような使用感をすでに実現している。カメラを利用するこのアプリは、今でも物体の認識、翻訳、ショッピング、現実世界の認識に使用することが可能だ。

しかし、Googleはきめの細かさから範囲の広さまで、Googleレンズの全く新しい機能群を模索している。これにより、Googleレンズは2019年にさらに進化しており、さまざまなものをARで現実世界に重ねる動きが活発化し始めている。カメラとAR製品を担当するバイスプレジデント兼ゼネラルマネージャーのAparna Chennapragada氏は、「これまで、Googleレンズを使う人は、『これは識別ツールだ。このようなものを見せてほしい』と言っていた。われわれは、GoogleレンズをARブラウザーに変えたいと考えている。つまり、実際に情報をカメラに重ねることが可能になる」と話す。

筆者は実際に自分の目でGoogleレンズの最新機能を確認した。Googleレンズは、現実を解釈する手段であると同時に、現実を変える手段でもあるという印象を受けるようになった。Googleレンズはほかの言語からの翻訳結果を、あたかもその文字が実際にそこに存在するかのように、標識や物体に違和感なく重ねたり、空間に貼り付けたりできる。これは「Google翻訳」ですでに提供されている機能を進化させたものだが、Googleはドキュメント全体の文脈を分析するようになった。手始めは、レストランのメニューだ。

サンプルのメニューを見ていると、メニューに記載された料理の名称が急にハイライトされた。それらは、Googleマップのレストラン情報に基づく人気メニューだ。メニューの項目をタップすると、写真とレビューコメントがすぐに表示された。

同様のアイデアは美術館向けにも取り組みが進められている。Googleはサンフランシスコのデ・ヤング美術館と協力して、有名作品をGoogleレンズで分析した際に、キュレートされたポップアップ情報が表示されるようにしようとしている。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する