人工知能(AI)業界ウォッチャーと本記事の読者なら、NVIDIAがGPUベースのディープラーニングとAIの巨人であることはご存じだろう。NVIDIAの最高経営責任者(CEO)、Jensen Huang氏は米国時間3月27日、同社の年次イベントGPU Technology Conference(GTC)2018で、同社のGPUハードウェアおよびソフトウェアの大幅なアップデートを発表した。

NVIDIAは同日、自動運転車テストのシミュレーション技術とプロフェッショナル向けグラフィック技術に関するニュースも発表した。

本稿では、AIおよびディープラーニング関連の以下の3点の発表に絞ってお伝えする。

まず大きなニュースは、コアテクノロジそのものだ。Tesla V100 GPUは、既存の製品(16Gバイト)の2倍の32Gバイトのメモリを搭載する。メモリが増えるほど、より深いディープラーニングモデルを扱えるようになり、つまり、モデルの予測性能の精度が上がる。

新しいGPU技術は即日NVIDIAの「DGX Systems」で利用可能になった。それに加えて、Cray、Hewlett Packard Enterprise、IBM、Lenovo、Supermicro、TyanなどのOEMが2018年の第2四半期中に各社の製品で採用していく見込みだ。

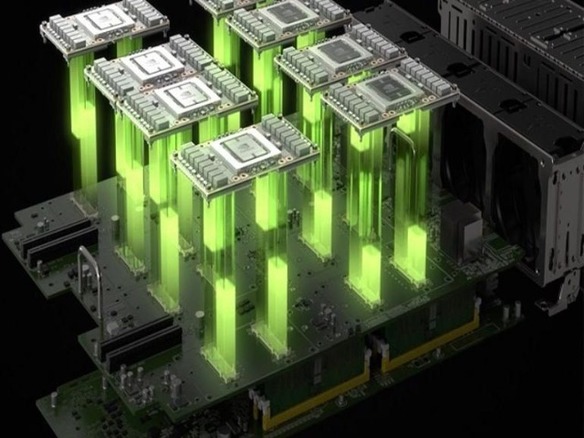

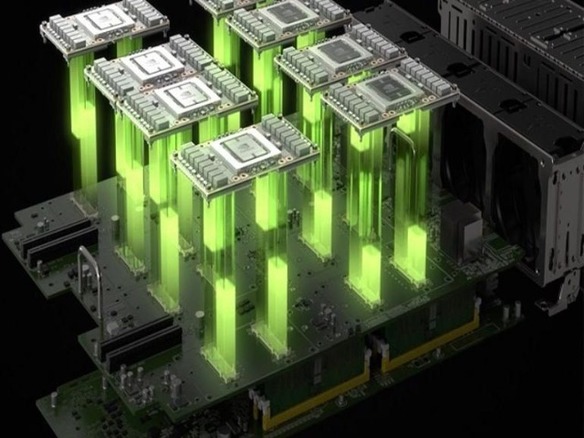

プラットフォームのアップグレードで2つ目のニュースは、「NVSwitch」の発表だ。これは同社のインターコネクト技術「NVLink」を拡張したもので、NVIDIAによると、最高の「PCI Express」スイッチの5倍の帯域幅を提供し、より多くのGPUによる接続を可能にする。その結果、より大きなデータセットを扱え、複数のニューラルネットを並列で訓練できる。

32GバイトのGPUとNVSwitchの発表は、それぞれ印象深いものだ。だがさらに、この2つはNVIDIAの「DGX-1」サーバのアップグレード版に搭載される。「DGX-2」と名付けられた新サーバは、V100 GPUを16基搭載し、メモリは512Gバイトだ。16基のGPUはNVSwitchの働きにより、1つのメモリスペースとして共有される。NVIDIAによると、DGX-2は世界初の2ペタフロップス(毎秒2000兆回の浮動小数点演算を行う)システムであり、「ディープラーニング研究とコンピューティングの限界を押し広げようとしているデータサイエンティストのために構築した」という。

32GバイトのGPUは、ディープラーニングだけでなく、様々な高性能コンピューティング(HPC)分野で活用されるだろう。そのために、NVIDIAは「CUDA」、「TensorRT」、「NVIDIA Collective Communications Library(NCCL)」、「cuDNN」、ロボティックSDK「Isaac」をアップデートした。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する