AIのビジネス活用はさまざまな業種に応用され、広がりを見せている。2月27日に開催された「CNET Japan Live 2018 AI時代の新ビジネスコミュニケーション」のパネルディスカッション「ライブ会場の満足度が見える--AIによる“感情”分析」では、エイベックス グループ戦略室マーケティング・アナリティクスユニットの山田真一氏、日本マイクロソフト パートナー事業本部 クラウドプラクティス技術本部 本部長の田中啓之氏が登壇。

ライブを仕掛けるエイベックスとAI機能の1つである「Cognitive Services」を提供するマイクロソフトが手がけた、エンターテインメント業界におけるAI活用事例として、ライブ会場での観客の“感情”分析について実演を交えて紹介した。モデレーターはCNET Japan編集長の別井貴志が務めた。

2018年に30周年を迎えるエイベックスは「レコード会社」と言われていたころから大きく業態を変え、現在ではNTTドコモとの映像配信サービス「dTV」やサイバーエージェントとの音楽配信サービス「AWA」なども展開。従来型のレコード会社から脱却して、さまざまなエンターテインメントを届ける企業となっている。

山田氏は18年ほどエイベックスに在籍する中で、同社がデジタル領域で成長するとともに、いろいろな事業に携わってきた。現在はマーケティングを担当しているが、デザイナーとしてクリエイティブに関わったこともあるという。今回の取り組みは、最新のテクノロジを使いながら、コンテンツのマーケティングという側面も踏まえて実施したものになるという。

日本マイクロソフトの田中氏は、約11年前に同社に入社。当初はWindows Serverの製品担当としてマーケティングを担当していた。その後、「Microsoft Azure」が登場し、同社のビジネスがクラウドへとシフトしていく中で、パートナー企業とクラウドを使った新しいビジネスを作る仕事に携わってきた。

Microsoftのクラウド製品は大きく分けて、Microsoft Azure、「Office 365」を前身とする「Microsoft 365」、そして「Dynamics 365」の3つ。同社では、これらクラウドの力を使って顧客のビジネスモデルを変えていく、デジタルトランスフォーメーションにフォーカスして事業を展開している。

エイベックスとのエンターテインメント領域におけるAIでの協業をはじめ、「今までのBtoBの領域だけではなく、BtoBtoCの領域でAIをどう活用していくか、という点で相談を受けることが多くなっている」と田中氏は言う。

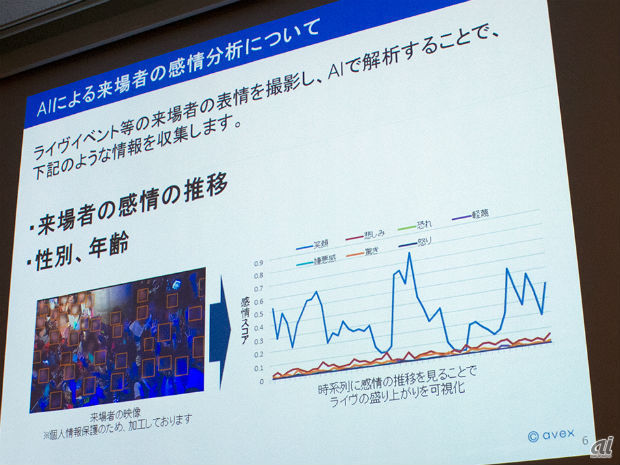

今回の「ライブ来場者の感情分析システム」とはどういうものなのか。山田氏によれば、このシステムはライブ来場者の表情から、感情を数値化する試みである。演者ではなく来場者を撮影することで、顔の表情を検知している。

「このシステムで実際に分かるのは、来場者の感情の推移と性別、年齢。時系列で数値化された感情の推移を見ることで、ライブの盛り上がりを可視化できる」(山田氏)

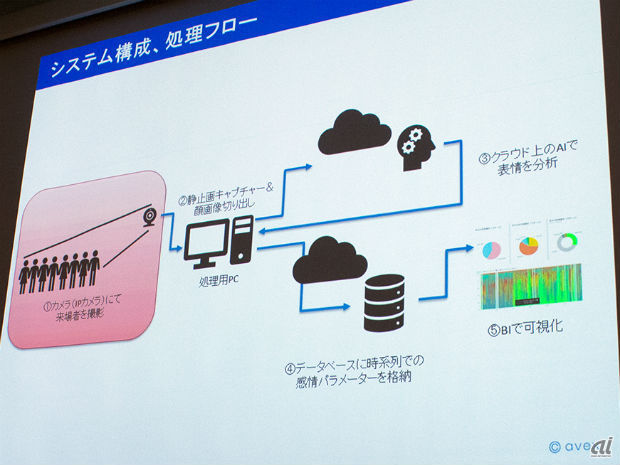

処理のフローは次の通りだ。まず来場者をカメラで撮影する。続いて静止画キャプチャと顔画像の切り出し処理をする。処理用のPCはクラウド上ではなく、別に用意されている。山田氏の説明によると「映像をストリーミングでクラウド上に送ることは簡単にできるが、さまざまなライブの現場では、必ずしも安定したスピードでインターネットに接続できるわけではない。これを踏まえ、まずはローカルのPCで顔画像だけを切り抜いてクラウドに送信している」ということだ。

続いてクラウド上のAIで表情を分析し、さらにそれをデータベースに時系列での感情パラメータとして格納する。最終的にはこれらのデータをBIツールで可視化している。

一連の流れの中では、さまざまなMicrosoft製品が使われている。それぞれの役割については、田中氏から説明があった。

今回、分析に利用されているのは、Microsoft Azureの中にあるCognitive Services。AIは大きく分けて“Specialized AI”と“Generalized AI”に分類される。前者は人間の持つ「目」「耳」「口」といった機能の一部を補完するAI、後者は映画の世界に出てくるキャラクターやロボットのように、人間と同じような思考を持つAIだ。Cognitive Servicesをはじめ、現在利用されているAIは特定の機能を拡張するためのAI、すなわち前者のAIである。

Cognitive Servicesの機能は「視覚」「音声」「言語」「知識」「検索」の5つに分かれ、29のAPI群として公開されている。「開発者などAIに詳しい人なら深層学習や機械学習の技術を使って、AIフレームワークやエンジンを作ることができるが、Microsoftが提供するAIは学習済みのAPIである点が肝だ」と田中氏は言う。

「今すぐにでもAPIを利用できるようにデータベースをMicrosoft側で用意している。さらに学習済みのデータベースだけではなく、例えばエンターテインメントの領域であれば、歌手やアーティストの画像を覚え込ませて、アーティスト名と紐付けるなど、カスタマイズすることも可能だ」(田中氏)

今回のシステムに利用したAPIは「Face API」と呼ばれるもの。これは性別・年齢・感情や顔の向きなどが読み取れるAPIで、感情であれば8種類を認識できる。喜んでいる顔なのか、驚いている顔なのか、といった情報をパラメータとして出力が可能だ。ビジネスに利用する際は、この8つの感情を読み取ることでマーケティングに必要となるデータを網羅できるという。

こうして取得したデータを「Event Hub」を介して「SQL Database」に入れ、「Power BI」で可視化している。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

無限に広がる可能性

無限に広がる可能性

すべての業務を革新する

NPUを搭載したレノボAIパソコンの実力

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する