エイベックスではなぜ、ライブ来場者の感情を分析しようとしたのか。そのきっかけを山田氏に聞いた。

「実はMicrosoftとはほかの事業でも取り組みがあり、その中で彼らの最新のテクノロジを紹介してもらう機会が何度か過去にあった。いくつかのソリューションや製品群を知って、こういう課題にそれが使えるのではないかと思いついたところがスタートだった」(山田氏)

山田氏は「今回の取り組みで、観客の反応が数値化できることは魅力的だった」と言う。「観客の反応を知るには、これまでだと歓声が大きい、拍手が大きいといったレベルでしか測ることができなかった。これはすごく主観的な話で、『今日は歓声が大きかったね』というのはその場にいるその人の感覚でしかない。行っていないと評価できないうえに、主観的でブレがある。客観的な数値として分析することは難しかった」(山田氏)

観客の感情分析にCognitive Serviceが採用されたのは、どういった理由だったのか。

Microsoft本社がある米シアトルには、Microsoftの技術を使って5年先、10年先の未来を展示するEnvisioning Centerという施設がある。田中氏によれば、そこへ定期的に日本のパートナーや顧客を招いて、一緒にビジネスを考える取り組みを年数回実施しているそうだ。

「エイベックスとご一緒したときに、我々のプロトタイプを見てもらい、そこで何らかのインスピレーションを感じてもらえたのかな、と個人的には思っているが」と田中氏が水を向けると、山田氏も「いろいろな気づきを与えてもらっていて、非常に感謝しているし、実際、優れた製品群を作られている、と使ってみて感じているところだ」と応じた。

山田氏は「ほかのAIで同じようなものはないのか、と言えば、ある」と言う。「例えばGoogleやAmazon AWSでも、同じように顔を認識して感情を測ることはできる。ただ、比較検証したうえで、現時点ではCognitive Serviceが優れたソリューションだというところで、安心して使っているのが実態」と話す。

このシステムを使ってライブ会場を分析した回数は、今までのところ10数回。ここまでは技術的検証の色合いが強かった、と山田氏は述べている。

「今日の講演会場は環境としてはよい方で、実際のライブ会場は非常に暗く、ライトの明暗が激しいので、カメラで観客を捉えづらい。元々、演出上の設計では観客が写っていることは考慮されるわけではないので、やはり写らない瞬間がどうしても出てくる」(山田氏)

カメラの性能についても、低照度で写せる機材がどこまで対応できるのか、あるいはカメラの設置位置についても、どういった場所、どういった角度であれば顔の認識精度が上がるのか、そうした点をさまざまな場面でトライして、検証してきたのが現在までの状況だと山田氏は説明する。

ライブと一言で言っても、ノリのいいダンス系もあれば、バラード中心のもの、クラシックなど、さまざまなものがあり、いつも笑顔がよいというわけでもないはずだ。KPI的なものとして、どういう表情がよいか判定するための設定は難しいのではないだろうか。

この問いに、山田氏は「その通りで、笑顔があればすべてがいい、ということではない」と言い、「やはり作り手側が意図したものなのかどうかにかかってくる。喜んでほしいとき、笑ってほしいときに、ちゃんと笑ってくれているのか。バラードで哀しい顔をされているのか。そうしたものを作り手側の意思とともに評価していくのが重要」と答えた。

「今はライブ以外にも、映画や舞台で分析を行っているが(ライブとは)データの出方が全然違う。コンテンツの内容、作り手側の意思、そうしたものを踏まえて総合的な評価をする必要がある。それが我々が先行してデータを集めている理由でもあるし、ノウハウになっていくのではないかと考える」(山田氏)

テクノロジを活用してエンターテインメントを分析することについて、興行主は理解してくれるものなのか。山田氏は「そこはケース・バイ・ケースで、理解していただくまでには、いろいろな形での説得が必要。これまでの実績を踏まえて、やってもらえるケースも出てきている」と話す。

「自社のイベントであっても、なかなか一筋縄ではいかないのが正直なところ。特に大規模な会場になればなるほど、きめ細かな事前の準備がある。手ぶらで行ってカメラを設置させてください、というわけにはいかない。準備に相当の時間もかかるし、テクニカルな意味でも設置が難しい場面も多い。これから、いろいろなライブ、イベントや他の業態でも使えるようにしていくためには、啓蒙活動も含めて、まだまだ努力が必要だと思っているし、チャレンジを繰り返しているところだ」(山田氏)

一方、田中氏は現場での測定に立ち会った感想を、こう話している。「今までどちらかというと、現場の定性的な反応で『うまくいったよね』と評価され、なかなかそれを数値化するのは難しかったと思う。それだと現場にいる人は盛り上がっているが、現場にいない、本社にいるような人は『本当にうまくいっているの?』みたいな感じってあると思う。今日のセミナーにしても、僕は『よい反応だった』と報告するが、何かしらそれを示すデータがなければ、伝わらない。現場感を現場にいない人たちに伝えていく、可視化するということに対し、現場の人たちにもモチベーションがあるのではないか、と思う」(田中氏)

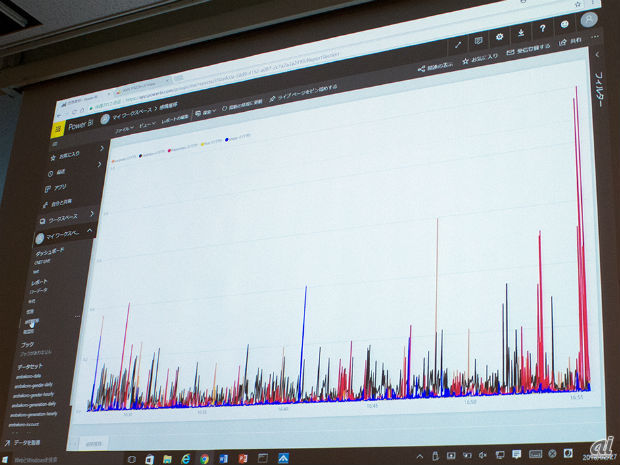

このセッションでは、実際に会場の来場者の感情の動きをリアルタイム分析しており、その様子がその場で紹介された。

会場内の様子をカメラで撮影し、数値化してローデータとして取得。BIツールで分析された結果がグラフで可視化される。まずは男女比、そして年代が円グラフで表示され、その後、感情の動きが時系列の折れ線グラフで表示された。

結果はほぼリアルタイムに近い、数秒のタイムラグで表示される。横を向いていたり、下を向いていたり、マスクをしている人の表情は取れず、データが欠落するため、「可視化はできるが、これを実データとしては見ていない」と山田氏は説明する。

「データサイエンスの領域になってくるが、このデータをもとにして、欠落した部分をどう埋めていくか、というのを後処理として加えて、全体の傾向値や曲単位、シーンごとでの評価を実際には行っている」(山田氏)

開発プロジェクトは、2017年7月はじめにこのシステムを思いついたきっかけがあってからスタートし、2017年7月末にはできあがっていたそうだ。短い開発期間について、山田氏は「一から開発したわけではない」と話している。

「さまざまなパートナー企業と組んで、スピード感をもって取り組んでもらい、実現した。考えたアイデアをすぐに具現化できたのは、Microsoftやパートナー企業の支援あってのことだ」(山田氏)

田中氏も「Azureやクラウドビジネスに携わって長いが、今は3カ月ぐらいで企画からシステム開発を終わらせて、サービスインまで持っていかなければ、クラウド自体がどんどん進化してしまう。コード自体を書き直さなければならなかったり、スクラッチで書いていた部分がAPIになったりして、手戻りがどんどん出てしまう。平均3カ月、どれだけ長くても半年以内でサービスリリースする、というのがほかの顧客も含めて多くなっている」と言う。エイベックスではクラウドに関しての実験や研究開発も進めていたため、より早くリリースが実現したということだった。

順調に進んだ開発だが、中でも苦労した点はAIではなく、カメラの部分だったようだ。当初はHDカメラを使っていたが、せいぜい30人程度の少人数しか撮影できなかった、と山田氏は言う。「これはライブに来ている1割ぐらいのレベル。サンプリングとしてはいいのかもしれないが、撮影する客席の部分にある年代や性質の人が偏っていると、データとしての信頼性が失われる。最初はそのあたりでの試行錯誤が多かった」(山田氏)

田中氏がカメラに関連して、日本マイクロソフトの社内イベントでの似たような取り組みについて紹介した。「年1回、日本マイクロソフトの社員総会が行われる。そこで、感情分析ではなく、こうしたセミナーなどでもありがちな『寝ている人』を発見するという、パートナーが開発したソリューションを利用したことがあるのだが、そこでもカメラで撮る範囲が課題になった」(田中氏)

「会場の後ろの方や、立体になっている席の上の方を撮るのはすごく難しい。では本当に、全体を撮らなければならないのか。エイベックスともディスカッションしたが、統計論的な話でもあって、会場のどれくらいを撮れば全体感が分かるのか、といったところについては手探りで、今でも検討されていると思う」(田中氏)

また「全体を網羅するようなカメラを設置したときには、画像の処理が重くなる」とも田中氏は言い、「そのあたりのバランスがすごく難しいのではないか」と述べた。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する