NVIDIAは2022年中に、新たな人工知能(AI)アクセラレーターの販売を開始する。AIコンピューティング革命を主導する立場を確かなものにする取り組みの一環だ。

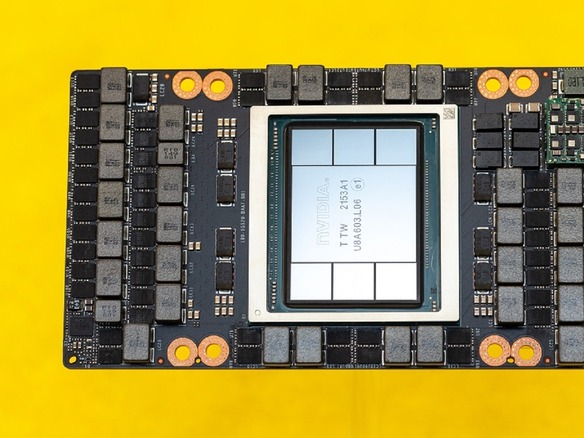

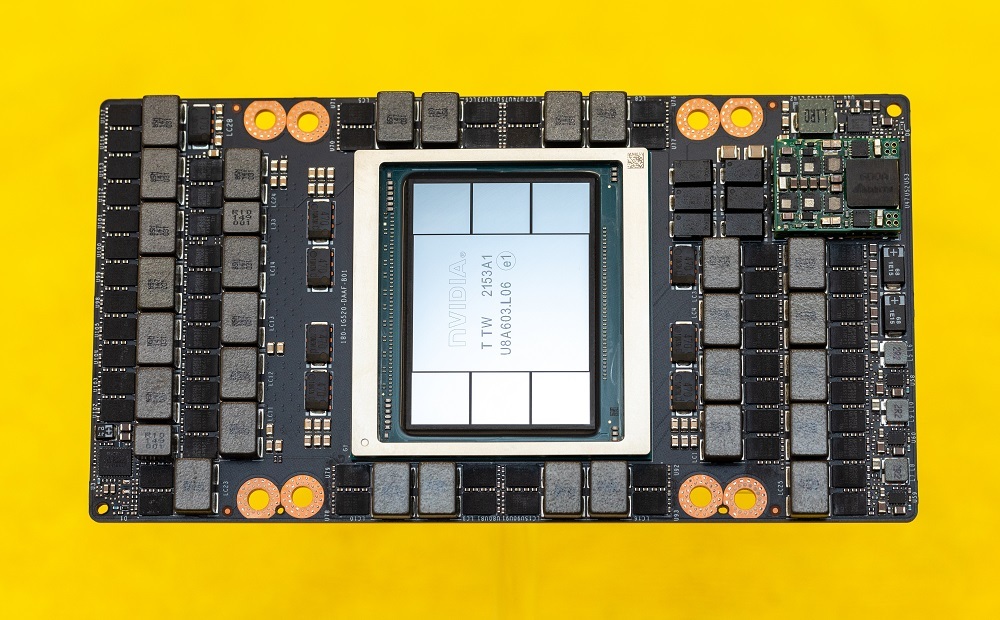

この「H100」は、「Hopper」アーキテクチャー採用のプロセッサーで、NVIDIAの最高経営責任者(CEO)Jensen Huang氏が3月に発表した。AI開発者が研究を加速させ、特に人間の言語の理解や、自動運転車のルート設定といった複雑な課題に対して、より高度なAIモデルを構築できるように設計されている。同製品は、第3四半期に出荷が開始される見込みだ。

H100は、800億個ものトランジスターを搭載し、サイズは814平方ミリメートルと、現在のチップ製造設備で物理的に可能な大きさのほぼ上限に等しい。

H100は、AMDの「MI250X」やGoogleの「TPU v4」、Intelの次期「Ponte Vecchio」のような、巨大で消費電力の多いAIプロセッサーと競合する。このような製品は、AIトレーニングシステムに適した環境、すなわち、コンピューティング機器のラックがぎっしりと並び、太い銅製の電源ケーブルが張り巡らされたデータセンターで最もよく見られるタイプの大型チップだ。

H100は、NVIDIAがビデオゲーム用GPUの開発元から、AI分野の有力企業へと進化を遂げたことを体現している。同社はAI特有の数学的処理にGPUを適応させることで、これを実現した。

スマートフォン「iPhone」から、世界最速スーパーコンピューター候補の「Aurora」まで、AIがあらゆるものに搭載される中で、AIを高速化する回路の重要性は高まるばかりだ。AIモデルを訓練して発話を別の言語にリアルタイムで翻訳したり、動画のキャプションを自動生成したりするタスクを高速化するには、H100のようなチップが欠かせない。パフォーマンスが高速化するほど、AI開発者は自動運転車のような難易度の高いタスクに取り組んだり、実験のペースを速めたりできるようになる。中でも大きな進展が期待できるのは、言語処理の分野だ。

AIシステムのトレーニングに際しては、膨大な量の情報を処理しなければならない。たとえば10万件の音声データを、それぞれ複数の方法で処理し、周囲の話し声や接続状況の悪い通話などをシミュレートするといったことが必要だ。メモリーの拡張や処理の高速化など、H100のもたらす向上がAIを利用する顧客にとって重要な理由はそこにある。

NVIDIAによると、同社が2年前に発売した旧世代の「A100」と比較して、H100は全体的な処理速度が推定6倍向上しているという。そして、その恩恵を間違いなく受ける重要な分野の1つが、自然言語処理(NLP)だ。このAI領域は、コンピューターが話し言葉を理解したり、文書を要約したり、言語を翻訳したりといったタスクを支援する。

NVIDIAは、AIの先駆的分野であるNLPの強力なプレーヤーだ。GoogleのAIシステム「PaLM」は、文中の因果関係を把握したり、プログラミングコードを記述したり、ジョークを説明したり、絵文字で何の映画か当てるゲームをプレイしたりできる。しかし、研究者の間で人気があるのは、柔軟性の高いNVIDIAのGPUだ。例えば、「Facebook」を運営するMetaは先ごろ、AI研究を加速させる高度なNLP技術を無料で公開すると発表しており、このシステムは16基のNVIDIA製GPUで動作する。

H100を利用すれば、NLPの研究者や製品開発者は、より迅速に仕事をこなせるようになると、NVIDIAでハイパースケールおよびハイパフォーマンスコンピューティンググループのバイスプレジデントを務めるIan Buck氏は言う。「数カ月かかっていたことが、1週間足らずに短縮されるはずだ」と同氏は語った。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス

CES2024で示した未来

CES2024で示した未来

ものづくりの革新と社会課題の解決

ニコンが描く「人と機械が共創する社会」

近い将来「キャッシュレスがベース」に--インフキュリオン社長らが語る「現金大国」に押し寄せる変化

近い将来「キャッシュレスがベース」に--インフキュリオン社長らが語る「現金大国」に押し寄せる変化

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「当たり前の作業を見直す」ことでパレット管理を効率化--TOTOとユーピーアールが物流2024年問題に挑む

「当たり前の作業を見直す」ことでパレット管理を効率化--TOTOとユーピーアールが物流2024年問題に挑む

ハウスコム田村社長に聞く--「ひと昔前よりはいい」ではだめ、風通しの良い職場が顧客満足度を高める

ハウスコム田村社長に聞く--「ひと昔前よりはいい」ではだめ、風通しの良い職場が顧客満足度を高める

「Twitch」ダン・クランシーCEOに聞く--演劇専攻やGoogle在籍で得たもの、VTuberの存在感や日本市場の展望

「Twitch」ダン・クランシーCEOに聞く--演劇専攻やGoogle在籍で得たもの、VTuberの存在感や日本市場の展望