筆者は、暖かい9月のある日に、ニューヨークにあるホテルのテラスで前屈みになって実際には存在しない愛らしいペットを撫でていた。バーチャルペットである「ペリドット」は、あたりを飛び跳ねながら筆者を追いかけてきた。それは、筆者がこれまでにスマートフォンや「Meta Quest 3」などのヘッドセットでバーチャルペットと触れあったときの経験と似ていたが、今回は、明るい日中でもその仮想体験をはっきりと見られるように、自動調光でサングラスのようになった透過レンズを通してそれを見ていた。筆者が身に付けていたのは、大ぶりでかさばるが、スタンドアロンで動作するARグラスである最新版「Spectacles」だ。このARグラスは、将来筆者が身につけることになる未来のデバイスの先駆けなのだろうか。もしそうなら、いつ頃実現するのだろうか。

筆者は2024年に入ってから、Appleの「Vision Pro」を着けて屋外でスキーやスケートをしたり、公園に行ったりする人気の動画をいくつも見た。Vision ProやMeta Quest 3は、屋外で日常的に使うようには設計されていないが、Spectaclesはそれを意図して作られている。この製品はSnapがロサンゼルスで開催した開発者向けカンファレンスで発表したもので、同社が何年も前から開発しているSpectaclesシリーズの最新モデルだ。Snapが最初にスタンドアロン型のARグラスを発表したのは2021年で、筆者は当時、コロナ禍の中、自宅の裏庭でそれを試した。今回の新型はさらにかさばるようになったが、同時にパワーも増している。このARグラスは、Vision ProやMeta Quest 3と同じく手の動きを認識するハンドトラッキング機能を備えているほか、独自のOSである「Snap OS」を搭載しており、ブラウザーを実行したり、さまざまなアプリを起動したり、近くにあるスマートフォンと連携したりする機能を持っている。

Spectaclesはそもそも一般ユーザー向けの製品ではない。これは開発者向けのハードウェアであり、同社の開発者向けキットの一部として、月額99ドル(約1万4000円)のサブスクリプション形式でのみ提供されている。このことは、Snapが、ARグラスはまだ世間に受け入れられる状況にはなく、一般消費者向けの技術でもないと認識していることを示している。同社は、他の競合他社よりも足場づくりで少し先行しようとしているのだ。

Metaなどの他の企業は(おそらくはGoogleやAppleもだが)、MRを実現できるゴーグルの大きさの問題を克服した、できるだけ小型のARグラスを作ろうとしている。筆者はこれまで、そうしたスマートグラスを作ろうとする試みをいくつも見てきたが、その種の機能を持たせた上でARグラスを小型化するには、スマートフォンや、コンピューターや、何らかの外部プロセッサーに接続する必要があった。

ところがSpectaclesにはプロセッサーとバッテリーが内蔵されており、他のものと接続する必要がないため、余分なケーブルが不要で装着しやすい。その一方で、形状は大きくかさばり、デザインもほかのスマートグラスと比べずっと不格好なものになっている。フレームはかなり太く、レンズの中央には導光板の役割を果たす虹色の部分があり、横にマウントされたLCOS方式の小型プロジェクターから投影された仮想的なイメージがそこに反射するようになっている。

バッテリーの持続時間も非常に短く、わずか約45分しか持たないため、一日中使うことなど考えられない。ただしこのARグラスは、Snapが2021年に出したものと同じく開発者向けに作られたものだ。Snapの最高技術責任者(CTO)で共同創業者のBobby Murphy氏によれば、この製品は、眼鏡の形にすることで、「Snapchat」のARレンズ(カメラで撮影された映像をリアルタイムで加工するフィルター)の有用性を高められるかどうかを調べるために作った実験的なデバイスなのだという。

これはSnapが2021年に採用したアプローチとまったく同じだが、今回は処理能力が向上している。Qualcommのプロセッサーが2つ搭載されており(どれを使用しているかは教えてもらえなかった)、ラグが生じることもあるが、グラフィックはかなりキビキビとしている。Spectaclesの視野角は46度しかなく、これはARグラスとしては合格点だが、VRヘッドセットと比べればかなり狭いと言わざるを得ない。筆者が試してみた経験では、まるで大きなスマートフォン画面のような縦長の窓から複合現実を見ているように感じられた。

2021年版のデモとは大きく違った点の1つが、度付きレンズを取り付けられたことだ。前回は自分の目にコンタクトレンズを入れる必要があったが、今回はMetaやAppleが提供しているような取り付け式のレンズを利用できた。残念ながら、今回のSnapは筆者の視力に関する処方箋を持っていたわけではないため、ARの視野はややぼやけていたが、その体験がどんなものかを知るには十分だった。

Spectaclesはカメラを使って周囲を把握しており、AppleのVision ProやMetaのQuestヘッドセットと同じようなハンドトラッキング機能も備えている。そのため、仮想的なボタンを押したり、バーチャルな生き物を撫でたり、空中に絵を描いたり、遠くにあるものをつまんだりすることができた。Snap OSには空中に浮かんで表示されるアプリのダッシュボードが存在するほか、手のひらを自分の方に向けるとその上に仮想的なボタンが現れ、それを使って操作することができる。

ただしSpectaclesにはアイトラッキング機能がないため、何かを選択するにはAppleのVision Proよりも手間がかかる。またスマートフォンと接続して、もう1つの操作手段として利用することもできる。

MetaやAppleとは方向性が異なっているSnapのアプローチの1つが、スマートフォンとの連携だ。筆者は、スマートフォンを使ってSpectaclesのAR体験を操作するデモをいくつか試してみた。その中には、スマホをリモコンのように使って画面上のボタンでARのヘリコプターを操作し、部屋の中で飛ばすものもあった。また、スマートフォンをゴルフクラブに見立てて、それを振ることでAR上のゴルフコースでティーショットを行うこともできた。それは半ば、自分が泊まっていたホテルの部屋にゴルフコースがテレポートしてきたかのようだった。

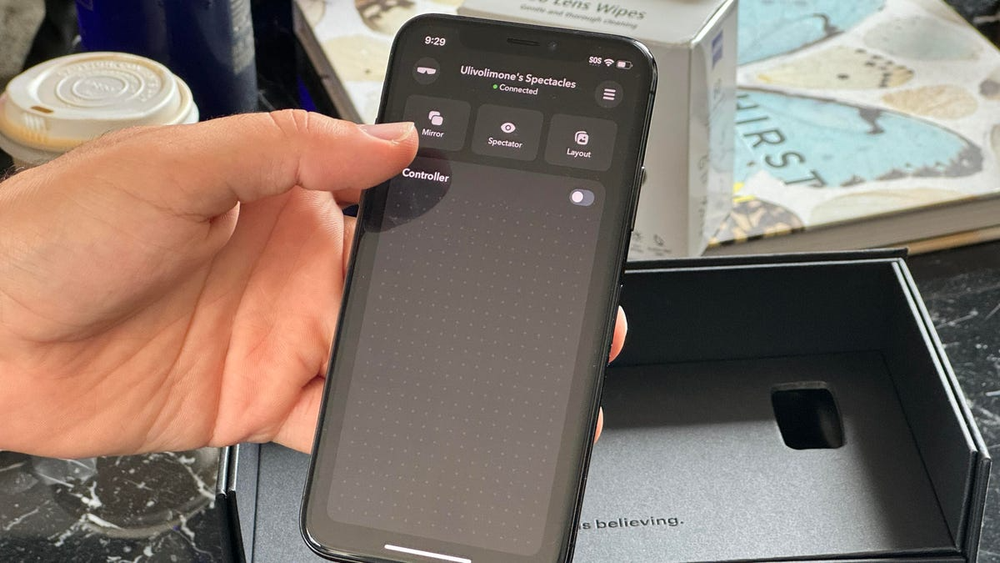

Snapのスマートフォンアプリである「Snapchat」を使ってSpectaclesを管理したり、他の誰かに自分がARグラスを通して見ている体験を見せることもできる。Snapによれば、長期的には、スマートフォンアプリのSnapchatからSpectaclesとやりとりできるようにすることを目指しているという。

Murphy氏は筆者の取材に対し、「私たちは、スマートフォンとSpectaclesの連携にはまだ多くの可能性があると考えており、今後も模索を続けていく」と語った。

ただし現時点では、Spectaclesを着けている人同士の連携しかできない。これにはそれなりの理由がある。スマートフォンのOSは、ARグラスとあまり相性がよくないのだ。AppleとGoogleはどちらも、スマートフォン用のOSとヘッドセットやスマートグラスを統合するための取り組みには手を着けていない。この動きが進むまでは、専用のスマートフォンアプリを使うか、XREALのように独自のスマートフォン的なハードウェアを作らない限り、ARグラスメーカーは相互運用のボトルネックに悩まされ続けるだろう。それが実現したとしても、連携は理想的な形にはならないはずだ。

SnapのスマートフォンアプリであるSnapchatには、周囲をスキャンしてコラボレーションを行うためのツールから、位置情報に特化したARまで、多種多様なARツールがすでに存在している。2021年以降、SnapのARに関する技術力はさらに向上しており、この新型ARグラスでもその利点は生かせるはずだ。

筆者は、他の人と一緒に絵を描く作業も試してみた。これは、筆者が指を使って空中に絵を描いている傍らで、別のSpectaclesを着けたSnapのチームの1人が一緒に絵を描くという作業だ。このARグラスは、近くにいる他の装着者を認識して体験を共有できる上に、4つの内蔵カメラで部屋をスキャンしてメッシュ化し、複合現実の中で協調作業を行うこともできる。

ホテルの部屋での接続には時々ラグも発生したが、ARグラス同士で協調作業ができることは、Spectaclesの大きな売りの1つだ。Snapは、複数人のグループに屋外で一緒に使ってもらうことで(美術館やアートショーなどで使うことも考えられるかもしれない)、こうしたARグラスが没入型のライブイベントでどのような効果を発揮するかを試してもらうおうとしている。ARでレゴブロックを組み立てる体験も、シンプルではあったが、大勢の人が一緒にその場所に合う彫刻を作れるかもしれないという可能性を見せてくれた。

Spectaclesは屋外での使用を想定しており、「Magic Leap 2」の技術に似た自動調光レンズを搭載している。Magic Leap 2には、大型の外付けプロセッサーが用意されている。

初期からのSnapのパートナーには、将来の屋外でのARグラス利用を模索している企業であり、「Pokemon GO」で有名なNianticが含まれている。また、VRヘッドセットやMRヘッドセット向けの「スター・ウォーズ」や「Marvel」の作品を制作しているILM Immersiveも同社のパートナーだ。

SnapはOpenAIとも提携しているが、これは2024年に見られる動きとしてはまったく不思議ではないだろう。春には、「Ray-Ban Metaスマートグラス」やHumaneの「Ai Pin」といったカメラを搭載したAIウェアラブルがいくつも登場し、カメラや音声入力を利用してユーザーを支援したり、生成AIを使ったクリエイティブな作業を行うアプリに利用できる「マルチモーダル生成AI」の可能性を示そうとした。一方、Meta Quest 3やApple Vision ProのようなMRヘッドセットでは、開発者のカメラの利用許可が制限されており、カメラを使ったAIの可能性には踏み込めていない。

Snapはカメラへのアクセスをより開放しており、OpenAIが提供する連携機能では、Spectaclesのカメラやマイクを使って、スマートフォンアプリのSnapchatで利用できるものに似た生成AIレンズアプリを実現している(Snapは、ARアプリにもカメラの利用を開放しているが、これらのアプリのオンラインアクセスは制限されている一方で、OpenAIの接続にはオンラインでのカメラ利用を許している)。

Murphy氏はこの問題について、「人々が外部サービスを使いたいと思うようなものに関しては、注意深く管理しつつ、開発者やサードパーティーのサービスプロバイダーと協力して、この種の安全対策を構築していく可能性がある」としている。スマートフォンアプリのSnapchatには、すでにカメラを利用する生成AIツールが搭載されているが、そうした機能の一部が、ようやくARグラスでも使えるようになるのかもしれない。

筆者は、Snapの生成AI機能を使って3Dの絵文字を作ったり、音声による操作を理解してくれる、太陽系を見る教育用のレンズアプリを操作したりしてみた。デモの応答にはラグがあり、筆者の言うことがうまく理解してもらえないこともあった(ただしこれは、ホテルの部屋のネットワーク接続などの問題だった可能性もある)。SnapがAIを使ったARアプリにカメラを開放したことは、MetaやAppleの現状よりも一歩先行しているように感じられる。もっとも、この状況が近いうちに変わる可能性もあるだろう。

この記事は海外Ziff Davis発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する