アンデルセンの童話「人魚姫」をもとにしたDisneyアニメ「リトル・マーメイド」で、主人公アリエルは海の魔女アースラにだまされ、声を奪われる。アリエルは声を失ってはじめて、声が自分を形作っている大切なものだったことに気づく。

人魚姫の物語が現実になったかのような出来事が起きた。自分の声は誰のものか、自分の声が知らないうちに誰かに模倣され、金儲けに利用されたらどうすべきかという問題について、映画スターのScarlett Johanssonさんが声を上げたのだ。

Johanssonさんは、OpenAIから最新の生成AIツール「ChatGPT-4o」に声を使わせてほしいと依頼されたが、断った。しかし、OpenAIの最高経営責任者(CEO)Sam Altman氏は、似た声を持つ別の俳優の声を使ってAI音声を作り、GPT-4oに搭載した。Johanssonさんの声を意図して真似たわけではないと主張したが、この弁明は空虚に響く。というのも、OpenAIがGPT-4oを発表したその日、同氏は「her」と一言だけ書いてXに投稿した。これは、Johanssonさんが女性を模したAIアシスタント「サマンサ」の声を演じた2013年のSF映画のタイトルだ。

事の真相は分からないが、Johanssonさんが置かれている状況は、すべての人にとっての警告とも言える。私たちは自分の声を自分の一部だと感じているが、AIが作り出した世界は、声とその所有者の関係を脅かす。本人が自ら提供したものであれ、奪われたものであれ、AIは「声」を使って、本人が言ったことのないことを言わせることができるからだ。

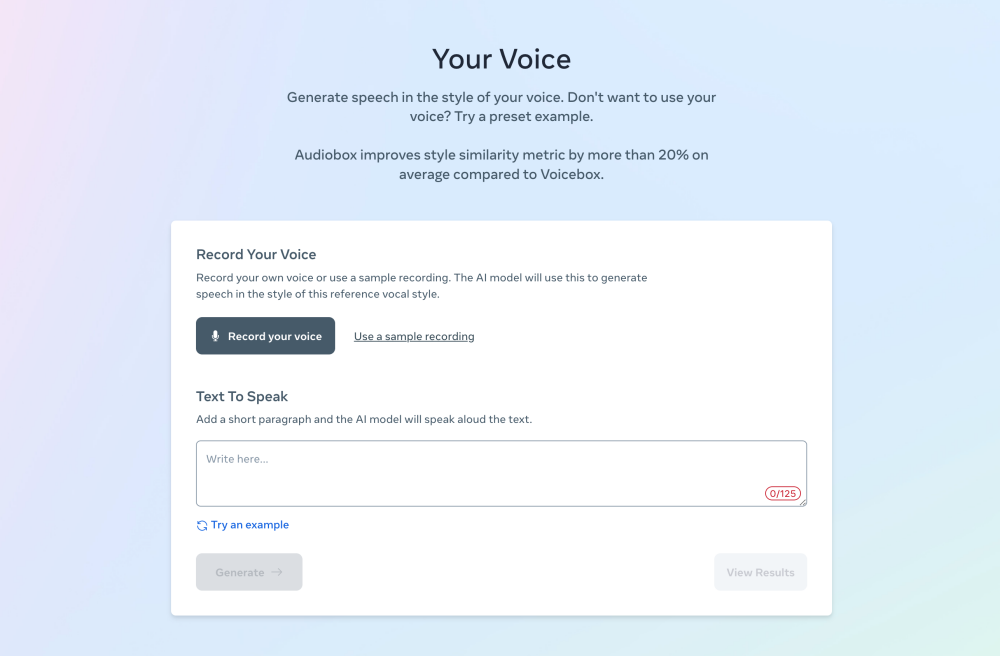

先日、筆者も似たような体験をした。筆者は5月にパリで開催された技術カンファレンス「VivaTech」で、Metaが2023年夏に発表したAI音声生成ツール「Audiobox」を試す機会を得た。このツールは、ユーザーが録音した声をもとに、その声を合成し、まるで本人が話しているかのようにテキストを読み上げる(デモ版が公開されている)。

筆者はさっそく「iPad」を使って自分の声を数秒間録音し、読み上げてほしい文章をツールに入力した。すると1分もしないうちに、ツールは筆者の声で文章を読み上げた。iPadから、一度も言ったことのない文章を読み上げる自分の声が聞こえてくるのは、気味の悪い体験だった。

Metaのプライバシーポリシーによれば、AudioboxのAI音声は本人が使うことを想定している。しかしElevenLabsやSpeechifyなど、人間の声のAIバージョンを作成する企業は続々と登場している。今回のデモでは、筆者は自分の声を自分の意思で提供した。しかし、ラジオやテレビ、「YouTube」の動画やポッドキャストから声を拾い、本人の許可を得ずに勝手にAIクローン化することも不可能ではない。最も狙われやすいのは、声が出回っている著名人だ。しかし、ボイスメモや留守電にも範囲を広げれば、標的になる可能性は誰にでもある。

米国の選挙で、AIを使って生成されたJoe Biden大統領のニセ音声が使われたことを思い出してほしい。

AI時代には、自分の声がなりすまし被害にあう可能性を覚悟しなければならない。最近は写真を見てもAI生成ではないかと疑うようになったが、今後は聞こえてきたものが必ずしも真実とは限らないという現実も受け入れる必要がある。

何事も額面通りには受け取れない時代には、これまで以上に信頼が重要になる。テクノロジーの作り手は、自分たちは正しいことをしており、信頼できる人間だということを、テクノロジーの使い手、つまり一般の人々に示す必要がある。これはMetaやGoogleなら百も承知のことだろう。こうした企業は世間の厳しい目にさらされ、製品の信頼性と安全性に関する方針や、その実践状況を精査されてきた。まだ不安はあるものの、多くの人は各社の努力を理解し、現在の立ち位置を把握している。

OpenAIのような、まだ信頼性や安全性を認められていない新しい企業は、まず信頼できる企業という地位を獲得しなければならない。しかし、OpenAIは早々につまずいた。

OpenAIは、ChatGPT-4oの学習にJohanssonさんの声を使わなかったかもしれない。しかし、本人の意向を無視して、似た声を作る方法を見つけ出した。これは同社が声を真似ても問題ないと考えていることをはっきりと示している。それだけではない。声の使用を断られたにもかかわらず、似たような声を採用したことを考えると、OpenAIには声の使用に同意しないというJohanssonさんの意思を尊重する気さえなかったことが分かる。

もっとも、Altman氏はこの見方を否定している。OpenAIは声明を発表し、Johanssonさんに声をかける前から、チャットボット「Sky」の声を担当する俳優は決まっていたと主張した。そして「Johanssonさんに敬意を表するため、Skyの音声の使用を一時停止」し、「コミュニケーションが十分でなかったことをJohanssonさんにお詫びしたい」と述べた。OpenAIにさらなるコメントを求めたが、回答は得られなかった。

この同意の問題は、大規模言語モデルのトレーニングに使用されたテキストをめぐり、OpenAIとMicrosoftを相手取って起こされた著作権訴訟でも核心部分となっている。

AI企業AnthropicのCEO、Dario Amodei氏はVivaTechで、AIの登場によって著作権や知的財産の所有権の問題は「やや曖昧」になったと語った。Amodei氏は、チャットボット「Claude」を開発するAnthropicの創業者だが、以前はOpenAIで働いており、これまでもOpenAIを批判してきた。AnthropicのAIは、現時点ではテキストにしか対応しておらず、「他の手段」は取り入れていない。これは、こうした複雑な問題があるからだとAmodei氏は言う。

AIがますます賢くなり、できることが増えていけば、いずれ人間にできることを、時には不快な形で侵害するようになる。その現実に、私たちは社会として取り組まなければならないとAmodei氏は指摘する。

そのタイミングはすでに来ている、というのが筆者の考えだ。

過去の技術と同様に、AIも逸脱を防ぐ「ガードレール」が整備される前に人々の生活に登場した。各国政府は今、この技術のあり方を正し、テクノロジー企業が順守すべきルールを整備しようと躍起になっている。例えば米連邦通信委員会(FCC)は2月、ロボコール(自動音声電話)にAIで生成した音声を使用することを違法と判断した。

この議論が示しているように、私たちは自分の声を完全に守ることはできないかもしれない。しかしテレビやラジオ、電話、PCから聞こえてくる声は本人のものとは限らないという事実を頭に入れておくことで、AIがもたらす新世界で自分を守ることができるはずだ。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する