人工知能(AI)スタートアップのAnthropicが提供する大規模言語モデル(LLM)「Claude 3 Opus」が米国時間3月26日、AIチャットボットの能力を比較できる「Chatbot Arena」のランキングで、OpenAIの「GPT-4」を抜いて、首位に輝いた。

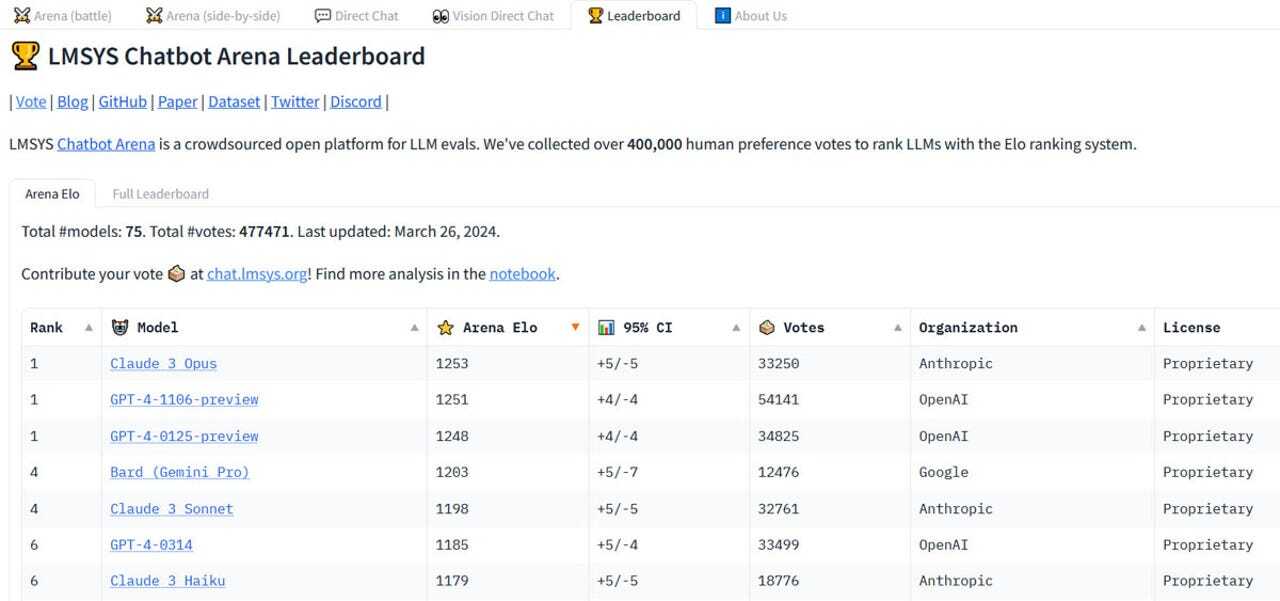

Chatbot Arenaは、さまざまなAIモデルの有効性をテストし、比較できるサイトだ。カリフォルニア大学バークレー校の学生と教授陣らによる、オープンな研究組織Large Model Systems Organization(LMSYS Org)が、2023年5月に立ち上げた。Claudeは今回初めて、同サイトのリーダーボード(順位表)でGPT-4モデルを2位に押しやり、トップに立った。

Claude 3 Opusは開発者向けAPIとClaude 3ウェブサイトで利用できる。Claude 3の3つのモデルの1つで、ほかに「Sonnet」と「Haiku」がある。同社によると、Claude 3は従来の「Claude 2」「Claude 2.1」と同程度のスピードだが、その知識ははるかに高度だという。

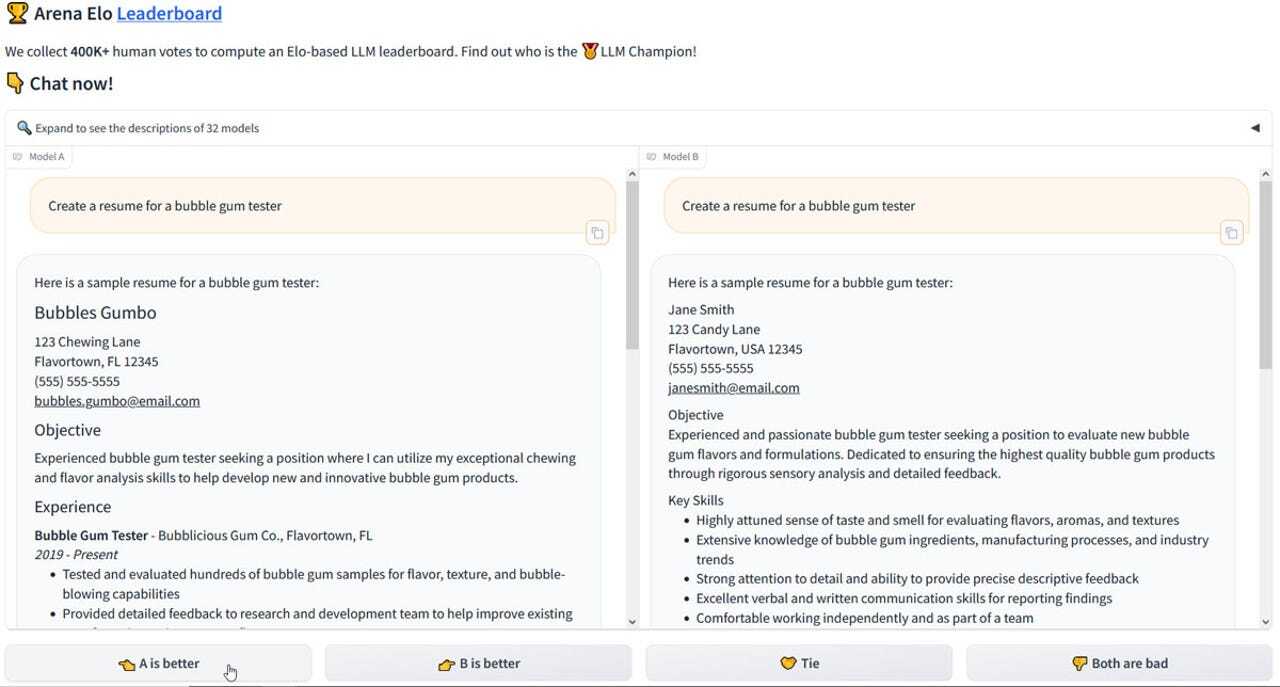

Chatbot Arenaはクラウドソーシングの手法を用いており、誰でも利用できる。チャットページでは、Claude、「GPT-3.5」、GPT-4のほか、Googleの「Gemini」、Metaの「Llama 2」など、32種類のAIモデルの中から、2つのモデルの回答が表示される。プロンプトを入力すると、2つの回答は「モデルA」および「モデルB」として提供され、どのAIモデルによる回答なのかは知らされない。

ユーザーはそれぞれの回答を読んだ後に、AとBのどちらを好むか、あるいは同等だと見なすかを選択する。評価を送信して初めて、2つのAIモデルが明かされるようになっている。

LMYSY Orgはユーザーの投票を基に、相対評価で実力を示すイロ(Elo)レーティングを用いて、LLMランキングを決定する。最新のリーダーボードでは、Claude 3 Opusが1253のスコアを獲得して首位に立ち、「GPT-4-1106-preview」がスコア1251で2位となった。

最新ランキングで評価が高かったその他のLLMには、「GPT-4-0125-preview」、Googleの「Gemini Pro」、「Claude 3 Sonnet」「GPT-4-0314」「Claude 3 Haiku」などがある。トップ10に、Anthropicの最新のClaude 3モデルがすべてランクインしているのは、注目に値するだろう。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス

誰でも、かんたん3D空間作成

誰でも、かんたん3D空間作成

企業や自治体、教育機関で再び注目を集める

身近なメタバース活用を実現する

CES2024で示した未来

CES2024で示した未来

ものづくりの革新と社会課題の解決

ニコンが描く「人と機械が共創する社会」

脱炭素のために”家”ができること

脱炭素のために”家”ができること

パナソニックのV2H蓄電システムで創る

エコなのに快適な未来の住宅環境