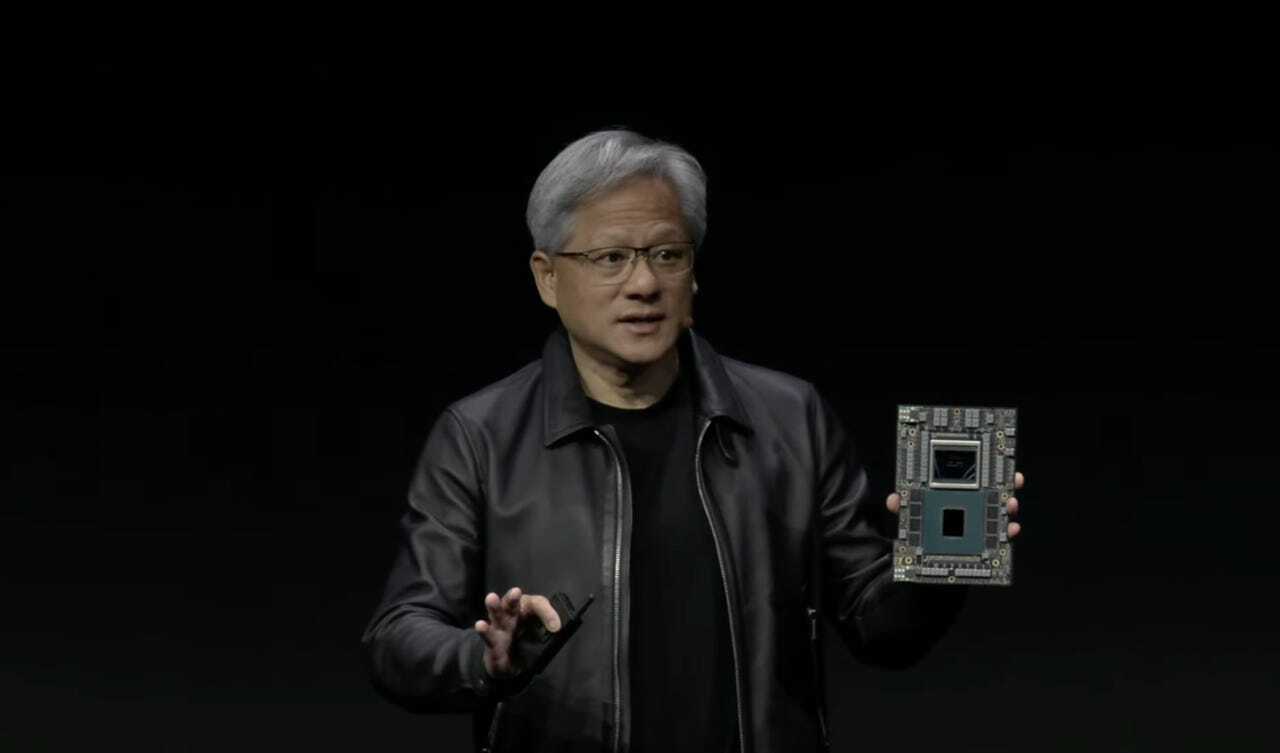

NVIDIAは、同社が命名した「スーパーチップ」の強化版として、HBM3eメモリーを搭載する次世代「NVIDIA GH200 Grace Hopper Superchip」を発表した。

これを搭載するシステムは2024年第2四半期に提供が始まる見込みだ。最高経営責任者(CEO)Jensen Huang氏が米国時間8月8日、ロサンゼルスで開催されているコンピューターグラフィックスの年次カンファレンス「SIGGRAPH」の基調講演で語った。次世代GH200 Grace Hopperは、CPUとGPUを組み込み、より高速なメモリーを搭載することで、回路を行き来するデータの大容量化を実現している。

これは、2023年に入って発表されたGrace Hopperの次期バージョンだ。初期バージョンは、すでにDellなどのコンピューターに搭載されて出荷されている。

初代のGrace Hopperでは、「Hopper」GPUにデータを転送する広帯域幅メモリー(HBM)の容量は96GBだが、新GH200では、HBM規格の次期バージョンであるHBM3eの容量が141GBになる。HBM3eにより、GPUに転送されるデータレートは初代Grace Hopperの毎秒4TBから5TBに高速化する。

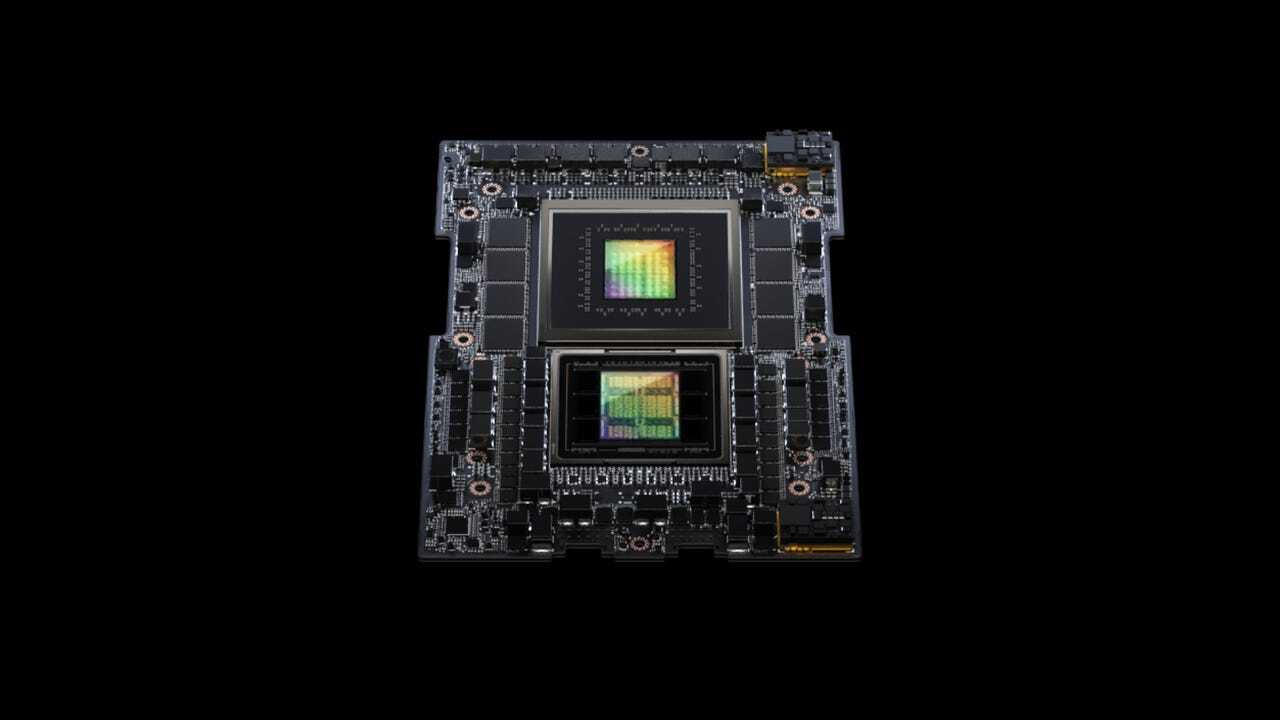

次世代GH200は初代と同様、ArmベースのGrace CPUと、Hopper GPUを搭載している。これらは回路基板上で、高速かつキャッシュコヒーレントなメモリーインターフェース「NVLink」によって接続されている。このNVLinkを通じて、Hopper GPUはCPUのDRAMメモリーにアクセスする。

Huang氏の説明によると、GH200をデュアル構成のサーバー内で第2のGH200に接続することで、HBM3eメモリーの帯域幅は合計10TBになるという。

NVIDIAは過去にも、GPUパーツのメモリー速度をアップグレードしてきた。例えば、「Ampere」アーキテクチャをベースにした前世代のGPU「A100」は、HBM2からHBM2eに移行した。

以前のGPUメモリー標準だったGDDRからHBMへの移行は2015年に始まったが、それをけん引したのは、ビデオゲームグラフィックス用の4Kディスプレイのメモリー需要増だった。HBMは積層型のメモリー構成で、個々のメモリーダイが互いに垂直に積み重ねられ、各チップを貫通する「シリコン貫通ビア」を介して、各チップ間の表面にはんだ付けされた「マイクロバンプ」に接続される。

AIプログラム、特に「ChatGPT」のような生成系AIは、メモリーを大量に消費する。というのも、膨大な数のニューラルの「重み」、すなわちパラメーターを保存する必要があるからだ。ニューラルネットワークにおいては、主要な機能単位である行列がパラメーターになる。これらの重みは、大規模言語モデルのような生成系AIプログラムの新しいバージョンが出るたびに増加し、1兆個のパラメーターに向かう傾向にある。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する