人工知能(AI)の進歩に伴い、かつてないほど多くのロボットやオートメーションを活用する未来が期待される。家の中をうまく移動するロボット掃除機や、動物のペットを楽しませてくれるロボットペット、週末の作業を代行してくれるロボット草刈り機など、それらは既に私たちの身の回りに存在する。私たちは、「宇宙家族ジェットソン」の世界を実際に生きる日々に少しずつ近づいているようだ。しかし、あれほど賢く見えるロボットにも限界というものがある。

Google DeepMindは、ロボット制御用のVLA(ビジョンランゲージアクション)モデル「RT-2」を発表した。ロボティクスの能力を実質的に数レベル引き上げるものだ。このシステムは、「ChatGPT」や「Bing」のトレーニングを支える大規模言語モデル(LLM)とほぼ同様に、インターネットからのテキストデータと画像でトレーニングされている。

私たちの家庭にあるロボットは、プログラムされた単純なタスクを実行できる。例えば、床を掃除するというタスクの場合、左側のセンサーが壁を検出すると、それを避けて移動しようとする。しかし、従来のロボット制御システムは、新しい状況や予期せぬ変化に対処するようにはプログラムされていない。また通常、同時に複数のタスクを実行できない。

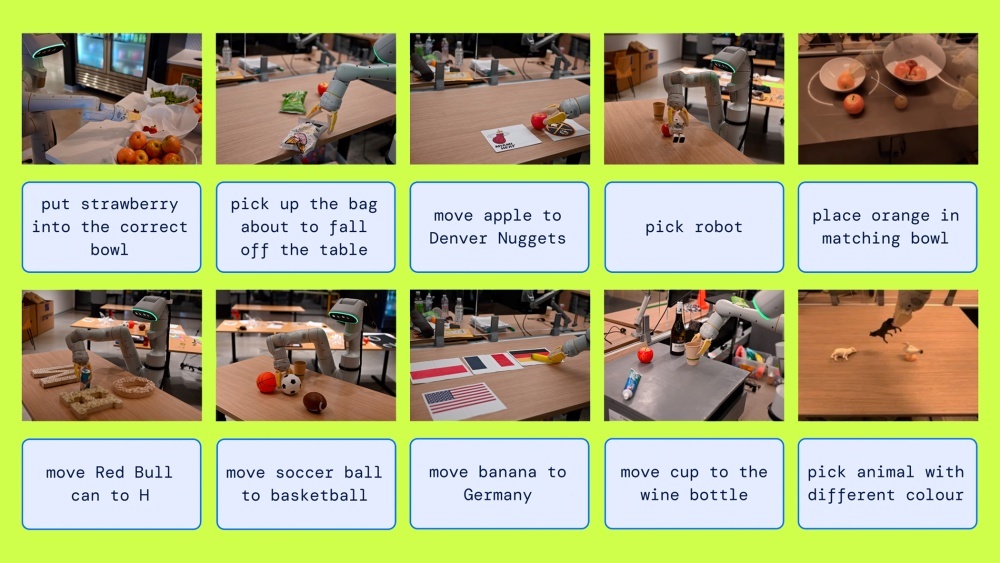

RT-2は、時間が経つにつれて新しい状況に適応し、ウェブやロボティクスデータといった複数のデータソースから学習して言語と視覚的入力の両方を理解し、これまで遭遇したことのないタスクや実行するようにトレーニングされていないタスクを実行するように設計されている。

従来のロボットの場合、球を拾うようにトレーニングすると、球は拾えるが立方体の拾い上げには苦戦する。RT-2には、球を拾うようにトレーニングされたロボットが、これまで見たことのない立方体やその他の形状の玩具を拾うために、自らの能力の限界を調整する方法を見出すことができるような、柔軟なアプローチが採用されている。

従来のロボットは、物体を物理的に認識してそれを拾い上げる方法を学習するために、数十億ものデータポイントを使った時間のかかる実世界のトレーニングが必要であるのに対し、RT-2は、大量のデータでトレーニングされており、その知識を行動に転換して、これまで経験したことのないタスクを実行できる。

「情報を行動に転換するRT-2の能力は、新しい状況や環境に、より迅速に適応するロボットが期待できることを示している」と、Google DeepMindのロボティクス責任者を務めるVincent Vanhoucke氏は述べた。「6000を超えるロボット試行実験でRT-2モデルをテストしたところ、RT-2が、トレーニングデータに含まれるタスクまたは『既知』のタスクに対して、当社の前モデルである『RT-1』と同等に機能することが分かった。その上で、初見の新しいシナリオに対する性能はほぼ2倍となっており、RT-1が32%であるのに対して62%だった」(同氏)

DeepMindチームは、2つの既存モデルである「Pathways Language and Image Model」(PaLI-X)と「Pathways Language Model Embodied(PaLM-E)を、RT-2のトレーニング用に改変した。PaLI-Xは、RT-2による視覚データの処理を支援し、膨大な量の画像と視覚的情報に加えて、その他のオンラインの対応する説明とラベルでトレーニングされている。PaLI-XによってRT-2は、異なる物体を認識し、その周辺シーンを理解してコンテキストを把握し、視覚データを意味のある記述に関連付けることができる。

PaLM-Eは、RT-2による言語解釈を支援し、RT-2が指示を簡単に理解して、その指示を周辺にあるものや現在行っている動作と関連付けられるようにする。

DeepMindチームは、これら2つのモデルをRT-2のバックボーンとして動作するように改変する中で、この新しいVLAモデルを構築し、ロボットが言語や視覚データを理解して、それに基づいて必要となる適切な動作を生成できるようにした。

RT-2自体はロボットではなく、ロボットをこれまで以上に効率的に制御できるモデルだ。RT-2対応のロボットは、視覚データや言語データを使用して、さまざまな複雑さのタスクを実行できる。例えば、文書のラベルを読み取って並べ替え、正しい場所に配置することで、ファイルをアルファベット順に整理できる。

複雑なタスクにも対応できる。例えば、「この荷物を郵送したいが、切手がない」と言えば、RT-2はまず何をすべきかを特定し、切手を売っている近所の郵便局や商店を探し、荷物を取り、郵送を手配できる。

「RT-2は、AIの進歩がロボット工学に急速に組み込まれていることを示すだけでなく、より汎用的なロボットに向けた大きな可能性を示している」とVanhoucke氏は語った。

その「可能性」が、「ターミネーター」よりも「ジェットソンズ」の筋書きに近いものであることを祈ろう。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する