毎年世界で70万人以上が自殺で亡くなっている。世界保健機関(WHO)によると、自殺は2019年における15歳~29歳の死因の第4位だ。

SNSで自殺や自傷行為に関するコンテンツを見ることは、メンタルヘルスへの悪影響につながる。New Media & Society Journalに2019年に掲載された研究論文によると、Instagramで自傷行為のコンテンツを見た人は「自傷行為や自殺に関連する結果をともなうことが多い」という。米国在住の18歳~29歳を対象としたこの研究論文はこれについて、コンテンツを見たこと自体が原因か、あるいはもともと高いリスクを抱えているため、自傷行為のコンテンツを見る可能性が高いことが原因である可能性があるとしている。

「いずれにしても、調査結果はInstagramの自傷行為のコンテンツが懸念されるべきであることを示している」と論文には記されている。

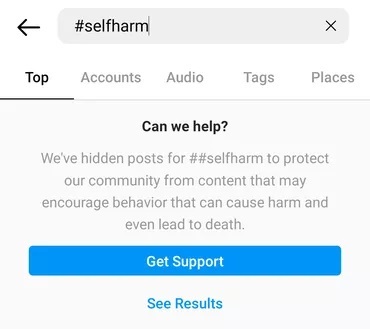

Instagramは、「#selfharm」(#自傷行為)というハッシュタグで検索しても、関連する投稿をすぐ表示せずに、検索したユーザーを支援リソースに誘導している。自傷行為の画像は「#suicide」(#自殺)で検索しても警告付きで表示される。しかし、ユーザーは警告を無視して「投稿を見る」をクリックすれば画像を表示できる。警告は「あなたが探している単語が含まれる投稿は、危害を及ぼしたり死を導いたりする可能性のある行動を助長する傾向があります」というものだ。

自殺コンテンツの検索結果の中には、メンタルヘルスサポートリソースや自殺を思いとどまらせようとするコンテンツもある。Instagramのルールに違反し、自殺を奨励しているように見えるコンテンツもある。Instagramは2019年、ミームやイラストを含む、架空の自傷行為や自殺コンテンツを禁止すると発表した。

だが、#suisideで検索したところ、こうしたタイプのコンテンツが結果に表示された。suicidal_obsessionsというアカウントは、Instagramに削除される2週間前、自傷行為や自殺の方法を描いた170点以上のイラストを投稿していた。Instagramはこのアカウントのライブストリーミングを禁じていたが、違反が続いたため、アカウントを完全に削除したという。

米CNETが見つけたこれらのコンテンツは、オンラインに存在する自殺や自傷行為のコンテンツのごく一部にすぎない。Facebookは4月から6月にかけて、Facebook上の1680万件の自殺と自傷行為のコンテンツとInstagramの300万件のコンテンツに対処したという。Facebookの報告によると、問題のコンテンツのほとんどはプラットフォームがフラグを付けたもので、違反するコンテンツがユーザーの目に触れることは「まれ」だったという。

ソーシャルメディア企業と協力し、自殺防止リソースを提供している非営利団体Samaritansは、オンラインで自殺について安全に話し合う方法のヒントを紹介している。例えば、投稿の冒頭に警告を明示することや、自殺という行為が犯罪のように聞こえる「committed suicide」(自殺を犯した)という表現を使わないこと、自殺の方法に関する投稿は避けること、頻繁に自殺について投稿しないこと、などだ。

テクノロジー企業はまた、ユーザーが報告するより前に自傷行為コンテンツを特定するために人工知能(AI)を活用している。だが、すべてのプラットフォームが自傷行為や自殺のコンテンツを検索結果から排除しているわけではない。

Twitterは自傷行為あるいは自殺コンテンツの推奨を禁じているが、自傷行為の画像は「センシティブなメディア」という警告ラベル付きであれば許可している。ユーザーはこのラベルを確認した上で画像を表示できる(警告ラベルは投稿するユーザーが設定するよう求められているが、報告があればTwitterが追加する場合もある)。他のSNSと異なり、Twitterは自傷行為コンテンツの検索結果をブロックしていない。検索結果のトップに危機管理ホットラインの電話番号が表示される。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する