自動運転車が人の介入を一切受けることなく、A地点からB地点まで人を輸送できる日が来るとすれば、車両のデザインや乗り心地はどのようなものになるだろうか。

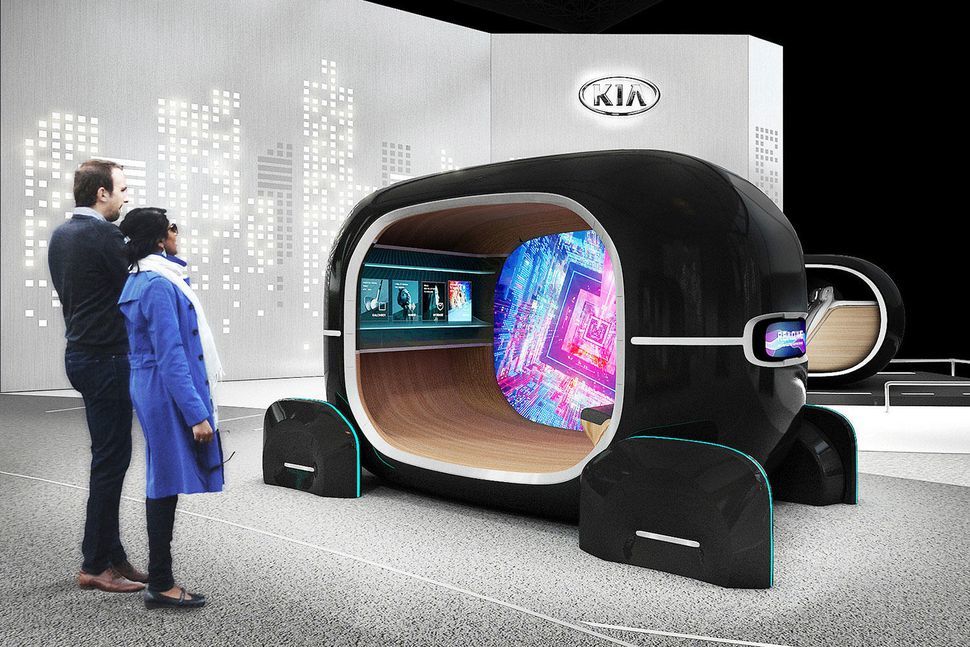

起亜自動車は、MIT Media LabのAffective Computingグループと共同開発したコンセプトを、1月に開催される家電見本市「CES」で披露すると発表した。「Real-time Emotion Adaptive Driving(R.E.A.D.)」というシステムが、搭乗者の気分や感情に合わせて自律型ポッドの環境を調整するようだ。

このポッドのようなコンセプトがいかにして搭乗者の気分に作用するのかという点については、現在詳細がほとんど明らかになっていない。起亜自動車によると、このシステムは人工知能(AI)をベースとする「生体信号認識技術」を利用し、搭乗者の感情を分析するという。さらに、「車内での人の感覚に関連する条件」を調整し、「より楽しそうな移動体験」を作るという。R.E.A.D.システムが、ムード照明やアンビエントミュージック、また香りなどを使って、搭乗者に癒しとリラックスをもたらすことは容易に想像できる。

起亜自動車の研究開発を統括するAlbert Biermann氏は声明で、「R.E.A.D.は、口にはされない『情動的な感情』を介して運転者と車両が絶えず通信できるようにすることで、人の感覚に基づいて最適化された空間をリアルタイムに運転者に提供する」と述べている。

起亜自動車は、詳細はCESで発表するとしている。このコンセプトのようなポッド型の自動運転車が実現されるまでには時間がかかるかもしれない。Audiも、未来の自動運転車のための「新たな運転中のエンターテインメントのフォーマット」をCESで披露する計画だ。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する