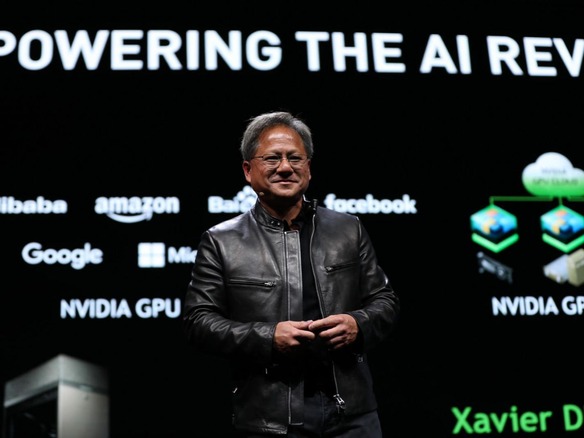

動画やグラフィックス製品のメーカーから人工知能(AI)関連製品の大手企業に転じたNVIDIAは、ドイツのミュンヘンで現地時間10月10日に開催された「GPU Technology Conference」の基調講演で、AIに関してまた新たな一歩を踏み出した。

ただし今回、NVIDIAが発表したのは、新しいGPUでも、ディープラーニングに使用する新たな独自のソフトウェア開発キット(SDK)でもない。今回発表したのは、GPUを利用した高速の分析や機械学習(ML)のための、オープンソースのGPUアクセラレーションプラットフォームだ。

一連のライブラリを提供するこの新しいプラットフォーム「RAPIDS」は、「scikit-learn」や「Pandas」にあるようなPythonインターフェースを擁する。ただしRAPIDSでは、1つまたは複数のGPU全体のアクセラレーションに、NVIDIAのCUDAプラットフォームを活用している。

NVIDIAの最高経営責任者(CEO)を務めるJensen Huang氏は9日、テクノロジ分野の記者向けの電話会見で、この技術の概要を説明した。それによると、訓練の過程にRAPIDSを導入することにより、CPUのみの実装と比べて50倍の高速化を実現したという(この高速化は、NVIDIAの「DGX-2」システム上でMLアルゴリズム「XGBoost」を使用したシナリオで計測されたとのことだが、CPUのハードウェア構成については詳細は明かされなかった)。

RAPIDSは、インメモリ列指向データ技術の「Apache Arrow」を組み込んでいるようで、「Apache Spark」上で動作するよう設計されている。Apache Sparkへの対応を念頭に、NVIDIAはDatabricksの支持を得た。DatabricksはRAPIDSを独自の分析およびAIプラットフォームに組み込む予定だ。

とはいえRAPIDSプラットフォームを支持するビッグネームはDatabricksだけではない。Pythonのディストリビューションを提供するAnacondaのほか、IBM、Hewlett Packard Enterprise(HPE)、Oracleなどのテクノロジ大手も参加している。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

CES2024で示した未来

CES2024で示した未来

ものづくりの革新と社会課題の解決

ニコンが描く「人と機械が共創する社会」

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「当たり前の作業を見直す」ことでパレット管理を効率化--TOTOとユーピーアールが物流2024年問題に挑む

「当たり前の作業を見直す」ことでパレット管理を効率化--TOTOとユーピーアールが物流2024年問題に挑む

ハウスコム田村社長に聞く--「ひと昔前よりはいい」ではだめ、風通しの良い職場が顧客満足度を高める

ハウスコム田村社長に聞く--「ひと昔前よりはいい」ではだめ、風通しの良い職場が顧客満足度を高める

「Twitch」ダン・クランシーCEOに聞く--演劇専攻やGoogle在籍で得たもの、VTuberの存在感や日本市場の展望

「Twitch」ダン・クランシーCEOに聞く--演劇専攻やGoogle在籍で得たもの、VTuberの存在感や日本市場の展望

Meta詐欺広告「激減を確認」「やればできることの証左」--対策に動いた自民党、小林議員に聞く

Meta詐欺広告「激減を確認」「やればできることの証左」--対策に動いた自民党、小林議員に聞く

3年目を迎えた三菱地所のCVC「BRICKS FUND TOKYO」--2%を見つけ出す投資戦略とは

3年目を迎えた三菱地所のCVC「BRICKS FUND TOKYO」--2%を見つけ出す投資戦略とは

OKIが両立する生成AIの積極活用とセキュリティリスク対策

OKIが両立する生成AIの積極活用とセキュリティリスク対策

中堅・中小企業のDXを阻む予算よりも深刻な課題とは--経産省が支援へ

中堅・中小企業のDXを阻む予算よりも深刻な課題とは--経産省が支援へ

天王洲をスタートアップが集う実験島に--寺田倉庫がビジネスイノベーションプロジェクトを行う狙い

天王洲をスタートアップが集う実験島に--寺田倉庫がビジネスイノベーションプロジェクトを行う狙い

Uber Eatsで処方薬を配達、安全性は大丈夫?--Uber Eatsとメドレーに聞く

Uber Eatsで処方薬を配達、安全性は大丈夫?--Uber Eatsとメドレーに聞く