筆者は「Ray-Ban Metaスマートグラス」の新機能である「ライブAI」をオンにして、マンハッタンで朝の散歩に出かけた。それは奇妙な体験だった。レンズの脇にある白いLEDが点灯して、自分の見ているものがメガネに入力され続けていることを示している。筆者はとまどいながら、AIに色々な質問をしてみた。鳩について。工事作業員について。近くにある車を知っているか。通りの向こうにあるトラックの持ち主は誰なのか。返ってきた答えはさまざまで、時にはまったく答えがないこともあった。しかも筆者の接続は、Bluetoothの調子が悪くて街中で切れてしまった。

Ray-Ban Metaスマートグラスに導入された最新の機能である「ライブAI」は、カメラからの情報を処理して常に周囲の状況を把握する。この記事ではこの新機能をテストしてみた。

Ray-Ban Metaスマートグラスに導入された最新の機能である「ライブAI」は、カメラからの情報を処理して常に周囲の状況を把握する。この記事ではこの新機能をテストしてみた。常に周囲を認識しているAIコンパニオンを伴っての最初の体験は、過去1年間にさまざまなデバイスを試してきた筆者にとっても違和感のあるSFチックなものだった。筆者が最近体験した、常時周囲を認識する「Gemini」を搭載したGoogle版スマートグラスのデモと同じように、Ray-Ban Metaスマートグラス(こちらはかなり前から米国などで一般販売されている)も、常時文脈を理解しているアシスタントのようなものを目指した新たな一歩を踏み出した。AI業界では最近、この種のものをエージェントと呼んでいる。新機能であるライブAIとライブ翻訳は、一度オンにすればそのまま常時動作し続ける。またこれらの機能は、AIにもユーザーが見ているのと同じものが見えている前提で作られている。そして、ユーザーが知らないことを教えてくれることもあるというわけだ。

これらの機能は、2025年に発売される、Metaのまったく新しいスマートグラスで可能になることの予告編のようにも見える。Mark Zuckerberg氏が2024年12月、The Wall Street JournalのJoanna Stern氏が書いた記事に反応して投稿したThreadsの発言でほのめかされたこの新製品は、ディスプレイを持ち、ジェスチャーで操作するためのリストバンドまで備えている可能性があるという。

今のところ、筆者がとりあえず試したライブAIの印象は、これは常時作動させておくタイプのユーザーへの干渉が強めな未来のAIを感じさせるどこか奇妙な体験であり、「助けてくれるもの」というよりは道連れの話し相手に近い、というものだった。一方、ライブ翻訳機能は、多少の遅延があるものの、うまく噛み合う場面では驚くほど役に立った。

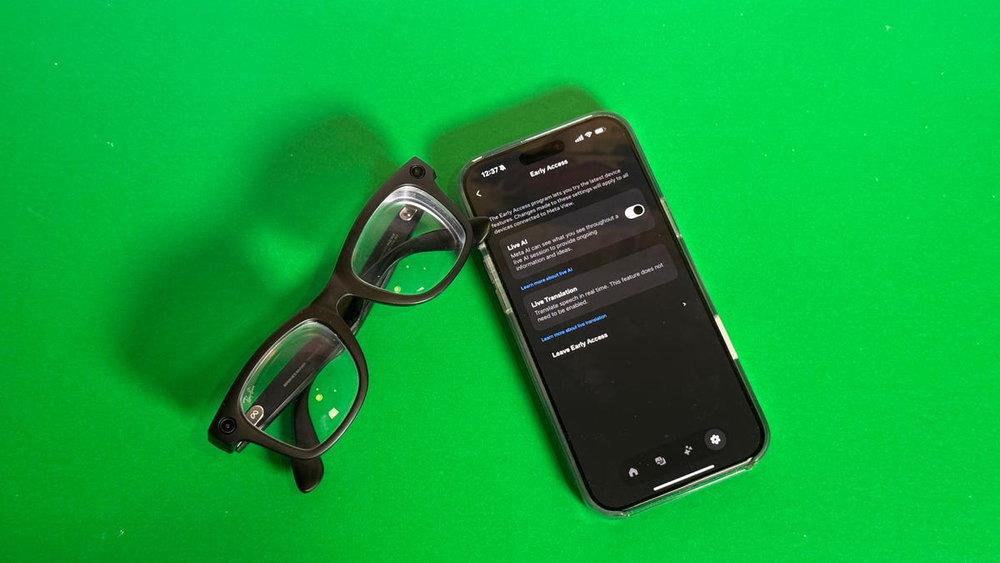

ライブAIは、アーリーアクセスとして提供された機能の1つであり、ユーザーが好きなタイミングでオン・オフできる。

ライブAIは、アーリーアクセスとして提供された機能の1つであり、ユーザーが好きなタイミングでオン・オフできる。ライブAIをオンにすると、カメラ映像の記録が始まる。この動画が保存されることはなく、後で視聴できるわけではないが、スマートフォン経由でMetaのAIによって処理され、その結果がスマートグラスに中継される。この機能を使用している間は常にLEDが点灯し、周囲の人に録画中であることが分かるようになっているが、筆者の経験では、多くの人はそれに気付かないか、気付いていても気にしない。AIはユーザーのすべての発言を自分に対するものだと認識するため、ライブAIを使用したまま他の人と会話するのは難しい。オフィスでこれを使っている筆者は、独り言を言い続けているおかしな人物か、誰かに話しかけているように見えるにもかかわらず、それに答えようとした人は話しかけられたわけではないと気付くという、迷惑な人物に見えたはずだ。ただし、ライブAIはメガネの側面をタップすれば一時停止することができる。

「Stop Live AI」と命令してもライブAIを停止させられるのだが、それを聞いたMetaのAIは、そのAIがライブAIかどうかを尋ねていると勘違いしてしまうことが度々あり、AIを停止するのに何度も命令を叫ばなければならなかった。

Ray-Ban Metaスマートグラスを着けていても、周囲の人は大抵の場合スマートデバイスを身に付けていることに気付かないし、筆者がAIと話しているとも思わない。

Ray-Ban Metaスマートグラスを着けていても、周囲の人は大抵の場合スマートデバイスを身に付けていることに気付かないし、筆者がAIと話しているとも思わない。ライブAIの問題は、何に使えるのかがよく分からないことだ。オフィスの中を歩き回りながら家具の配置についてアドバイスがないか尋ねてみたが、返ってきた答えは「この部屋のデザインは優れており、機能的で、明らかに変更すべき点はありません」というものだった。筆者がノートPCで書いていた記事について意見を聞いてみると、「このテキストにはまとまりがあり、構成もよくできていて、不要だと感じられる部分はありません」と答えた。筆者は建設的なフィードバックを得ようと何度も質問をしたが、返ってきたのは当たり障りのない回答ばかりだった。ただし、いくつかのポイントになる表現を指摘し、記事の論点を要約することはしてくれた。

外を歩くと、AIが歩いている道の名前を教えてくれたが、その情報は間違っていた。勘違いを指摘しても、AIはただそれを受け入れただけだった。AIは筆者が目を向けていたChase銀行について知っており、営業時間を教えてくれたし、パブリックシアター(マンハッタンにある歴史のある劇場)の入り口に立ったときには、「Joe's Pub」(パブリックシアターの中にある有名なパフォーマンスホール)について教えてくれたが、その日の演目を答えることはできなかった。またライブAIは普通の鳩を認識できたが、通りの角にあった自動車(Lincoln)をMercedesだと誤認識したし、理由は分からないが、通りの先にあった(Metaによれば今はなくなってしまった)バーを勧めてきたりもした。

現在のライブAIはアーリーアクセスのベータ版といった風情だが、この記事では、それで将来何ができるようになるかについても考察しておくべきだろう。初期のベータ版のような雰囲気と、使い道が今ひとつ分からないことから、ライブAIがナンセンスなものに見える人もいるだろうし、予想外に深遠なものだと感じる人もいるかもしれない。いずれにせよ、ライブAIを使っているとバッテリーはすぐに減ってしまい、通常なら数時間は使えるにもかかわらず、30分しか持たない。

ライブ翻訳を利用するには、使用する言語の言語パックをダウンロードする必要がある。

ライブ翻訳を利用するには、使用する言語の言語パックをダウンロードする必要がある。ライブ翻訳もライブAIと同じように、ユーザーの指示があって初めて作動する。ただし、使うには自分が翻訳したい言語の言語パック(例えば「スペイン語から英語」など)をあらかじめダウンロードしておく必要がある。残念ながら、現時点ではスペイン語、フランス語、イタリア語、英語にしか対応していない。

筆者は、米CNETのニューヨークオフィスの付近にある騒々しい通りであるアスター・プレイスで、同僚であるDanni Santana記者を相手にライブ翻訳を使って会話してみた。Santana氏はドミニカ方言のスペイン語で話し、こちらは英語を使った。相手の発言の翻訳が耳に届くまでには数秒かかるため、翻訳が会話と被ってしまうという難点があったが、会話の内容を理解するだけの情報を汲み取ることはできた。翻訳は完璧ではなく、AIは一部のフレーズやイディオムを理解できないようだった。また、遅延のために翻訳がいつ終わるかや、続きがあるかどうかを把握するのが難しく、相手がテーブルの向こうで辛抱強く返答を待っている中、返事をするタイミングを選ぶのに苦労した。

スマートフォン用アプリの「Meta View」で会話の書き起こしをリアルタイムで表示することが可能で、スマートグラス経由でそれを見て、相手の発言内容を確認することもできた。

Ray-Ban Metaスマートグラスのライブ翻訳は、ライブAIよりも便利さを実感しやすいが、これはライブAIを何に使えばいいかが分かりにくいからでもある。ひょっとすると、料理をしたり、IKEAの家具を組み立てたり、ボードゲームを遊んだりするときに使うといいのかもしれない。Metaはもっと使い道を分かりやすくすべきだろう。また、ヘッドアップディスプレイがないため、ライブAIを利用する際に、カメラには今何が映っているのかと悩むことがあった。

もちろん、スマートフォンで「Google翻訳」を使っても同じようなことはできる。Metaがスマートグラスでやっていることは、イヤホンを使って翻訳する場合と似たような仕組みで実現している。Metaのスマートグラスには書き文字を扱えるという優位性があるが、これはライブ翻訳とはまた別の機能だ。

MetaのプロトタイプARグラスである「Orion」は、ニューラル入力用のリストバンドと、3Dヘッドアップディスプレイを持っている。これらの技術は今後、Ray-Ban Metaスマートグラスにも導入されるかもしれない。

MetaのプロトタイプARグラスである「Orion」は、ニューラル入力用のリストバンドと、3Dヘッドアップディスプレイを持っている。これらの技術は今後、Ray-Ban Metaスマートグラスにも導入されるかもしれない。発売から1年になるRay-Ban Metaスマートグラスには、これまでに目立ったAI機能がいくつか追加されており、そのどれもが、スマートグラスの役割を大きく変える可能性があるものだった。その最新の例であるライブAI機能は、ハードウェアの限界に挑むものであり、バッテリーの持続時間が代償になっている。また筆者は、AIに何が見えているかを知る方法か、自分の手を使って、質問の対象を指定する方法が欲しいと感じた。

将来のスマートグラスは、ヘッドアップディスプレイとジェスチャー操作の両面で進化する可能性がある。Metaの最高技術責任者(CTO)であるAndrew Bosworth氏は、2024年末に筆者が行ったインタビューの中で、これらの技術が次のステップであることを認めたが、その実現時期については明らかにしなかった。筆者は2024年に、3Dディスプレイと手首に装着するジェスチャー検出デバイスを備え、指のタップやピンチを認識できるMetaの未来のスマートグラスである「Orion」のデモを体験させてもらったが、この製品の実用化までにはまだ何年もかかる。しかし、手首に装着するMetaのニューラル入力リストバンドはもっと早く実用化されるかもしれず、カメラを搭載したスマートグラスに手の動きを認識させる手段として採用されることも考えられる。また同社は、もっと大型で没入感の高いARスマートグラスに取り組む前に、スマートグラスに情報を表示する小さめのヘッドアップディスプレイを導入するかもしれない。Bosworth氏は、最近のブログ記事で次世代のARグラスに言及しているが、その話の一部は、2025年の次世代スマートグラスでも実現可能なのではないだろうか。

Bosworth氏は、未来のMetaのスマートグラスについて、「ジェスチャー操作を実現するには、下向きのカメラと、おそらく多少の照明が必要になる」と述べ、「現在のRay-Ban Metaスマートグラスでもジェスチャー操作は可能だし、ライブAIでもそれを使ってみせたが、ジェスチャーはカメラの視界の中で行う必要があった」としている。一方で同氏は、早い時期にスマートグラスにEMG(筋電図)リストバンドを導入する可能性があることを認め、「充電が必要なデバイスを追加することになるため、コストと重量が増えるが、非常に便利になる」とも述べている。ただしBosworth氏は、ディスプレイがなければEMGリストバンドには意味がないと考えているという。今のRay-Ban Metaスマートグラスにはディスプレイはない。Ray-Ban Metaスマートグラスに何らかのヘッドアップディスプレイが追加される時が来たら、入力用のEMGリストバンドも一緒に導入されるかもしれない。同様の試みは他の製品にも見られる。

それに加えて、バッテリー持続時間の問題もある。どうすればスマートグラスで数時間以上AIを使い続けることができ、それによって次世代スマートグラスの値段がどれだけ上がるのかも課題になってくるだろう。

また、MetaのAIは近いうちにフィットネスなどの分野にも展開されるかもしれず、それが別のバージョンのMeta AIが存在しているVRとの橋渡しになるかもしれない。Bosworth氏は「AIはすでに現実世界の歩数を記録してアドバイスを提供するのに使われている。1年後には、そのAIがVRを使ったワークアウトでも使われていなければおかしい」と述べている。

ライブAIが進化を続ければ、ジェスチャー操作を実現する方法が必ず必要になってくる。Bosworth氏は、何かを指さす手段は、将来的にAIをトレーニングして改良するために重要だと考えている。「AIが良くなるにつれて、こうしたシンプルで直感的なジェスチャー操作の必要性は非常に大きくなる」と同氏は言う。

今のRay-Ban Metaスマートグラスでは何かを指さすことができず、そのためにライブAIを使うのが難しく感じることがある。さらなる飛躍には、新しいハードウェアや、ジェスチャー操作やディスプレイの追加が必要なのかもしれない。

「Meta Quest 3」(価格をAmazonでチェック)

この記事は海外Ziff Davis発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する