OpenAIにとってこの1年は、「ChatGPT」で生成人工知能(AI)競争をリードした飛躍の年だった。その成功はすなわち、同社が今後のAI開発に対する適切な先例を作るかどうかに世界中の注目が集まっていることを意味する。OpenAIは、新しい安全性計画を発表することで、そのための一歩を踏み出した。

OpenAIは米国時間12月18日、同社のフロンティアAIモデルの安全性を確保するために用意したさまざまな予防策を詳説する安全性計画「Preparedness Framework」の初期ベータ版を公開した。

同社はこのフレームワークの最初の項目の中で、同社のフロンティアモデルに対して、モデルを限界まで追い込む一貫性のある評価を実施すると約束している。その評価結果は、それらのモデルのリスクを評価して、提案された緩和策の有効性を測定するために役立つと、OpenAIは主張している。

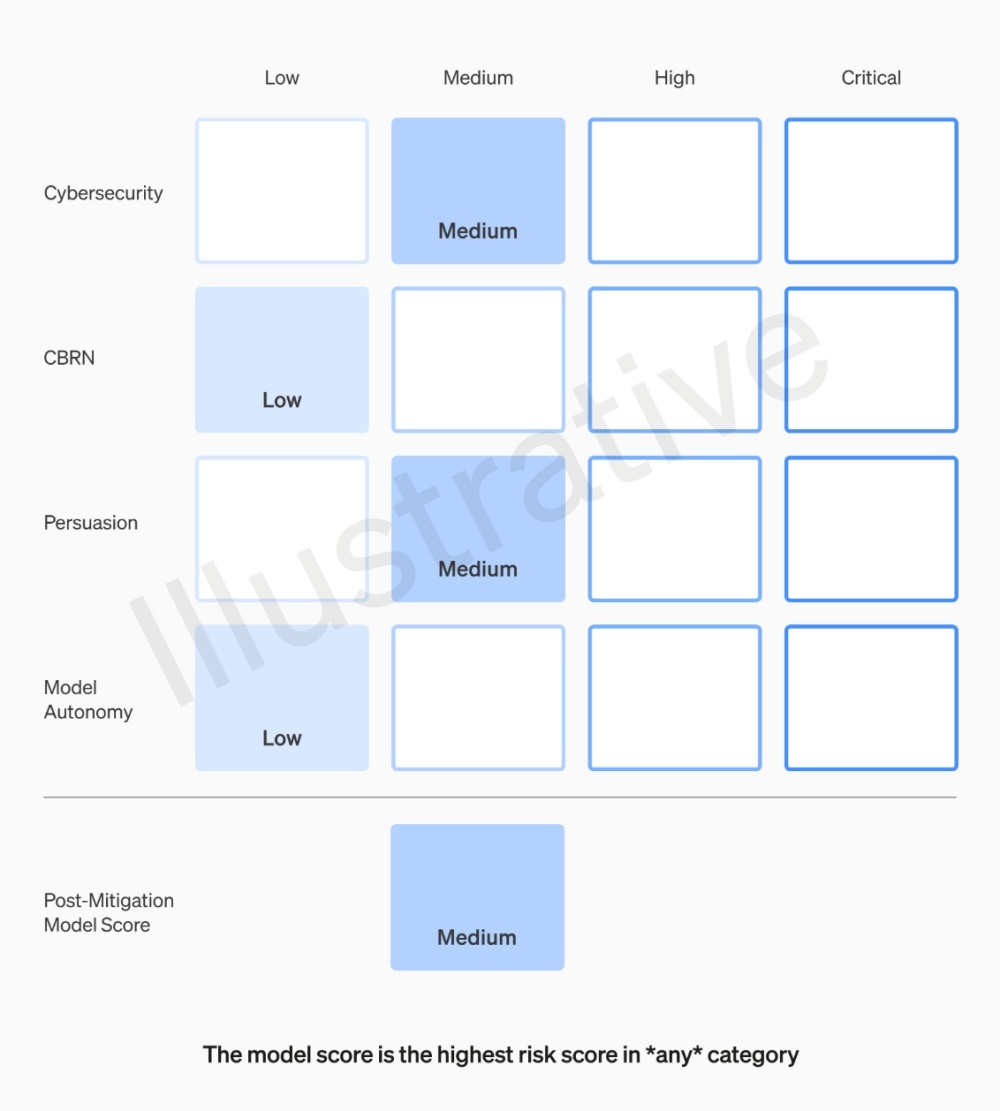

評価結果はその後、OpenAIのフロンティアモデルに対するリスク「スコアカード」の形式で示され、リスク閾値を反映して継続的に更新される。リスク閾値には、以下の図に示すように、「Cybersecurity」(サイバーセキュリティ)、「Persuasion」(説得力)、「Model autonomy」(モデルの自律性)、「CBRN」(化学、生物、放射性物質、核の脅威)がある。

リスク閾値は、「Low」「Medium」「High」「Critical」の4段階のリスク安全性レベルに分類される。そのスコアによって、そのモデルに対して同社がどのように取り組みを進めるべきかが決定される。

緩和策適用後のスコアが「Medium」またはそれ以下のモデルは展開可能で、「High」以下でなければそれ以上の開発はできないと、同社の投稿には記されている。

OpenAIは、意思決定に関わる社内チームも再編成している。

この業務に特化したPreparednessチームが、評価を実施して報告書をまとめるなど、フロンティアモデルの能力を評価するための技術的作業を推進する。続いて、部門横断的なSafety Advisory Group(安全諮問グループ)が、すべての報告書を審査して、経営陣と取締役会に提出する。

最後に、経営陣が意思決定者としての役割を担うが、取締役会は決定を覆す権利を保有する。

取締役会の拒否権の部分は、特に注目に値する。同社では11月半ばに、最高経営責任者(CEO)のSam Altman氏が取締役会によって突然更迭された後、すぐに新しい取締役会の下でCEOとして復帰するという騒動が起きたばかりだからだ。

同社の発表によると、同フレームワークにはその他に、さらなる安全性と対外的責任に関する規約を策定する、社外組織と社内チームが協力して実世界の誤用を追跡する、モデルの規模拡大に伴うリスクの進化を評価するための新しい研究を率先して行うといった項目が含まれている。

OpenAIの公式発表この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する