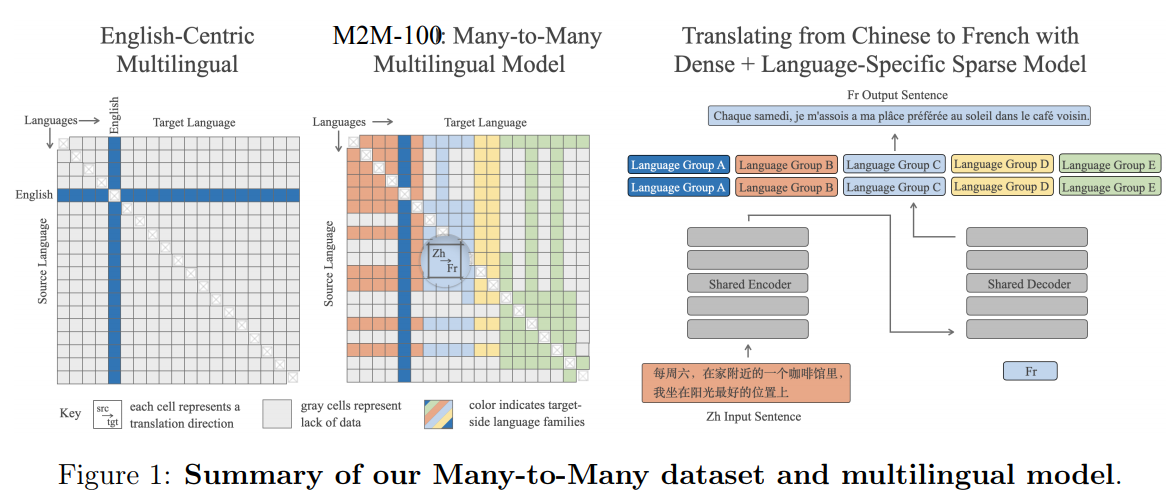

Facebookは米国時間10月19日、100言語中の任意の2言語を英語を介することなく翻訳できる多言語機械翻訳(MMT)モデル「M2M-100」を発表し、オープンソースで公開した。

M2M-100は、翻訳時に中間言語を介する必要がないため、より正確な翻訳が可能になると考えられる。一般的な翻訳モデルでは、英語が中間言語に据えられてきている。このため、例えば中国語をフランス語に翻訳する場合、いったん英語に翻訳する必要がある。

Facebookは、2言語間での直接翻訳によってより多くの意味を捉えられるとともに、英語を介するシステムに比べた場合、機械翻訳の自動評価指標であるBLEUスコアが10ポイント高くなるとしている。

M2M-100は、2200に及ぶ言語の組み合わせによって訓練されている。Facebookは社外の研究者らに向けて、M2M-100のモデルと訓練、評価の設定を公開する予定だ。

Facebookはニュースフィード上で毎日200億件の翻訳を処理しているという。同社によると、従来の機械翻訳では各言語に対応する人工知能(AI)モデルが必要となるが、このようなアプローチはFacebookにはあまり有効ではない。

MMTモデルを訓練するために同社は、英語を介さずに翻訳された、複数の言語による良質なペアを選び出す必要があった。なお世の中には、こういった言語間の直接翻訳よりも、英語への翻訳の方が数多く存在している。Facebookは最終的に100種類の言語をまたがる75億もの文章のペアからなるMMTデータセットを構築した。同社はそこから高品質でデータ量の多いペアを絞り込むとともに、統計的に見てまれにしか登場しない言語のペアを除外したという。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

CNET Japan Live 2025開催レポート

CNET Japan Live 2025開催レポート

イノベーションの「種」から社会実装へ--

社会課題の解決に挑む各社の挑戦

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

無限に広がる可能性

無限に広がる可能性

すべての業務を革新する

NPUを搭載したレノボAIパソコンの実力

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する