Microsoftは最新の研究プロジェクト「LightSpace」で、「サーフェスコンピューティング」の取り組みを「空間コンピューティング」に拡大しようとしている。

LightSpaceプロジェクトには、テーブル型コンピュータ「Microsoft Surface」の主要開発者を務めたMicrosoftの研究者、Andy Wilson氏も参加している。Wilson氏らは米国時間10月3日から6日まで米ニューヨークで開催されるACM Symposium on User Interface Software and Technologyで、この新プロジェクトを披露することになっている(社内向けには、2010年3月に本社でMicrosoft Researchが開催した「TechFest」でお披露目済みだ)。

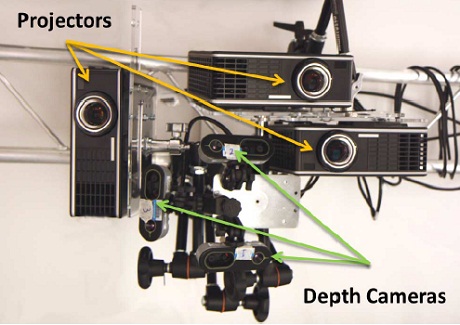

LightSpaceは複数台のデプスカメラとプロジェクタを利用し、ユーザーがタッチ可能な複数のサーフェス領域間でオブジェクトを移動できるようにするものだ。デプスカメラにより、あたかもユーザーが投影されたオブジェクトを手にしているように見え、そのオブジェクトを壁に「ドロップ」するという流れだ。壁では、Microsoft Surfaceテーブルで使われているものに似たマルチタッチジェスチャーを使って操作できる。

LightSpaceとMicrosoftのゲームセンサ技術「Kinect」の間には関連性があり、Microsoftの研究者らは、Kinectによりデプスカメラが一般的になり安価になると想定している。先に公開されたLightSpaceに関するホワイトペーパーでは、以下のように記している。

デプスカメラ(PrimeSense1、3DV、Canestaなどが提供している)は各ピクセルの位置ですぐ近くにある物理的表面までの範囲を直接感知できる。リアルタイムの表面ジオメトリ3次元モデリングを安価に実現するという点でユニークな技術で、これまで難しいといわれてきたコンピュータの視覚問題の一部を緩和するものだ。たとえば、デプスカメラを使ってテレビ会議アプリケーションで人工的な背景を容易に作成できる。MicrosoftのKinect端末は、PrimeSense技術を土台としており、モーション主導型ゲーム向けにプレイヤーの骨格モデルを計算できる。デプスカメラは現在は一般的ではないが、Kinectのリリースにより、価格が下がり、普及が進むと思われる。

LightSpaceは、「the room is the computer(空間がコンピュータ)」という概念(「the network is the computer(ネットワークがコンピュータ)」はOracleに買収されてしまった)を進める取り組みであり、物質の表面部分がインタラクティブな画面になるという将来を思わせるものでもある。これには、ユーザーの体も含まれる。

Microsoftは以前より、Surface技術を拡大する方法を探っている。Microsoftの研究者は数年前、「Microsoft Sphere」を披露し、2009年にはSurfaceのスピンオフプロジェクトとして、「SecondLight」を披露した。SecondLightはリアプロジェクションを用いた技術で、画面の向こうにあるものへ情報を投影可能になっている(話は逸れるが、「Bing Maps on Silverlight」プロジェクトの開発コードは「FlightLight」だ)。

(LightSpaceのウェブサイトは、Microsoft学生パートナーのPradeep氏に教えてもらった。)

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ひとごとではない生成AIの衝撃

ひとごとではない生成AIの衝撃

Copilot + PCならではのAI機能にくわえ

HP独自のAI機能がPCに変革をもたらす

心と体をたった1分で見える化

心と体をたった1分で見える化

働くあなたの心身コンディションを見守る

最新スマートウオッチが整える日常へ

プライバシーを守って空間を変える

プライバシーを守って空間を変える

ドコモビジネス×海外発スタートアップ

共創で生まれた“使える”人流解析とは

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

メルカリが「2四半期連続のMAU減少」を恐れない理由--日本事業責任者が語る【インタビュー】

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

なぜPayPayは他のスマホ決済を圧倒できたのか--「やり方はADSLの時と同じ」とは

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

AIが通訳するから英語学習は今後「オワコン」?--スピークバディCEOの見方は

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

パラマウントベッド、100人の若手が浮き彫りにした課題からCVCが誕生

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

野村不動産グループが浜松町に本社を「移転する前」に実施した「トライアルオフィス」とは

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「ChatGPT Search」の衝撃--Chromeの検索窓がデフォルトで「ChatGPT」に

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

「S.RIDE」が目指す「タクシーが捕まる世界」--タクシー配車のエスライド、ビジネス向け好調

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

物流の現場でデータドリブンな文化を創る--「2024年問題」に向け、大和物流が挑む効率化とは

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

「ビットコイン」に資産性はあるのか--積立サービスを始めたメルカリ、担当CEOに聞いた

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

培養肉の課題は多大なコスト--うなぎ開発のForsea Foodsに聞く商品化までの道のり

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

過去の歴史から学ぶ持続可能な事業とは--陽と人と日本郵政グループ、農業と物流の課題解決へ

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

通信品質対策にHAPS、銀行にdポイント--6月就任のNTTドコモ新社長、前田氏に聞く

「代理店でもコンサルでもない」I&COが企業の課題を解決する

「代理店でもコンサルでもない」I&COが企業の課題を解決する