「Hey Meta。これを見て。どのお茶がカフェインフリーなのか教えて」

筆者はMetaのニューヨークオフィスで、同社の「Ray-Ban」スマートグラスを着用し、4種類のティーバッグが置いてあるテーブルを見つめながら冒頭の言葉を発した。ティーバッグのカフェインのラベルはマジックペンで塗りつぶされている。カチッという小さな音が聞こえた後、Metaの人工知能(AI)の音声が、カモミールティーにはカフェインが含まれていない可能性が高いと教えてくれた。スマートグラスは、ラベルを読み取り、生成AIを使用して判断したのだ。

筆者は、米国時間12月12日からMetaの第2世代のRay-Banスマートグラスで展開される機能のデモを試していた。この機能は、Metaの最高経営責任者(CEO)のMark Zuckerberg氏が9月に同製品を発表した際に、すでに約束していたものだ。本体に搭載されたカメラにアクセスして画像を確認し、生成AIで解釈できるこのAI機能は、2024年に提供される予定だった。Metaは、筆者の予想よりもはるかに早くこうした機能の導入に動いた。ただし、この早期アクセスのモードは依然としてベータ版という印象が非常に強い。新しいアップデートの一環として、「Bing」を利用した検索機能がRay-Banスマートグラスに追加され、すでに利用できていた音声対応機能が強化されるなど、Metaのスマートグラスには、多くの新機能が急速に搭載されだしている。

筆者は、このようなデモを過去に見たことがなかったので、とても驚いた。部分的には、すでに目にしたことのあるものもあった。「Googleレンズ」などのスマートフォン上のツールはすでにカメラとAIを連携させており、「Google Glass」は10年前の時点でちょっとした翻訳ツールを備えていた。とはいえ、簡単にAIを呼び出して、自分の周囲にある物体を識別できるMetaのスマートグラスの機能は、かなり先進的な印象を与える。もっと試すことを筆者は楽しみにしている。

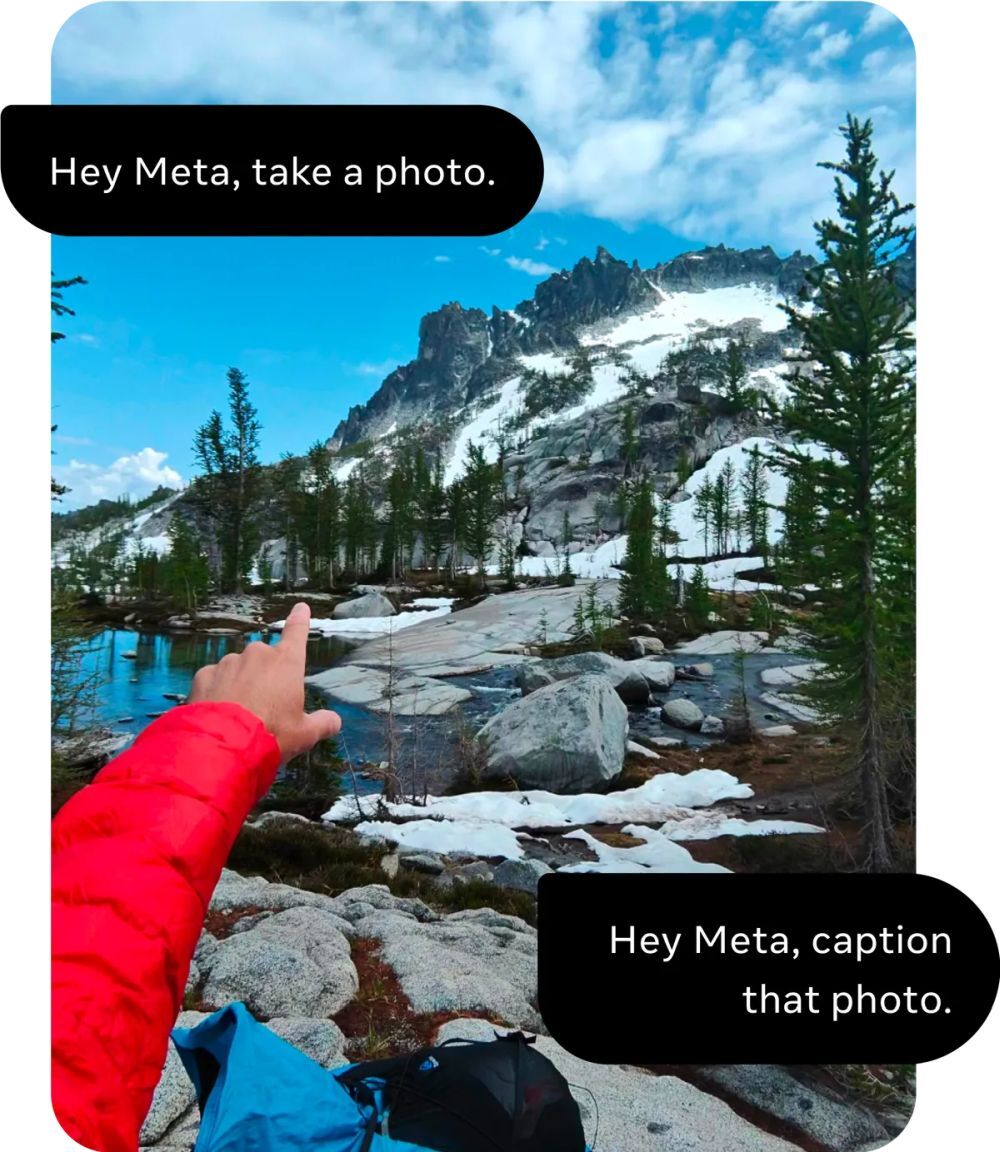

現時点では、この機能にはさまざまな制限がある。ユーザーが見ているものを認識するには、写真を撮るしかない。写真が撮られると、AIがそれを分析する。ユーザーが音声でリクエストを伝えると、シャッター音が鳴った後、数秒後に応答が返ってくる。音声プロンプトには、多くの言葉が必要だ。音声を使ってリクエストするときは、最初に「Hey Meta」と言った後、「Look and…」(見て…)と続けて、写真を撮影し、AIに頼みたいことをすぐに伝えなければならない。いくつか例を挙げておこう。「Hey Meta。見て。これらの材料を使ったレシピを教えて」「Hey Meta。見て。面白いキャプションを考えて」「Hey Meta。見て。この植物の名前は何?」

AIのすべての応答とAIが確認した写真は、スマートグラスとペアリングされているスマホ上の「Meta View」アプリに保存される。筆者はこの機能を気に入っている。後で確認できる画像/文字記録であり、記憶を呼び覚ますメモのような役割を果たすからだ。ショッピングなどでどこかを歩き回っているときに、顔に装着するメガネ型のGoogle検索のようなものとしてこの機能を使用し、AIに質問している自分の姿が目に浮かぶ。

支援技術として利用することもできるかもしれない。筆者は度の入っていないMetaのテスト用スマートグラスを着用して、自分が何を見ているのかを尋ねた。応答の詳しさや正確さはまちまちだが、前もって情報を得ることができる。筆者のメガネを見せたところ、スマートグラスはそれを認識し、青みがかったレンズが付いていると応答した(青と黒のフレームなので、かなり近い)。

ハルシネーション(幻覚)が起きることもある。筆者が目の前のボウルに入っている果物について、スマートグラスに尋ねたところ、オレンジとバナナ、ドラゴンフルーツ、リンゴ、ザクロがあるという応答が返ってきた。ザクロを除けば、正解だ(ザクロは1つもなかった)。窓の前にある大きなパンダのぬいぐるみのキャプションを作るように頼んでみてほしいと言われたので、そうしたところ、いくつかのかわいいキャプションが作成されたが、その中に、寂しくてスマートフォンを見ている人、というキャプションがあった。パンダのぬいぐるみにはそぐわないキャプションだ。

それから、スペイン語のメニューを見て、辛い料理を教えてほしいとスマートグラスに伝えた。いくつかの料理名を読み上げて、主な食材をいくつか翻訳してくれたが、その後、肉を使った料理について尋ねると、すべての応答がスペイン語で読み上げられた。

この機能には途方もない可能性があり、興味深い。おそらく、信じられないほどの利便性を提供するだろう。Metaも認めているように、この早期リリースの目的は、バグを発見して、スマートグラス上のAIの機能を進化させることだ。筆者は、「Hey Meta。見て」と言わなければならないことがあまりにも多すぎると感じた。だが、そのプロセスが変わる可能性もある。目の前の画像の分析を実行しているときに、「見て」と再度言わずに、直接フォローアップの質問をしても機能するが、うまくいかないことも間違いなくある。

MetaはこのAIを「マルチモーダルAI」と呼んでいる。カメラと音声チャットを連携させて使っているからだ。同社はより多くの感覚データを含むさまざまな種類の入力を組み合わせる未来のAIを計画しており、このスマートグラスのAIはその先駆けである。Metaの新しいRay-Banスマートグラスに搭載されたQualcommのチップセットは、AIに重点を置いており、さらに多くの機能に対応する用意が整っているように思える。Metaは今後時間をかけて、この処理をよりシームレスにしていくことも計画している。

Metaの最高技術責任者(CTO)を務めるAndrew Bosworth氏が9月に筆者に語ってくれたところによると、現状では、バッテリーの急速な消費を防ぐために、音声プロンプトを使用してスマートグラスを起動し、「見る」ことができるようにする必要があるが、最終的には、「低消費電力のセンサーを搭載して、AIを呼び出して認識させるという一連の動作を発動するイベントを検出できるようにする」予定だという。「それこそ、まさにわれわれが実現しようとしている夢だ」とBosworth氏は語った。Metaは、より高度な未来のウェアラブルの登場に先立って、複数の種類の感覚データを融合するAIツールの研究にもすでに着手している。

現時点では、このスマートグラスは、早期アクセスのベータ版であるということに注意しておこう。Metaは、早期アクセスの段階では、匿名化されたクエリーデータを使用して、AIサービスの改善に取り組んでいる。プライバシーを重視する人は不安に感じるかもしれない。ユーザーによる許可に関する詳細はまだ不明だが、完成版のAI機能がリリースされる頃(おそらく2024年)には、データ共有に関して個々で設定できるようになる可能性がある。早期アクセスもまだ誰もができるわけではないが、同社によると、徐々に利用できる人を増やしていくという。

これらはすべて、Humaneが同社のウェアラブルデバイス「AI Pin」で目指していることを連想させる。筆者はこのデバイスをまだ実際に見たことさえない。Humaneの製品が高価で、衣服に装着する必要があるのに対し、Metaのスマートグラスは299ドル(約4万2000円)で、一部の国ではすでに店頭に並んでいる。スマートウォッチや仮想現実(VR)ヘッドセット、スマートグラスがAI機能を進化させる中で、ウェアラブルテクノロジーの未来と支援技術に対する意識のレベルが大きく変化するかもしれない。

ウェアラブルAI製品の新境地がすでに始まっていることが明らかになりつつある。そして、Metaのスマートグラスは誰よりも先にそこに到達しようとしている。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

データ統合のススメ

データ統合のススメ

OMO戦略や小売DXの実現へ

顧客満足度を高めるデータ活用5つの打ち手

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス

CES2024で示した未来

CES2024で示した未来

ものづくりの革新と社会課題の解決

ニコンが描く「人と機械が共創する社会」

誰でも、かんたん3D空間作成

誰でも、かんたん3D空間作成

企業や自治体、教育機関で再び注目を集める

身近なメタバース活用を実現する