IBMの研究開発部門であるIBM Researchとカーネギーメロン大学(CMU)は、視覚障がい者が自力で歩いたりショッピングしたりできるよう支援するため、スマートフォン向けアシスタントアプリ制作用のプラットフォーム「Human-scale Localization Platform(HULOP)」を開発した。

さらに、試作したHULOPベースのiOS版ナビアプリ「NavCog」を、App Storeで無償提供する予定だという。

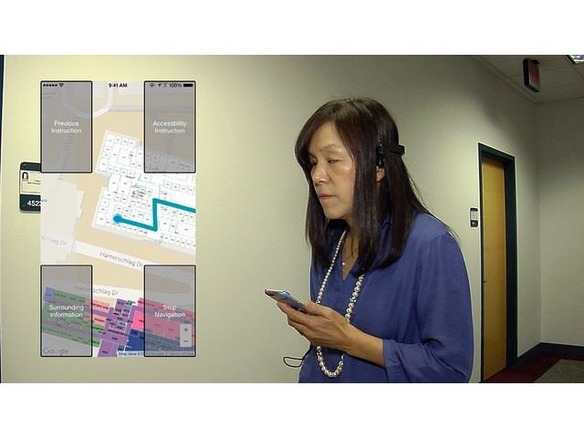

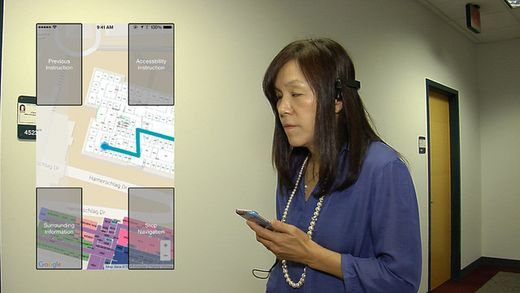

NavCogは、スマートフォンに搭載された各種センサの機能と、CMUキャンパスの各所に設置されたBluetoothビーコンからの情報を組み合わせて道案内するアプリ。

キャンパス内であれば、屋内でも屋外でもナビが可能。ドアの位置や進む方向などの案内情報は、イヤホンを通じて音声で具体的に伝えたり、スマートフォンのバイブレーションを使って示したりする。

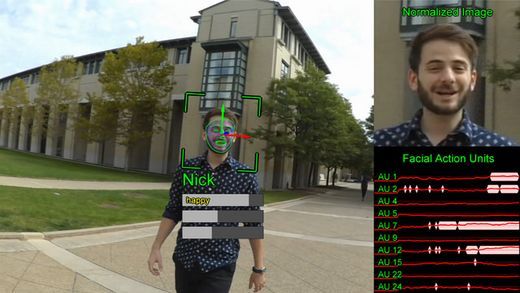

開発グループは、スマートフォンのカメラで撮影された物体を認識してユーザーに教える機能や、超音波センサとカメラを使って近づく知人を発見し、名前や表情から読み取った感情を伝える機能も追加したいとしている。

IBMフェローの浅川智恵子氏は、「私のような視覚障がい者は、オンライン活動なら自力でできるようになってきた。しかし、現実世界は今も困難な状況が続いている。より自立し、生活の質を向上させるには、ユビキタスな接続性を屋内と屋内に張り巡らさなければならない」と述べる。

さらに、同氏は「私の目標はキャンパス内を歩き回るだけでなく、旅行や映画、ウィンドウショッピングを楽しめるようになること」と話した。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

誰でも、かんたん3D空間作成

誰でも、かんたん3D空間作成

企業や自治体、教育機関で再び注目を集める

身近なメタバース活用を実現する

脱炭素のために”家”ができること

脱炭素のために”家”ができること

パナソニックのV2H蓄電システムで創る

エコなのに快適な未来の住宅環境

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス

データ統合のススメ

データ統合のススメ

OMO戦略や小売DXの実現へ

顧客満足度を高めるデータ活用5つの打ち手